前幾天的文章主要都是提到關於張量的計算以及將資料轉化為張量的相關內容,而在今天的學習中我想對深度學習裡,關於關於類神經網路的部分,寫一些關於讀過相關書籍和看過網路上大神們寫的相關文章後的個人學習心得,說到神經網路這個詞,就不得不提到激勵函數這個詞,而什麼是激勵函數在我完全沒有接觸過深度學習之前,我看到激勵函數這四個字,我會將激勵這個詞理解成是一種類似於獎勵的機制,而它的英文activation被翻譯成使某事開始或使其開始運作的行為,所以顯然的跟我的理解有些出入.

在多層的神經網路中,上層節點的輸出和下層節點的輸入之間有一個函數被稱為激勵函數.神經網路中激勵函數的作用主要就是將多個線性輸入轉換為非線性的關係.

下面是激勵函數的三個相關性質:

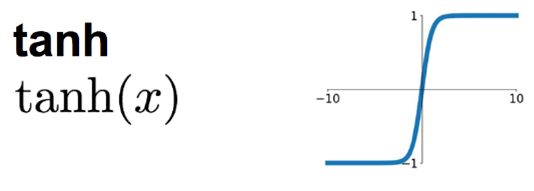

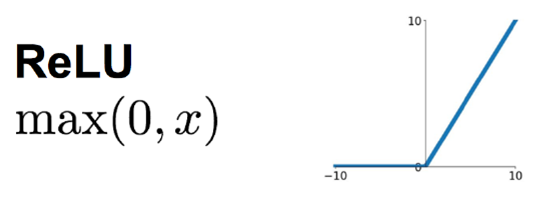

在不同的例子中,我們會使用到不同的激勵函數,像是在卷積神經網路(CNN)的卷積層中,會選擇使用ReLU這個激勵函數;而循環神經網路(RNN)中,則會選擇tanh或ReLU作為激勵函數.

Sigmoid 函數

tanh函數

ReLU 函數

Softplus函數