(因為只是複習用,如果非必要,就不解釋原理了)

所謂降維-降低維度,在機器學習中,簡單說 就是將特徵數量減少

舉個例子

在畫圖時 一個特徵(一維) 我們能記為

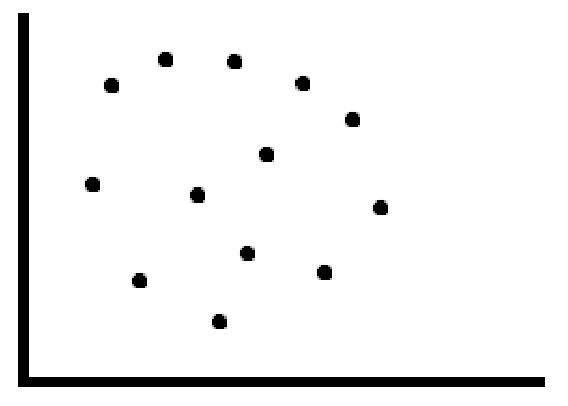

兩個特徵(二維) 能畫為

三維就需要動畫呈現 比較好看了

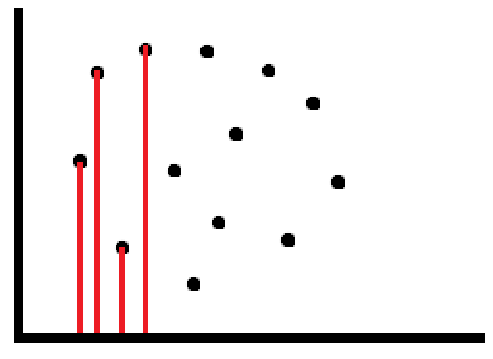

最基礎的降維概念,就是將高維度映射到低維度上,就像

本來需要二維才能進行詮釋的資料( (x,y) EX:(5,1)、(1,4)...)

變成只需要一維即可詮釋

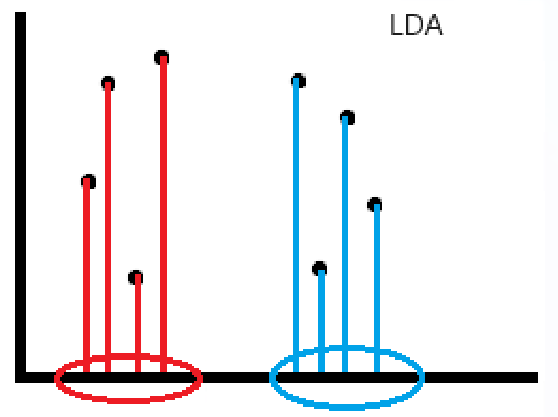

(也就是 有時高維的資料 可以在不損失基本資訊的情況下 使用較少變數進行描述。EX:常用的無監督PCA、有監督LDA,主要是偏重的重點不同,PCA主要是想保留變異量,是依據資料本身的分布,不在乎正確答案怎麼分的;但LDA 主要是為了讓資料能在降維後,數據點可以滿足最好的分類效果,也就是希望映射到低維度(降維)後 組間差異越大越好、組內差異越小越好)

(LDA:組內差異小-很靠近;組間差異大-離較遠)

(補充 深度學習的AutoEncoder 與 PCA蠻像的,尤其當自編碼器使用線性激活函數並且損失函數為均方誤差時,其實就等價於PCA。)