這一篇主要要介紹,如何在Hugging Face上挑選適合自己應用的開源AI模型。

面對上千個不同版本的Llama、Mistral、Gemma、Phi等等模型,

我們常會困惑:「它們到底有什麼差別?哪一個才適合我的專案?」

這篇就帶你一步一步拆解!

我們以llama為例,Hugging Face上最常見的模型之一,就是由Meta發布的Llama系列。

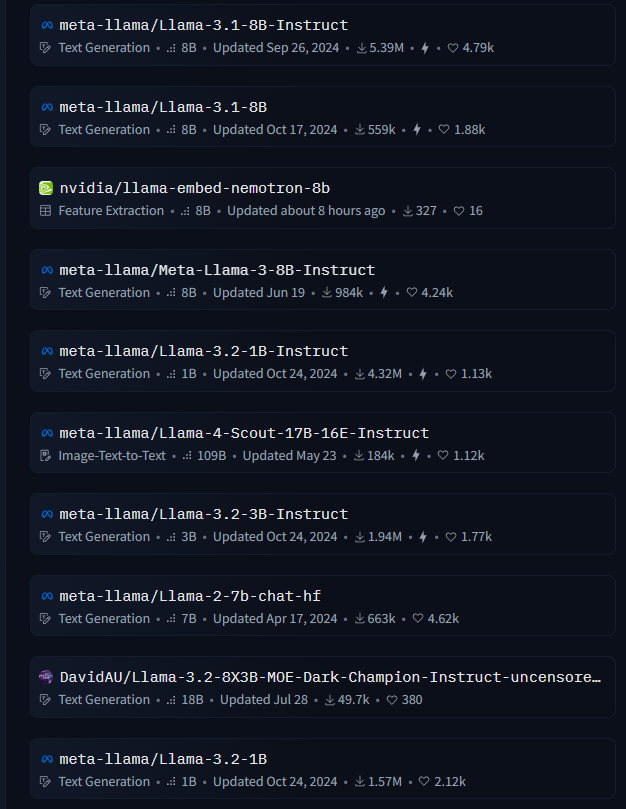

但如果你搜尋「llama」會發現結果一大串:

像是「Llama-3.1-8B-Instruct」、「Llama-3.1-8B」、「Llama-2-7b-chat-hf」

那他們到底差在哪?

事實上,Llama只是模型架構的名稱,而不是單一模型。

Meta在開源Llama後,任何人都可以根據它的架構與權重進行微調(Fine-tuning)、修改訓練資料或提示詞(Prompt),然後再發布到Hugging Face上。這就是為什麼我們會看到這麼多Llama開頭但內容各異的模型。

3.1、3.2就是模型的版本。

8B、70B就是模型的參數量,數字越大代表越精準、但需要更多運算資源。

(8 Billion,即80億參數)

小模型(1B~3B):輕量快速、適合個人應用或邊緣端。

中模型(7B~13B):平衡效能與速度。

大模型(70B 以上):精準度高,但需要 GPU 記憶體較大。

Instruct:代表這是指令微調模型,更適合處理prompt問答類任務。

Chat:表示模型針對多輪對話調整過,更擅長互動。

MoE:混合專家模型(Mixture of Experts),不同子模型分別負責特定任務,可提升推理速度。

BF16:模型運算精度(bfloat16),影響回答複雜度,在節省記憶體的同時維持精確度。

hf:生成能力較好(文章創作)。

GGUF:最原生,可重新編譯。

Whisper:表示模型內建語音辨識功能。

VLM:多模態模型(Vision Language Model),能同時辨識文字與圖片。

在實際專案中,我們往往不只使用一個模型。

例如在一個醫療客服系統中,可以同時配置:

一個模型負責辨識圖片(如X光影像)。

一個模型負責理解語音(如病人敘述)。

一個模型負責生成回答(如RAG回覆報告)。

這種多模型協作結構可以讓整體系統更靈活、專業度更高。