連假最後一天,讓人憂鬱的難以動筆。

這章節重點就介紹如何使用混淆矩陣(confusion matrix)來檢驗模型的好壞,這個矩陣在於二元分類的問題中,能夠非常有效的反映模型各方面的能力強弱,讓我們根據使用場景進行取捨與調整。

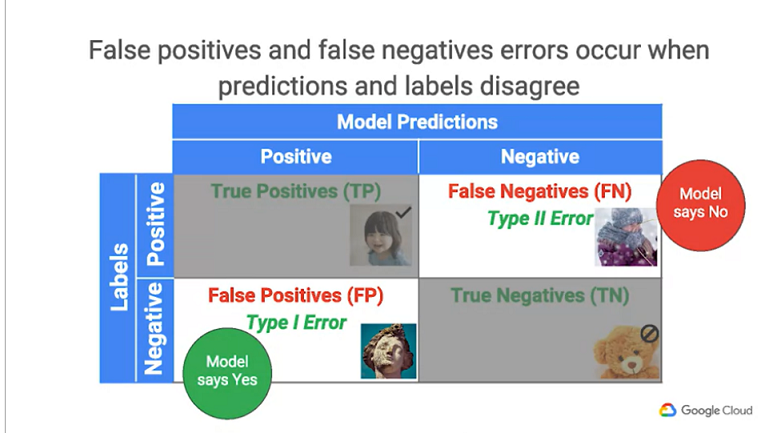

如圖,這個矩陣能夠分成四大區塊,每塊區域都是針對實際標籤(Label)與模型預測(Prediction)的一種交互關係,利用這樣的交互關係,檢驗模型在資料集上的表現。

首先,在Label的部分我們分成顯性(Positive)與隱性(Negative)。一般而言,我們會將要檢測的目標當作顯性,例如,疾病檢測的時候,帶有疾病是我們所想要檢測出的目標,因此,顯性(Positive)就會代表患有該疾病,而隱性(Negative)則是正常人;又或者今天想要訓練一款貓貓檢驗機來判斷圖像內是否有貓咪,那麼"有貓咪"是我們主要目標,因此,就會被歸類為顯性。

接著,當實際Label與模型預測的結果進行交互後,產生四個區塊:

針對顯性的資料,模型預測正確,代表著有成功檢測出目標,此數值的比例越高,模型的表現也會隨之提升,是影響模型的重要數值。

針對隱性的資料,模型預測正確,但通常比起True Positive,這項的影響力相對較低,因為隱性的資料通常比較不會是我們所關心的。

假顯性,這項代表實際為隱性的資料,被模型錯誤判別成顯性了,又稱作"Type 1 Error"。

對於那種寧可錯殺一百也不能放過一人的模型而言,此類型的錯誤殺傷力較低,舉例而言,醫療疾病的檢測,當你被錯誤當作有癌症的時候,或許進一步精密的檢測就能排除,但若是有癌症的人沒被檢測出來,造成的代價卻是非常大的。

假隱性,這項代表實際為顯性的資料,被模型錯誤判別成隱性了,又稱作"Type 2 Error"。

這是在醫療檢測中首要降低的數值,但對於某些情境,例如:工廠產線的檢測,由於生產流程中會有多道檢測手續,所以此項數值稍微高一點或許無傷大雅,後面仍會有機會檢測出來,但若是FP過高,常常產生False alarm,在自動化流程中會造成生產速度拖緩,降低產品產量,故在此情境下就會需要在FP與FN之間取得平衡。