哈囉大家好,我是橘白卯咪,歡迎大家來看看我能不能撐過30天

好像過了很久,竟然才撐過鐵人賽的三分之一

剩下三分之二繼續努力嗚嗚嗚![]()

在第8天有提到,如果行為辨識有特定的應用情境,資料集請優先考慮有特定主題的

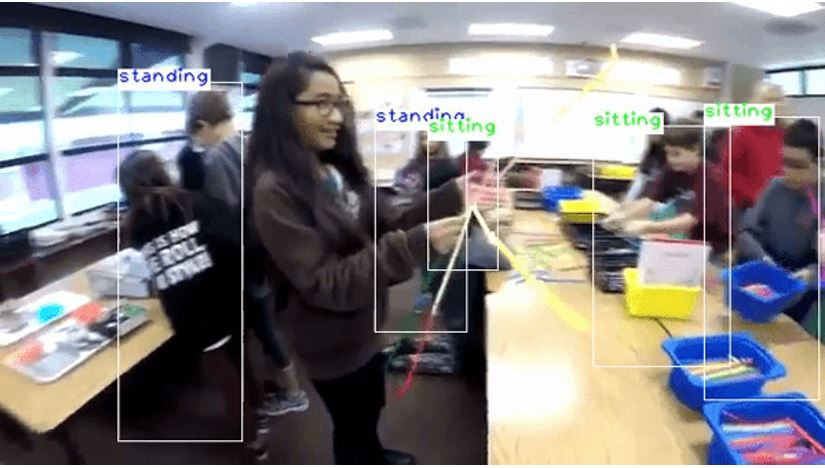

今天來介紹針對特定主題的行為辨識系統 openvino smart classroom

smart classroom顧名思義,是應用在教室相關的場景

openvino是intel推出的工具包,smart classroom是這個工具包當中的一部分

(這個工具包當中有相當多有趣的應用,可以執行來玩玩看~

ithome上對於openvino的介紹文

接下來介紹安裝步驟

作業系統: ubuntu 16.04

顯示卡: NVIDIA GeForce RTX 2070

Python = 3.6.

先照這篇的說明安裝好openvino(注意:解壓縮請用指令,點擊解開會有問題)

官方的文件最對味,當時懶得看英文,想說找找有沒有中文教學,結果繞了一圈還是官方最香~~

參考指令

#啟用圖形化介面安裝

sudo ./install_GUI.sh

#切換到預設安裝的路徑

cd /opt/intel/openvino/install_dependencies/

#將openvino環境開啟(這一步每重開一個終端機都要做)

source /opt/intel/openvino/bin/setupvars.sh

#到build_demos.sh所在的路徑下(每台電腦路徑不同,要找)

cd /opt/intel/openvino/inference_engine/demos/

#建立範例檔案

./build_demos.sh

#建立成功後會自動出現omz_demos,切換到路徑下

cd /home/omz_demos_build/intel64/Release

#找到smart_classroom檔案

pre-train model

下載完建議可將各模型放置於models資料夾(另外建立)

參考smart_classroom網址介紹

參考指令:

-m_lm models/landmarks-regression-retail-0009.xml \

-out_v videos/輸出結果影片名稱.avi \

-i videos/測試影片名稱.mp4

#說明:

-m_act: 放動作辨識模型的位置

-m_lm: 放場景辨識的模型的位置

-out_v: 影片輸出的檔名、副檔名及位置

-i :要讓系統讀的檔案位置

可發現雖然只有站著跟坐著兩種動作,但是判斷效果一般。

例如:只有照到半身的畫面會自動判斷為"坐著"(但影片中的大家都是站著...)

靠太近的人也無法判斷

明天繼續github尋神之路~關鍵的小夥伴要出現啦