時間過得非常的快,從我鐵人賽開賽到今天已經過了三分之一的時間了,這段時間裡我每天過著如鐵人一般被學習筆記追殺的日子(還敢說),但我認為我能堅持量產一篇相關技術方面的學習筆記值得給自己說一聲你很棒了XD,好了說完前面的閒聊之後,接下來我必須要說一些技術上的內容,在前兩天的文章中我主要提到關於神經網路中激勵函式的部分,而今天我主要想要學習神經網路另外一個很重要的部分損失函式.

在大部分的機器學習中的算法主要都是希望最大化或最小化一個函式或是指標,這個函式被稱為目標函式,而在深度學習中神經網路用到的目標函式指的都是損失函式.損失函式可以被分為分類與回歸兩個面相,而基本上與成本有關的問題,目標是將損失函式最小化.損失函式的損失就是「實際值和預測值的殘差(residual)」.

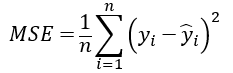

均方誤差(MSE)

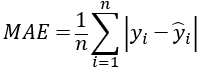

平均絕對值誤差(MAE)

根均方誤差(RMSE)