Day12 Google Dorking - part2

本次題目連結:https://tryhackme.com/room/googledorking

Robots.txt:

接續昨天的題目 SEO,今天我們探討「robots.txt」。

簡單來說 robots.txt 是一個檔案,這個檔案會規範來到你的網站的爬蟲的行為,像是有哪些頁面可以爬、哪些頁面不能爬。

我們會把 robots.txt 檔放在 test.com 的公開資料夾下,路徑會是 text.com/robots.txt。

如果你要檢視 hackerone 的 robots.txt,那你可以到在你的導覽頁輸入https://www.hackerone.com/robots.txt ,

你就可以看到 hackerone 的robots.txt 的內容。

robots.txt是一種規範,他會告訴你來到你的網站的爬蟲有哪些頁面可以爬、哪些不能爬。有以下幾種的使用時機

不讓爬蟲爬機密檔案

不讓爬蟲爬一些相對不重要的內容,避免消耗crawl budget

不讓不必要的爬蟲爬取你的網站,消耗網站資源

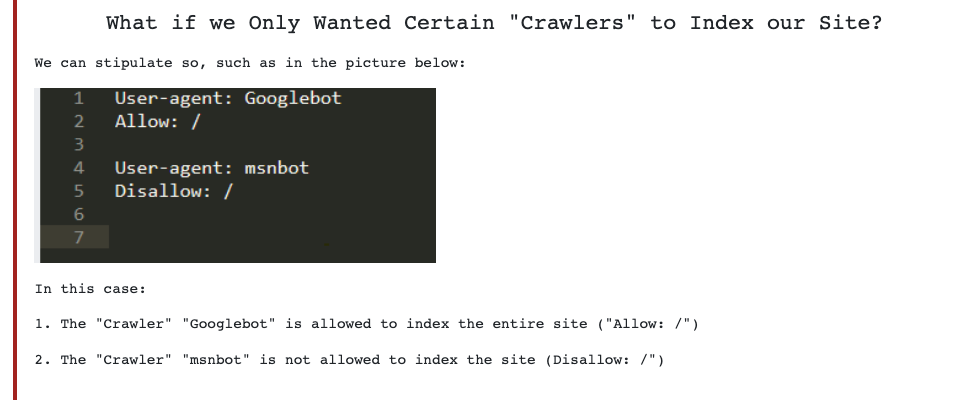

robots.txt 最常出現的三個單字分別為 User-Agent、Allow 還有Disallow。

User-Agent:爬蟲的名稱,像是Googlebot

Allow:允許爬蟲爬取的資料夾、頁面

Disallow:不允許爬蟲爬取的資料夾、頁面

前提概要完 robots.txt

我們可以來解第 4 題ㄌ

4.How would we prevent a “Crawler” from indexing the directory “/dont-index-me/”?

我們如何防止“爬蟲爬”索引目錄“/dont-index-me/”?

上面有提過 這時候我們可以用:Disallow

5.What is the extension of a Unix/Linux system configuration file that we might want to hide from “Crawlers”?

我們希望對“爬蟲”隱藏的 Unix/Linux 系統配置文件的擴展名是什麼?

Hint:“系統文件通常是 3/4 個字符!” 所以這意味著配置文件擴展名比通常的 config 縮寫略短

這題我看不太明白,有點不懂題目再問什麼

我就上網找解答 write up

解答是找到ㄌ

頂多是了解把 configuration 縮寫成 .conf

但我沒很懂為啥要這樣

理解的幫友麻煩在底下留言跟我說

感激不盡