attention即為注意力,人腦在對於的不同部分的注意力是不同的。需要attention的原因是非常直觀的,比如,我們期末考試的時候,我們需要老師劃重點,劃重點的目的就是為了盡量將我們的attention放在這部分的內容上,以期用最少的付出獲取盡可能高的分數;再比如我們到一個新的班級,吸引我們attention的是不是顏值比較高的人?普通的模型可以看成所有部分的attention都是一樣的,而這里的attention-based model對於不同的部分,重要的程度則不同。

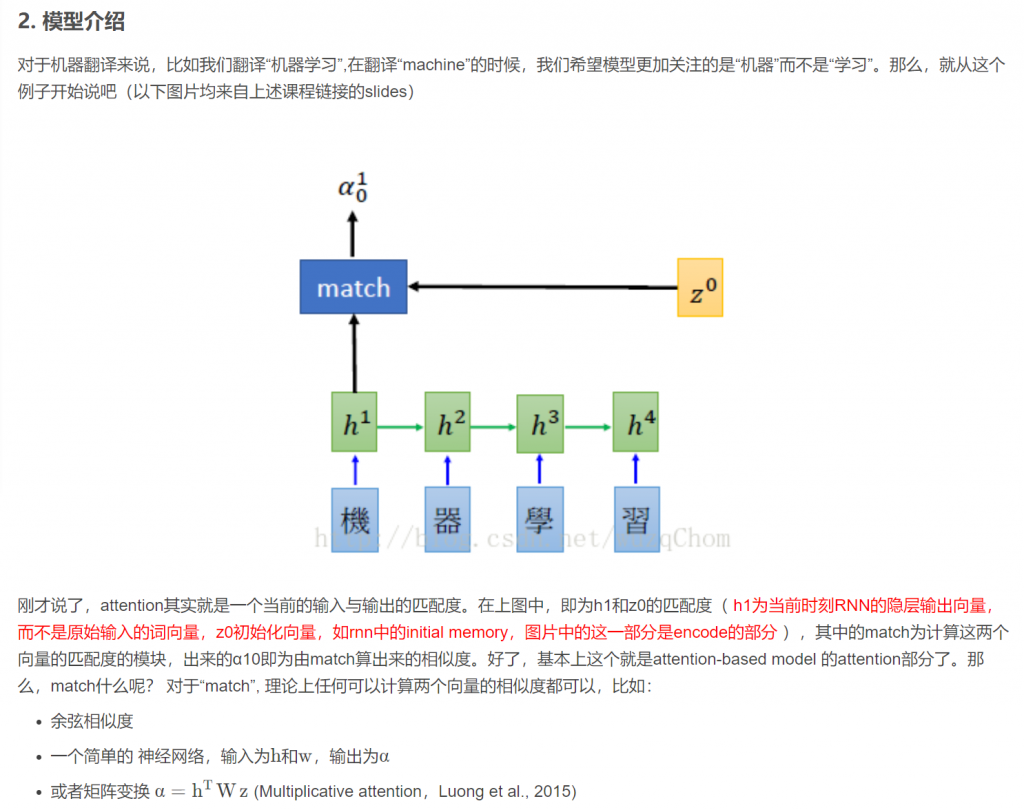

Attention-based Model其實就是一個相似性的度量,當前的輸入與目標狀態越相似,那麼在當前的輸入的權重就會越大,說明當前的輸出越依賴於當前的輸入。嚴格來說,Attention並算不上是一種新的model,而僅僅是在以往的模型中加入attention的思想,所以Attention-based Model或者Attention Mechanism是比較合理的叫法,而非Attention Model。