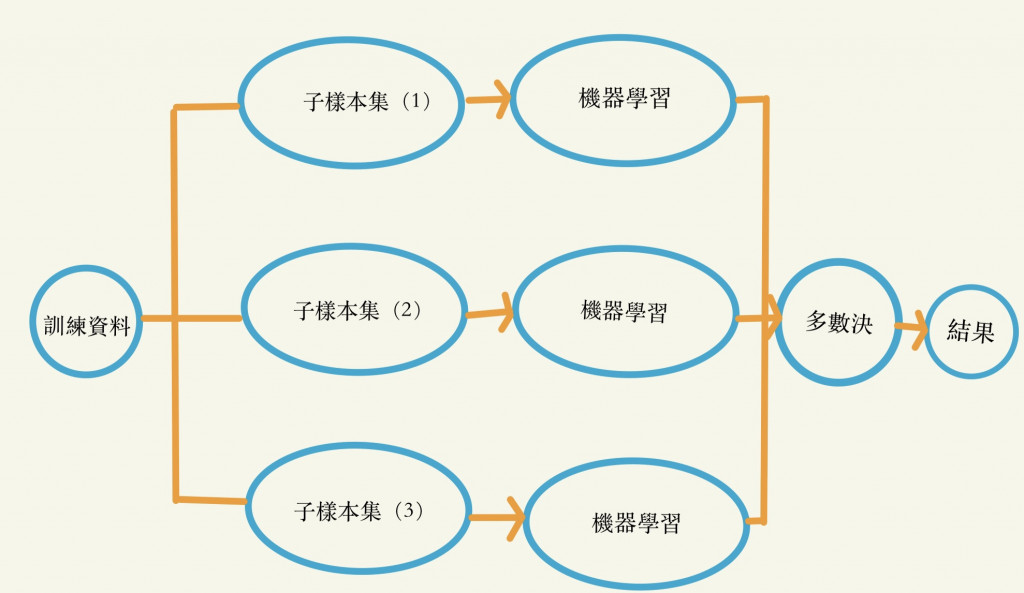

為了改善決策樹的缺點,因此專家們提出了更強大的集成學習法,而集成學習法就是指混和多種樣本、多種演算法,最終透過透票或加權的方式,來產生最後結過的一種混和型演算法。

袋裝法又稱引導聚集演算法(Bootstrap Aggregation)指隨機抽取不同子樣本集,經過隨機演算後,將答案以投票的方式決定的一種演算法。

袋裝法能夠降低樣本偏差、不平衡等問題,而隨機的演算法有可能為決策數、迴歸分析、SVM等等,例如:隨機抽取出50個子樣本集,利用決策樹演算法畫出50棵決策樹,最後透過平均值或多數決來決定最終的結果。

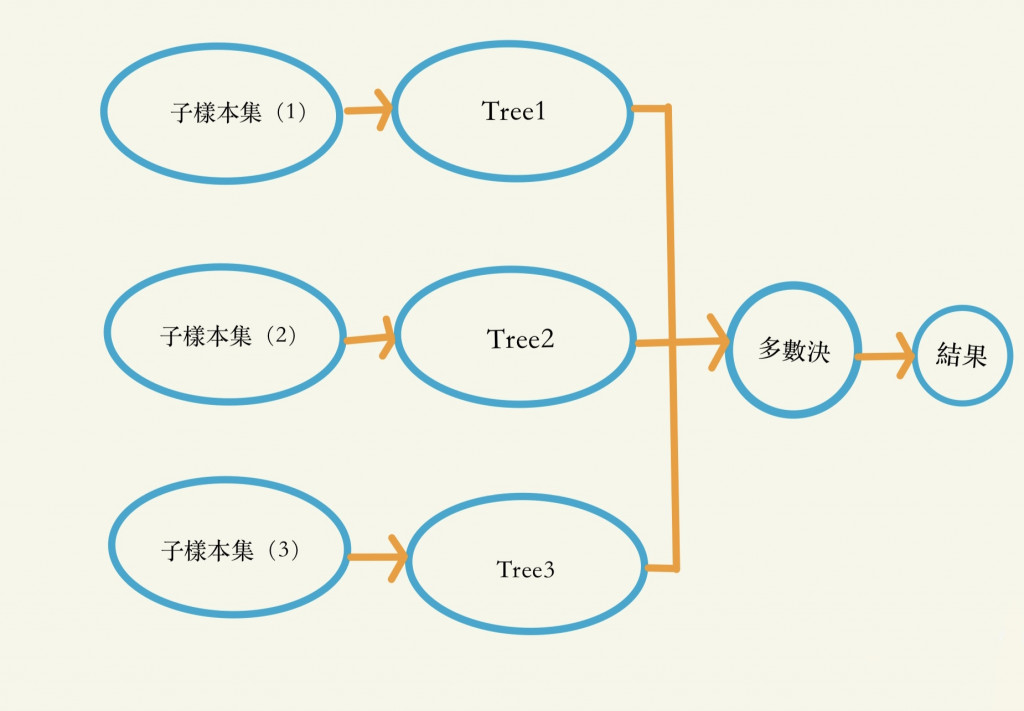

由於袋裝髮只解決樣本偏失問題,因此出現了隨機森林來解決特徵問題,隨機森林也可以說是袋裝法的進階版,所以也有人稱它為特徵版的袋裝法。隨機森林除了隨機抽取不同的樣本外,為了加強特徵的多樣性,每棵樹都從原來樣本的特徵中隨機選擇不同特徵子集合來建構演算法,這會使得每棵樹都為獨立且不相干,舉例來說就是多位不同的法官同時看各種不同角度的案件資訊,最後在綜合所有法官的判斷,比只看一個法官的判斷來的準確多。但猶豫他混合了各種不同的決策樹,因此可解釋性較低。

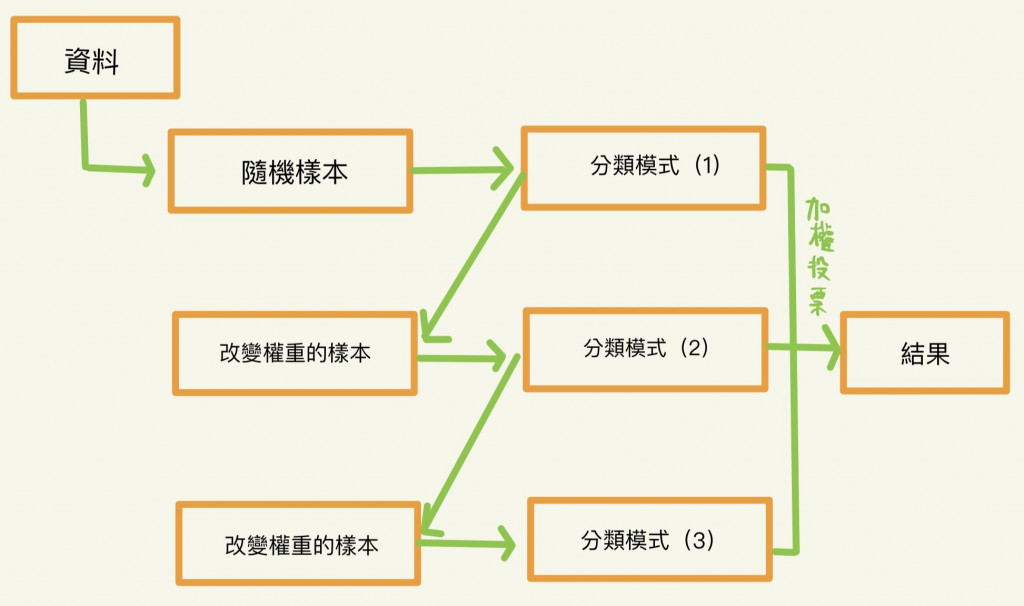

提升法指一種不斷從錯誤中改善模式準確度的一種學習法,其中最著名的為自適應提升法(Adaptive Boost)以下為他的主要步驟:

1.先創造一個淺層創造力弱的決策樹。

2.輸入資料後找出錯誤的樣本。

3.每個樣本都給不同的權重,錯誤越大的樣本,其權重愈高(主要目的為由錯誤樣本來改善模式)。

4.創造第二棵弱的決策樹,把不同權重資料再度輸入第二棵樹,以修正上次預測的錯誤。

5.重複執行2.~5.。

6.最後由過去每一次結果加權來得到最終的答案,正確率愈高的模式,其權重越高。

參考資料

人工智慧-概念應用與管理 林東清 著