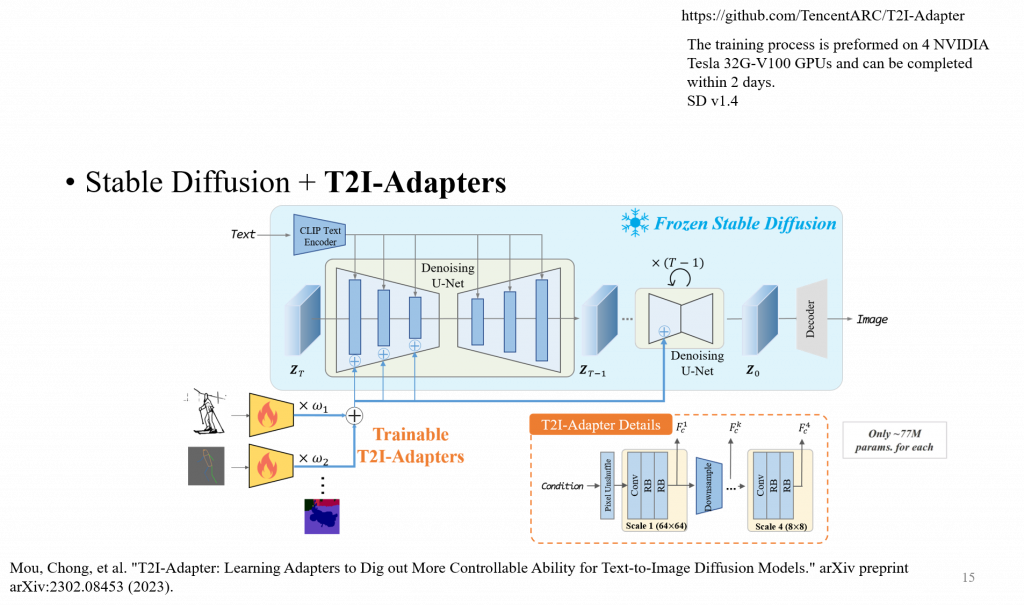

與前述Control-Net/Composer的出發點一致的是,希望通過更多,更細粒度的控制條件

它由4個特徵提取塊和3 個下採樣塊組成,

可能是怕在做 Conv 的時候位置關係會亂掉

這邊需要注意的是,不同的特徵維度要接入到對應的網絡層中

T2I-Adapter

我認為T2I-Adapter與ControlNet最大的不同點在於T2I-Adapter特徵輸入的地方在Encoder,而ControlNet在Decoder,我在其他篇論文中有看到對於特徵輸入的影響,好像都是在Decoder較多,但T2I-Adapter有實驗過才選擇在Encoder。

不過目前用FID評估指標去評估生成品質還是很不穩定,他無法準確的代表人類評估的品質。

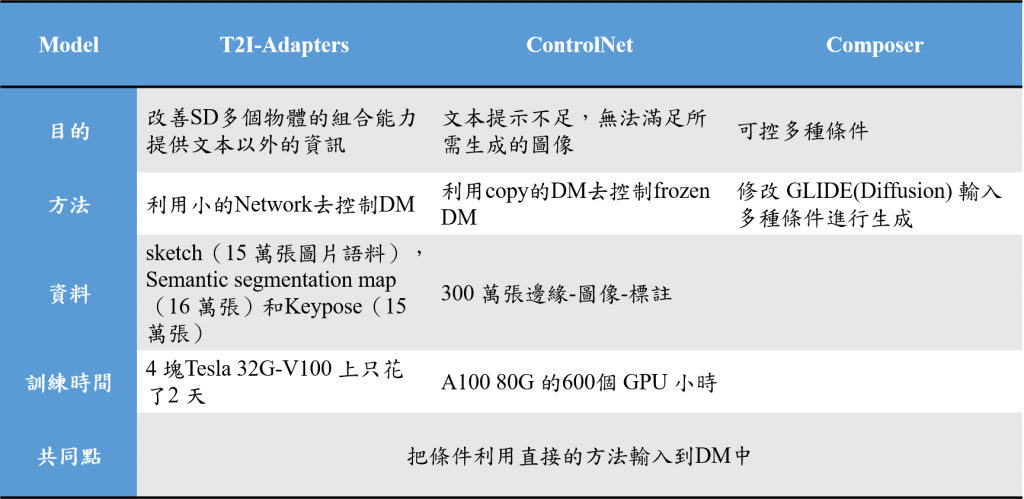

常有人把它和ControlNet進行比較,其實生成的品質也可以明顯看得出來,ControlNet帶來的細節都比Adapter好太多,可能ControlNet直接使用SD的架構去跟Frozen SD進行融合帶來的效果會比自己設計一個全新的Adapter來得好,但也可能因為Adapter的複雜度比ControlNet來說低很多才導致特徵提取得不是很好。個人認為有利有弊,看個人想要選擇怎樣的效能/結果。

這是整理過後的比較表,3種模型的差異

Composer因為沒有開源,所以不知道實際狀況,論文中也沒有提到相關資訊。