前一回介紹了關於 Data 系列的名詞後,可以得到以下粗略的行為:資料分析師的工作,打破資料藩籬、資料孤島,集中資料到資料湖,進行資料擷取、資料轉換、資料載入後,將處理過的資料擺放到資料倉儲或是關連式資料庫,並進行資料分析(Data Analytics),希望能夠預測未來可能會發生的事件。

關於資料分析師的首要任務,就是進行菜渣集中,收容資料是重要的第一步。

關於資料湖的定義中,包含了:

能滿足上述兩點的,幾乎就是在講 Amazon S3

只放一份、還擺在相同的 AZ,費用變成半價,延遲降低、變快速度變成十倍

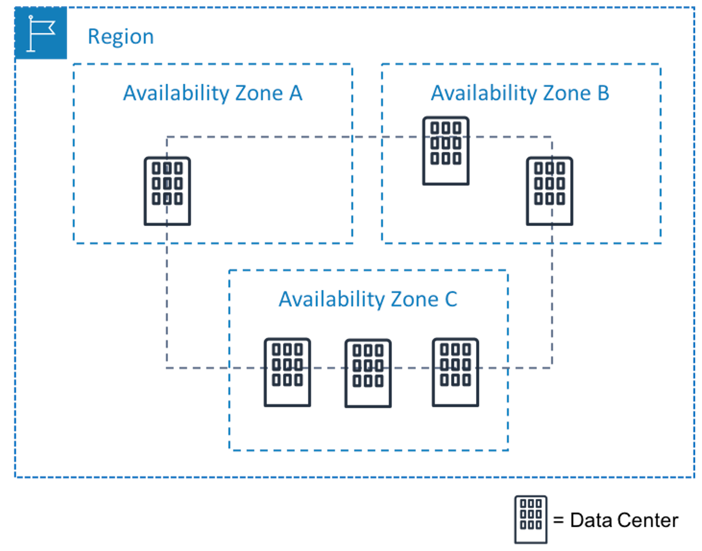

Amazon S3 設計可超過 99.999999999% (11 個 9) 的資料耐用性。 記住「十一個九的耐用性」,應該就差不多了。 反正一個 AZ 失效機率大概是 0.0005,條件機率,三個 AZ 一起失效的機率就是 0.000000000125,所以機率就是 1 - 0.000000000125