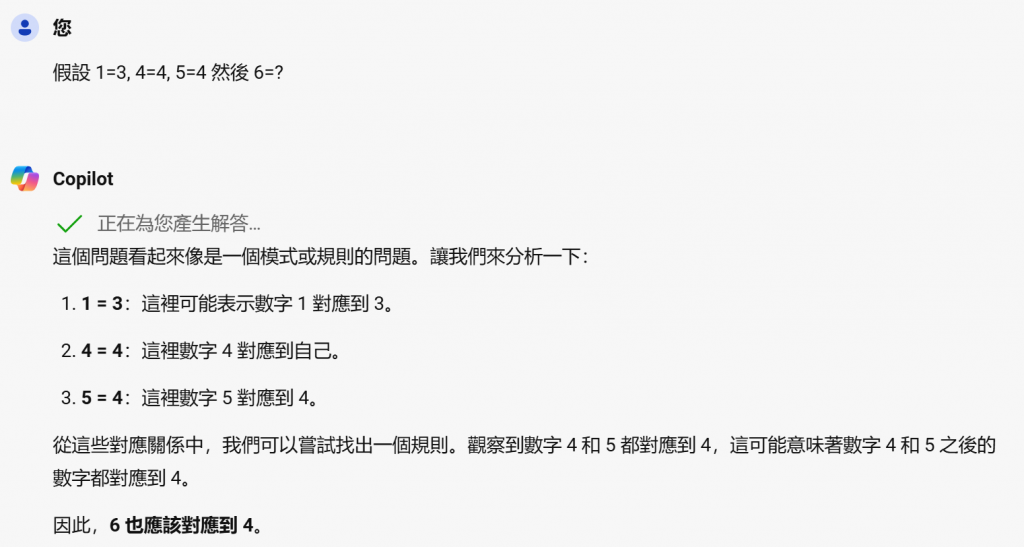

在還沒接觸GAI之前, 筆者一直認為現行的AI是不具備推理能力的, 但是做了底下範例之後, 有被GAI嚇到, 現在的LLM其實具備某種程度的推理能力, 我們來嘗試一下如何來教Copilot解題如下

在沒有給予任何的提示之下, Copilot會認為4跟5都等於4, 所以6有很大的機率也會是4, 但是這個時候若我們再給部分的問題與答案, 神奇的事情就發生了![]()

我們沒有明確告訴Copilot規則但是Copilot自己導出了規則, 而這樣教Copilot解題的步驟, 就是傳說中GAI界的COT(Chain of Thought), 中文翻成思維鏈, 它是一種Prompt技巧, 用於提升LLM在複雜推理任務上的表現. 這種技術的核心在於引導LLM逐步分解問題, 並在每個階段進行推理, 從而得到更準確的答案.

COT主要概念可以分成底下的兩個部分

*逐步推理:思維鏈技術鼓勵LLM在給出最終答案之前,先進行一系列中間推理步驟。這樣可以幫助LLM更好地理解和解決複雜問題。

*範例引導:在Prompt中提供一些範例,展示如何逐步解決問題。這些範例可以幫助LLM學習如何進行類似的推理。

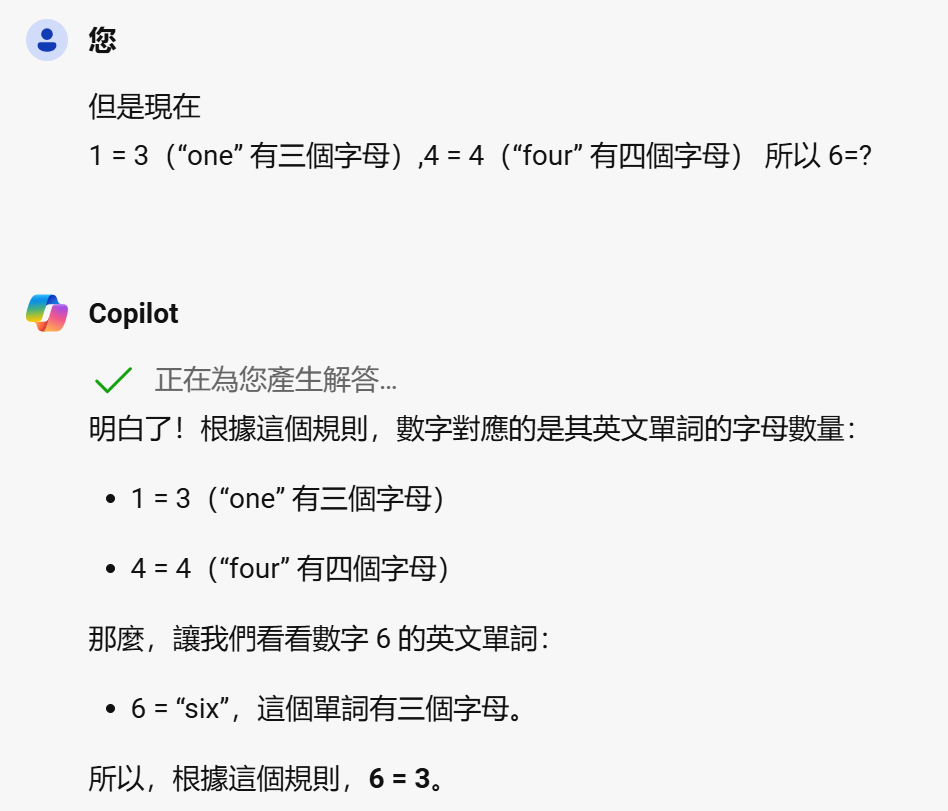

國外有很多研究COT的論文, 舉一篇研究結果(https://arxiv.org/pdf/2211.01910 )如下

這邊可以發現如果一步一步引導LLM得出正確結果有82%, 但是Zero-shot只有17.7%, 那甚麼是Zero-shot? 當我們使用簡單的一問一答方式時, 就稱之為Zero-shot. 在這種情況下, LLM依賴於其預訓練階段所獲得的知識來生成回應.就像 我們一開始提問” 假設 1=3, 2=3, 3=5, 4=4, 5=5 然後 6=?”, 而僅是這樣簡短的提問, 要處理邏輯問題得到的結果是最差, 這篇論文也提到一句關鍵的Prompt:

” Let's think step by step”

可以觸發LLM的思路分析, 然後一步一步去解題, COT也是在Day05溝通心法所提到的漸進式提問, 學會COT的技巧, 就再也不是GAI的門外漢了.![]()

https://www.facebook.com/groups/818139776290690

今年弄了個專頁, 歡迎加入討論, 可以收到貼文的更新通知![]()