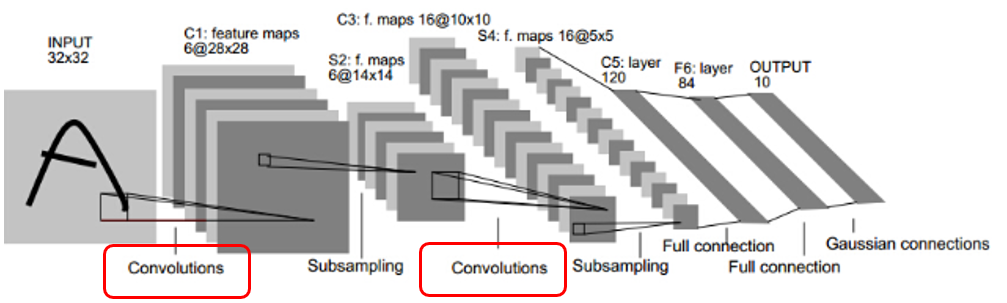

節錄自 此網站

在第一次convolutions後 feature maps為 6 , 因為kernel 為6

這個可以理解

但是第二次convolutions後 feature maps為 16 ,但 kernel 還是為 16

不是照理說應該要是上一層 feature maps為 6 再 乘上 這層 的kernel數 16 嗎?

以下是此篇文章作者解釋,但還是不懂 ![]()

為什麼會出現6張Feature map呢?

其實很簡單的去想,就是用6個”不同的卷積核”去對Input 做卷積

★深度 = 卷積核數量

第一個卷積層出來後的feature map為 6張,因為卷積核數量為6

第二個卷積層出來後的feature map為16張,因為卷積核數量為16

P.S. 這裡妳/你可能會想,第二次的卷積層出來的深度怎麼不是6*16呢?不是應該是每張圖做16個不同的卷積核卷積嗎?=>對於卷積核來說,是有深度的,看下面這張圖應該就很好理解,然而第二個卷積層就的卷積核就是有深度的,16個深度為6的卷積核,所以出來的feature map深度就是16

墾請各位大大解答,感謝

P.S. 現在對於 feature map 的理解是 經由 卷積 出來的一張圖