之前小弟是自學ELK的時候,一直不斷的詢問相關訊息,也依序迎刃而解,雖然中途花費不少時間,之前都是針對nginx-access log去處理

關於 ELK 之 Logstash Script 撰寫和 Elasticsearch 欄位問題 (感謝 raytracy 協助解決)

現在開始,進行關於Kafka的log獲取了,Google了一些方式後仍然無果,想上來諮詢一些方向,請大家指教指教

透過 Kafka安装启动入门教程成功安裝完後,便進行發送資訊測試

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

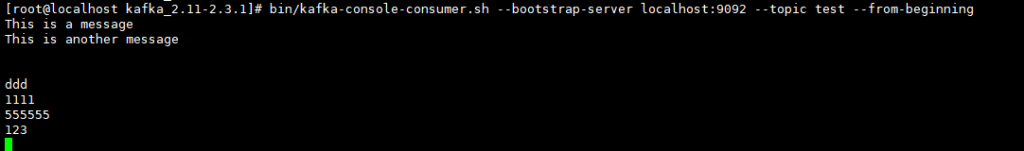

接收資訊測試

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test --from-beginning

環境架構:

172.16.16.1 ELK Server

172.16.16.2 Kafka

logstash配置如下

input {

beats {

port => 10516

}

kafka {

bootstrap_servers => ["172.16.16.2:9092"]

group_id => "test"

auto_offset_reset => "test"

consumer_threads => 5

decorate_events => true

topics => ["test"]

type => "bhy"

}

}

output {

elasticsearch {

hosts => ["http://172.16.16.1:9200"]

index => "dmservice-%{+YYYY.MM.dd}"

}

}

其實我認為我的logstash配置是有錯誤的,但是因為功力不夠的關係,一時之間並不曉得是哪裡出了問題

logstash 新配置如下

input{

stdin{}

}

output{

kafka{

topic_id => "hello"

bootstrap_servers => "172.16.16.2:9092" # kafka的地址

batch_size => 5

}

stdout{

codec => rubydebug

}

}

output {

elasticsearch {

hosts => ["172.16.16.1"]

}

stdout { }

}

結案