上一篇跟大家介紹到 CNN 的部分,本篇要來跟大家介紹 RNN 的概念,其實 RNN 很簡單,有點像是 CNN 的延伸品,但是又有點不像。

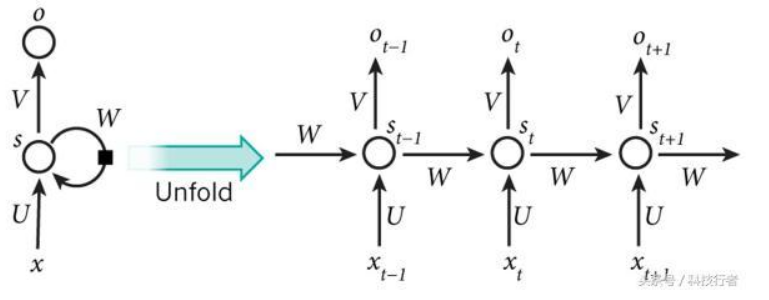

上圖為 RNN 基礎運作架構圖,RNN 到底怎麼運作的?其實他就是把資料重複地一直輸入,就是不斷的記憶,這個權重筆就會不斷的變高,例如說 Taiwan is good,他就是一直輸入 Taiwan is good Taiwan is good...不斷地進行訓練,直到最後他將整個句子可以完整念出或顯示出來為止,許多現在語言機器人會使用 RNN 來做,因為就是訓練自然語言的一種。

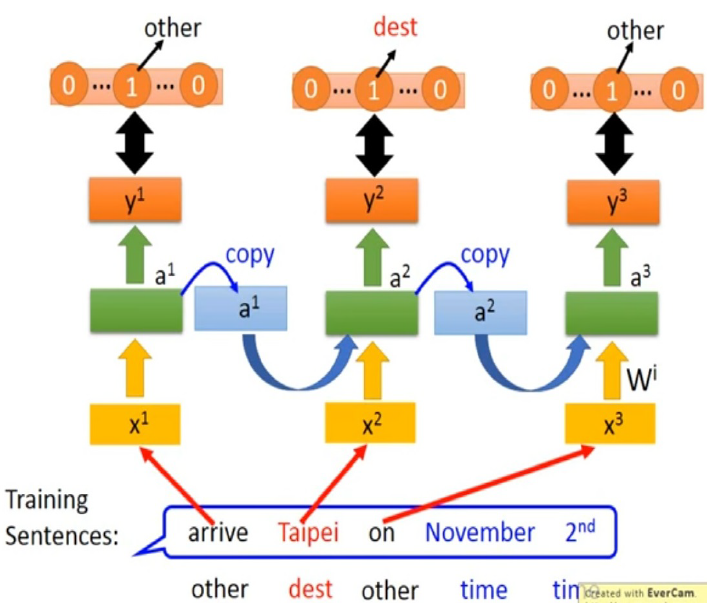

上圖為另外一種 RNN 的介紹圖,他示意就是說,今天一個語言進來的時候他會不斷地將前面的東西都收集起來,一起跟下一句進行訓練,它就是利用不斷的訓練跟記憶,讓自己強制記住這些語言到底在說什麼,但是他也不會刻意去懂這個意思是什麼,它的功能就是將句子記憶起來輸出就對了。

因此 RNN 功能性到沒有到很完全,後來出現了另外一種記憶方式。

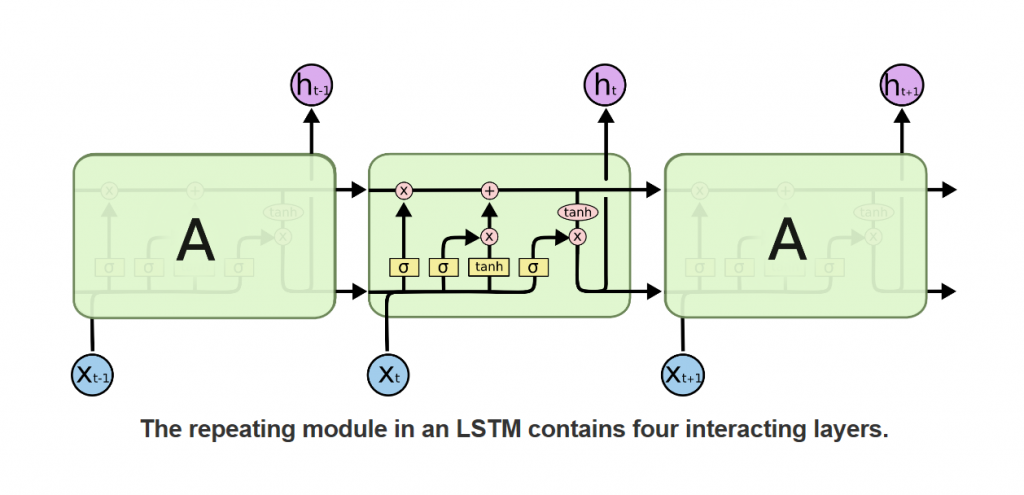

上圖為 LSTM 的架構圖,那麼這套架構圖他到底差異在哪裡呢,原本的 RNN 就是只有外圍的部分, LSTM 的技術是將每個記憶點他再內部又加上深層的記憶算法,讓自己成為長期記憶的方式進行,雖然這個方式相對消耗的資源會比較多,但是得到的資料卻是很永久性的,就像人類記憶物品一樣,有長期跟短期之分,RNN 就像是短期,LSTM 就是長期。

那麼先謝謝大家觀看,先讓大家吸收到這邊,下一篇我會從 LSTM 繼續介紹。

RNN 基礎介紹

RNN 基礎介紹-1

LSTM 基礎介紹

記憶是一條漫長的路,不可快,不可慢。