開始制作CreateML模型判斷情緒之前,先讓我們來認識用來抓取臉部資料的ARkit吧!這小小的工具可說是成就顏色APP的一大功臣呢!但在開發時,也有些限制要注意喔!

首先,什麼是ARkit呢?這是為了讓開發者在iOS裝置上得以建立一個AR app,在iOS11系統上,導入的系統框架。於Xcode11(含)以上的版本,皆可直接使用ARKit進行開發。

要注意在Xcode上使用ARKit開發時,無法使用內建的模擬器測試。必須使用具有A9處理器(或以上)的裝置才能正常運行,以下為可使用的裝置:

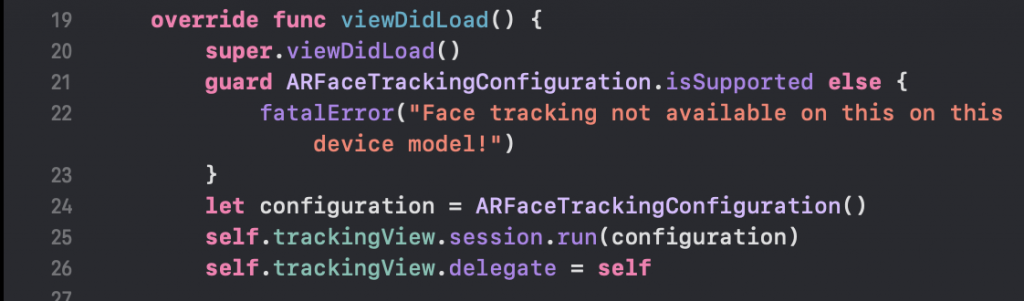

ARkit具有眾多功能可供使用,其中臉部追蹤功能(ARFaceTrackingConfiguration)與原深感測鏡頭(True Depth Camera)即可辨識臉部五官的位置。而因爲需要具備原深感測鏡頭,故並非所有裝置都可以使用,需要iPhone X(含)以上的裝置才可以使用。

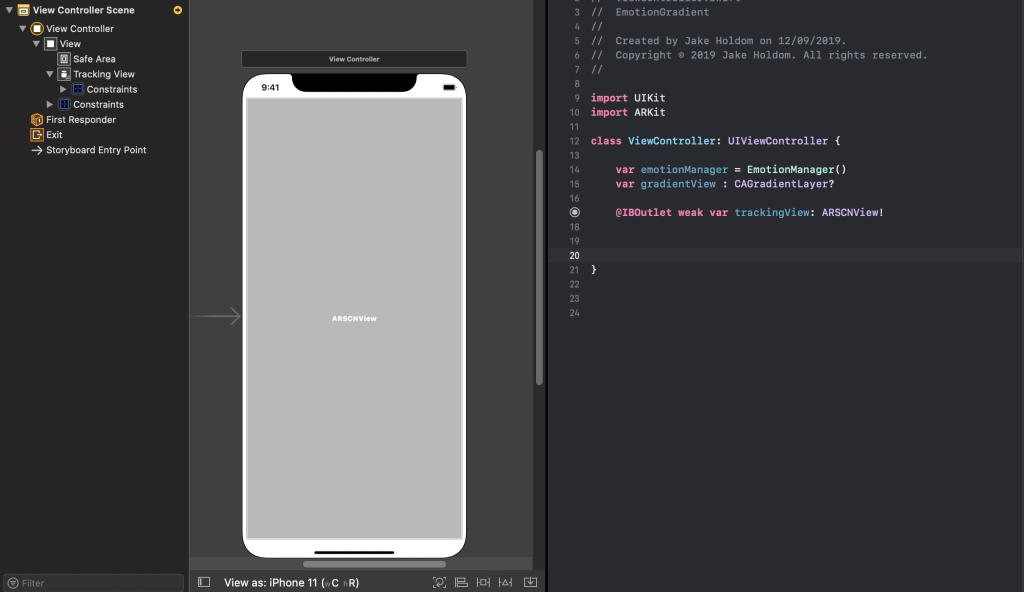

在main.storyboard中新增一個ARKit SceneKit View,並為其設定大小,在這個視窗我們可以看到前鏡頭照射到的影像。而程式的部分則需要import ARKit。

加入臉部偵測功能的程式碼即可偵測臉部位置。搭配前面提到的用ARFaceAnchor判斷表情(上)與用ARFaceAnchor判斷表情(下)便可即時判斷五官表情。

進行開發時,ARKit的測試限制一定要注意,否則就會一直無法順利執行喔!