前面講述了許多關於RNN循環精神網路的優點,不同於一般精神網路的優點,甚至比一般精神網路還要好的能力,卻不代表他沒有缺點。

RNN的致命缺點

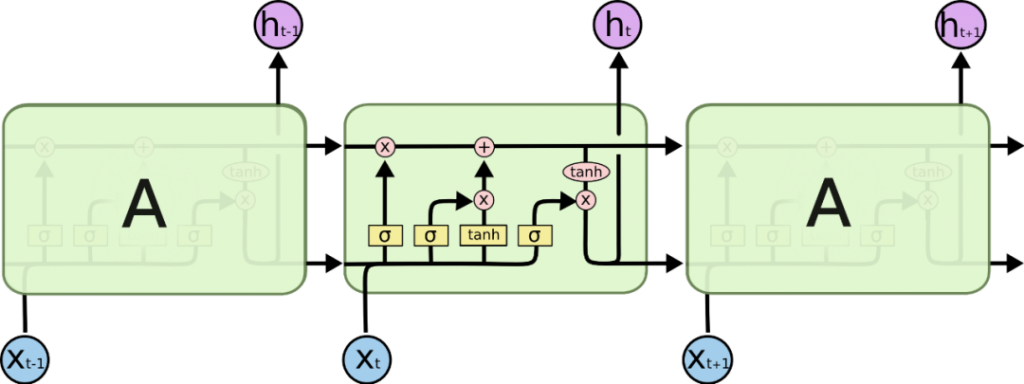

梯度消失問題(Vanishing gradient problem)

梯度消失問題是一種機器學習中的難題,出現在以梯度下降法和反向傳播訓練人工神經網路的時候。在每次訓練的迭代中,神經網路權重的更新值與誤差函數的偏導數成比例,然而在某些情況下,梯度值會幾乎消失,使得權重無法得到有效更新,甚至神經網路可能完全無法繼續訓練。

而為什麼RNN會發生梯度消失的問題呢? 這就是因為他訓練的方式是使用Back Propagation Through Time。因為小空間的歷史資訊太長了,RNN所使用的訓練方法並不是之前所提到的反向傳播法(BP, Back Propagation),而是進階版本的Back Propagation Through Time,與BP不同的地方就在於BPTT是透過時間來進行訓練的。

資料參考:

https://www.gushiciku.cn/pl/p5ok/zh-tw

https://zh.wikipedia.org/wiki/%E6%A2%AF%E5%BA%A6%E6%B6%88%E5%A4%B1%E9%97%AE%E9%A2%98