本篇章之後將進入爬蟲環節,但開始撰寫程式前,我們先來安裝會使用的套件吧!

本系列文將使用 Requests,是一個基於 urllib3 為基礎開發的套件。簡單說 Requests 是一個把 urllib3 重新包裝過的套件,讓它能更簡單更容易地被使用這樣。

雖然本系列文是使用 Requests,但基於個人喜好,未來你也可以選擇使用自己喜歡的套件來當作爬蟲工具。

Requests 官方文件

開始前有一個重點,使用任何第三方套件前,請務必一定要閱讀該套件提供的文件,像是 Quick Start 、 Basic Use 、 FAQ,至少看完這些把基本概念搞懂,對該套件就差不多掌握一半了。如同本系列文,我們爬蟲實戰前,是先從網路的基礎知識開始講起,理由很簡單:任何複雜的事物,都是從基礎延伸、變化而來的。

好的廢話不多說,我們開始吧!

安裝方法很簡單,根據官方提供的有兩種:

官方安裝方法

使用 pip 安裝

python -m pip install requests

自行下載 Source Code

(1) 至 Github下載

git clone git://github.com/psf/requests.git

(2) 或是下載 tar 檔

curl -OL https://github.com/psf/requests/tarball/main

# optionally, zipball is also available (for Windows users).

下載完成後,進入 requests 資料夾來手動安裝。

cd requests

python -m pip install .

安裝完成後我們來簡單的測試吧!

import requests

import logging

# log 設定

logging.basicConfig(level=logging.DEBUG)

# 向 google.com 送 HTTP Request

r = requests.get("https://www.google.com/")

檢查:

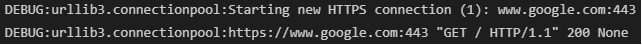

如果是這樣就沒問題囉!

以上就是我們的事前準備!