實作 -『如何啟用 WAF日誌以及匯入 BI 進行分析』,

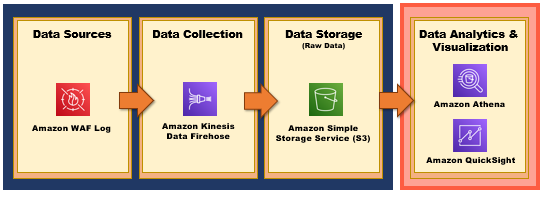

Data Analytics Pipeline 如下圖所示:

那我們就開始吧 GOGO

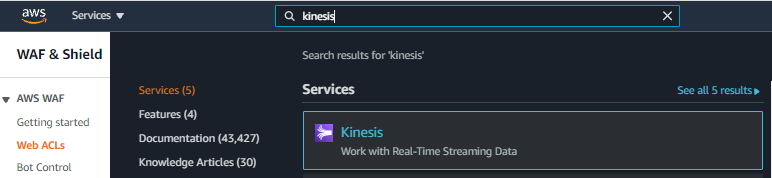

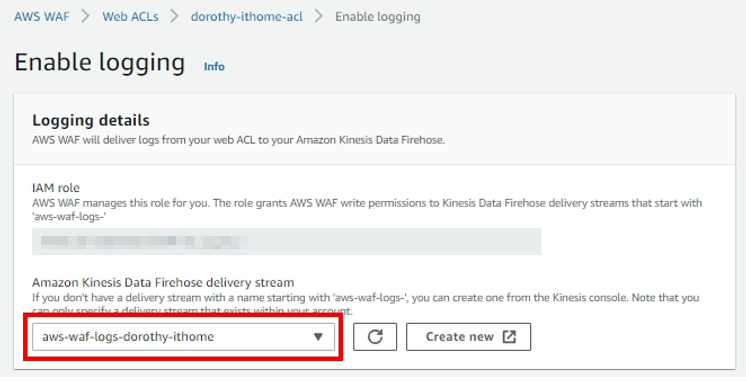

這時候大家可能有些人會找不到先前創建的 Kinesis,原因可能有以下兩種:

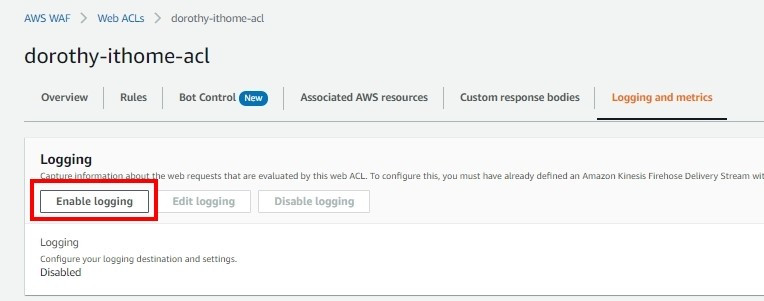

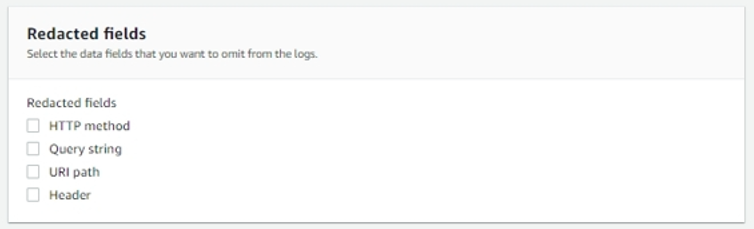

Redacted fields:可以將 Logs 中的特定欄位加密變成密文,舉例來說:如果我勾選 URI path 欄位,那麼此欄位就不會顯示原始內容,而是 xxx 的紀錄

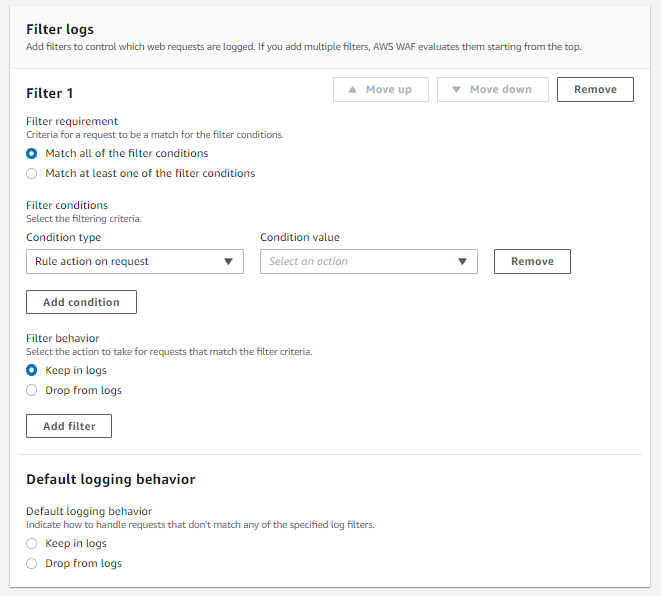

Filter logs:可以設定要記錄/不記錄哪些內容並傳到 AWS Kinesis Data Firehose,這邊我們選擇不增加篩選條件

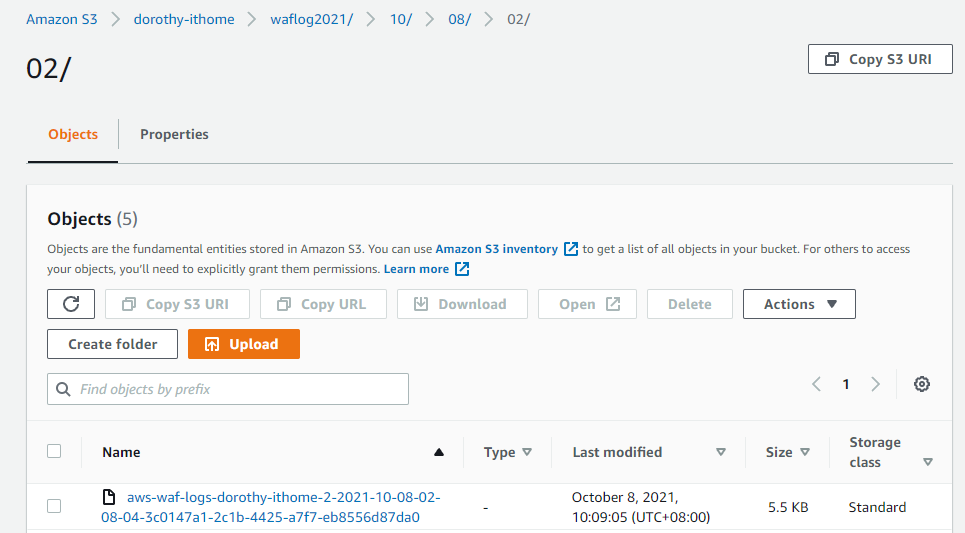

接著按下儲存,之後就會看到 AWS S3 有出現相關資料了~

現在我們已經成功將資料源『 WAF Log 』透過 AWS Kinesis Data Firehose 服務將 Log 儲存到 AWS S3 中,接下來我們就會針對 WAF Log 進行資料分析以及視覺化的部分,那就明天見囉 : D ~

如果有任何指點與建議,也歡迎留言交流,一起漫步在 Data on AWS 中。