鐵人賽持續到現在也過了一半的時間,換作是從前我根本不敢想像我能夠每天堅持發表一篇技術方面的學習心得,雖然一開始是很心不甘情不願的,但因為課程因素參加了今年的鐵人賽過後,我獲得了相當多的收穫,不再只是吸收學校課程中所教的內容,而是而外的自我學習,相信這有助於我往科技人更邁進一步.

今天所提到的迴歸分析主要是應用在統計學的領域中,主要是用於了解兩個以上的變數是否有其關聯性,建立數學模型用來觀察特定變數來預測變數.

import torch

import matplotlib.pyplot as plt

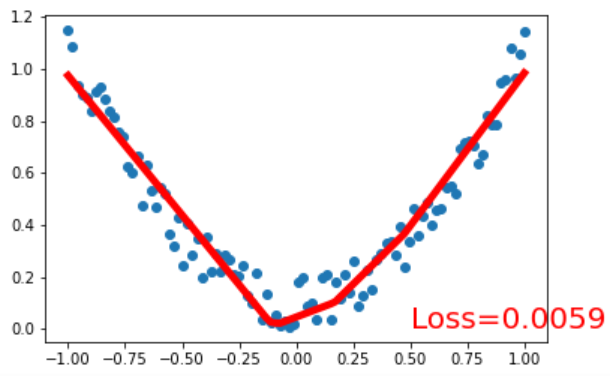

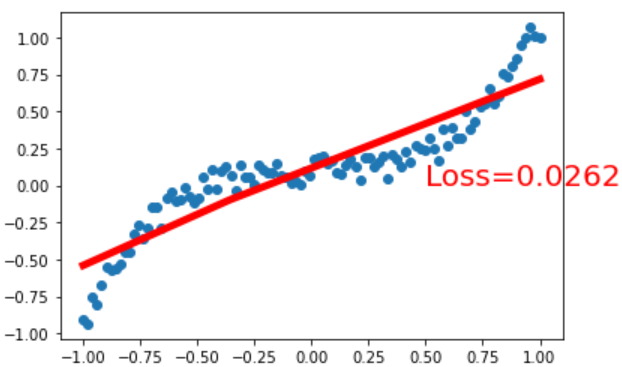

x = torch.unsqueeze(torch.linspace(-1, 1, 100), dim=1)

y = x.pow(2) + 0.2*torch.rand(x.size())

plt.scatter(x.data.numpy(), y.data.numpy())

plt.show()

import torch

import torch.nn.functional as F

class Net(torch.nn.Module):

def __init__(self, n_feature, n_hidden, n_output):

super(Net, self).__init__()

self.hidden = torch.nn.Linear(n_feature, n_hidden)

self.predict = torch.nn.Linear(n_hidden, n_output)

def forward(self, x):

x = F.relu(self.hidden(x))

x = self.predict(x)

return x

net = Net(n_feature=1, n_hidden=10, n_output=1)

print(net)

optimizer = torch.optim.SGD(net.parameters(), lr=0.2)

loss_func = torch.nn.MSELoss()

for t in range(100):

prediction = net(x)

loss = loss_func(prediction, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

import matplotlib.pyplot as plt

plt.ion()

plt.show()

for t in range(200):

loss.backward()

optimizer.step()

if t % 5 == 0:

plt.cla()

plt.scatter(x.data.numpy(), y.data.numpy())

plt.plot(x.data.numpy(), prediction.data.numpy(), 'r-', lw=5)

plt.text(0.5, 0, 'Loss=%.4f' % loss.data.numpy(), fontdict={'size': 20, 'color':'red'})

plt.pause(0.1)