廢廢雖然得到了新啟發,但是訓練效果依舊不好。現在就試看看各種方法了,比如:更改kernal size的大小、激活函數(activation function)、增加卷基層、更改filter(output size)、步長(strides)、dropout、正則化(regularizer)、優化函數、batch size,以上是廢廢目前所能做的所有的改變了,成效不彰。

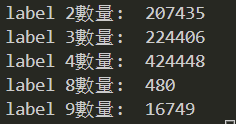

廢廢頭又要禿了,這禮拜的目標依舊是改善訓練,順便附上差距很大的數據機集,label 4幾乎占了一半的資料:

現在廢廢考慮將label 8刪除,他簡直少到我步知道放這個下去究竟會不會影響訓練,所以廢廢目前分裂出沒有label 8的數據集來測試會不會讓訓練效果更好。

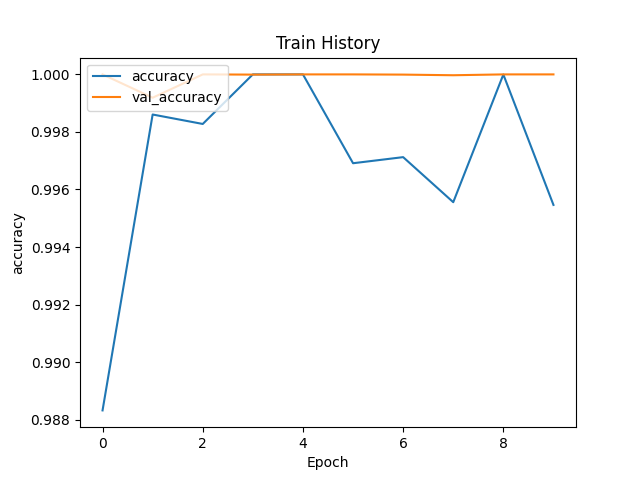

最後廢廢附上更詭異的loss和accuracy吧,異常平坦的測試集曲線,讚讚:)