預訓練模型是深度學習中極為強大的工具,特別在自然語言處理領域的各種任務上表現優秀。這種模型事先通過大量的文本資料進行學習,然後在應用到具體文本任務時,只需進行微小的權重調整,就能使模型展現出卓越的性能。簡單來說預訓練模型可以使我們在自然語言處理任務中輕鬆取得出色成績。

接下來會解說預訓練模型的一些基本概念。

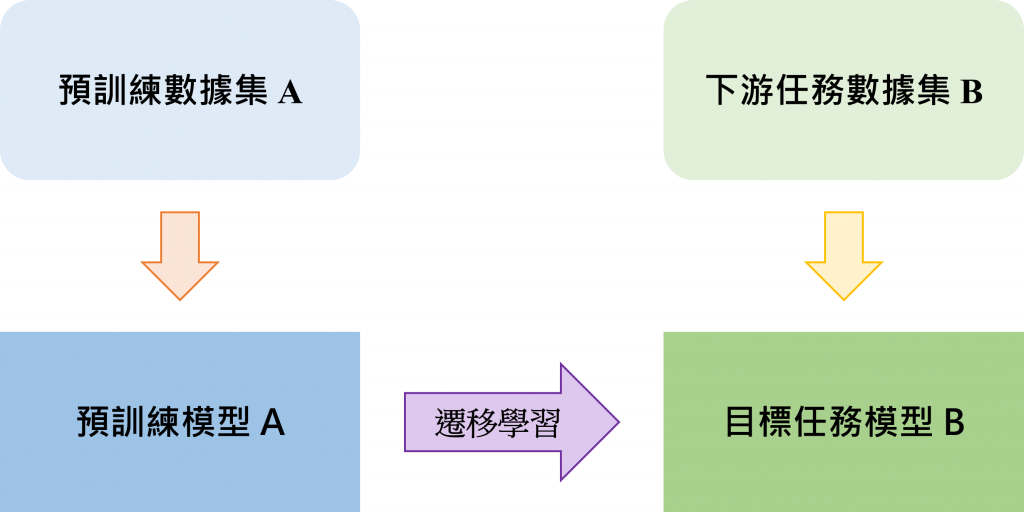

說到預訓練模型最為基礎的技術就是遷移學習(Transfer Learning),什麼是遷移學習勒?

遷移學習是一種機器學習的,其核心思想是將在一個任務上學習到的知識和經驗轉移到解決另一個相關或不相關的任務上,以改善模型的性能。遷移學習的目標是通過利用已有的知識,來幫助模型在新的任務上更快速、更有效地學習和表現。

簡單來說就是將模型先使用A數據進行學習後,再針對目標任務中的B數據進行訓練,會遠比讓模型直接學習B數據的情況來得更好。舉例來說假設我們已經訓練完一個可以進行貓狗辨識的模型,現在我們要改為辨識馬和兔子,但馬和兔子的數據較為有限,這時可以將現有的貓狗辨識模型權重進行載入,然後再用馬和兔子圖片數據進行訓練,訓練過程中模型會調整參數來適應新的任務,這樣做能夠擁有節省時間和資源的好處。!

根據上述對於遷移式學習的解說就可以了解到預訓練模型的產生,一般的預訓練語言模型都是讓模型事先經過大量數據的訓練後,再針對模型的權重進行微調,就可以用更快的速度和更節省的資源獲得一個效果不錯的模型了。

今天是針對遷移學習和預訓練模型之間的關係,所以就並沒有說的太多,明天會接著解說預訓練模型中的基礎架構Transformer。今天就先說到這裡謝謝大家。