今天要介紹的模型是在 U-Net 模型的基礎上進行改進,它叫做 Attention U-Net![]()

來稍微回顧一下昨天的文章,我們提到了 Unet++ 會通過對 U-Net 的層數和 Skip Connection 做調整,以提高性能

而今天,要來分享的 Attention U-Net 則是針對 U-Net 的另一個問題進行了改進:

U-Net 架構的設計會依賴 multi-stage cascaded convolutional neural networks 來運作,這些聯級框架會用於提取感興趣的區域以進行預測,然而,這種方法可能會導致計算資源的浪費,因為它提取的低階特徵會有很多不需要的資訊,原因是一開始提取的特徵可能不夠精確

Attention U-Net 希望讓模型著重在自動對焦學習不同形狀和大小的目標結構上,而不是像 U-Net 那樣完全依賴聯級卷積

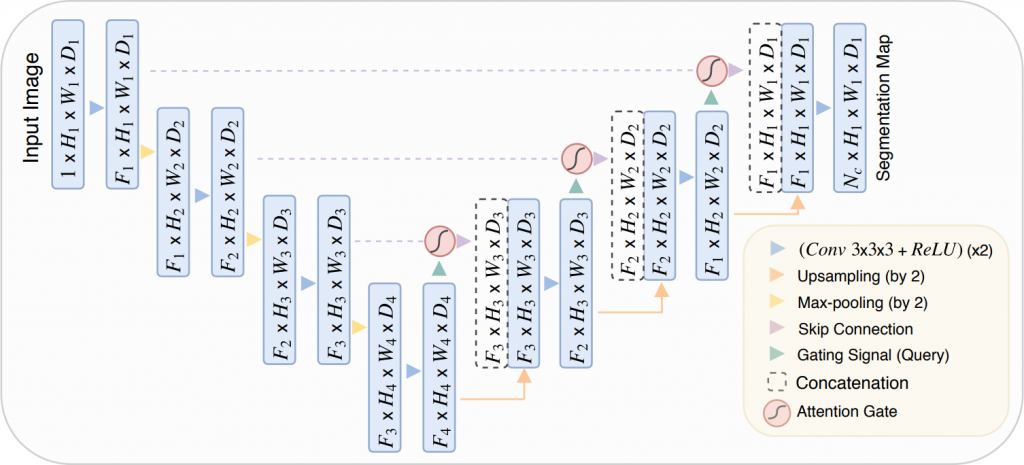

Attention U-Net 在 U-Net 模型架構中的 Skip Connection 處都加入了一個 Attention Gate(AG),以便特別著重於訓練相關重要區域,減少在不相關部份上的計算,來提高模型的靈敏度和準確性

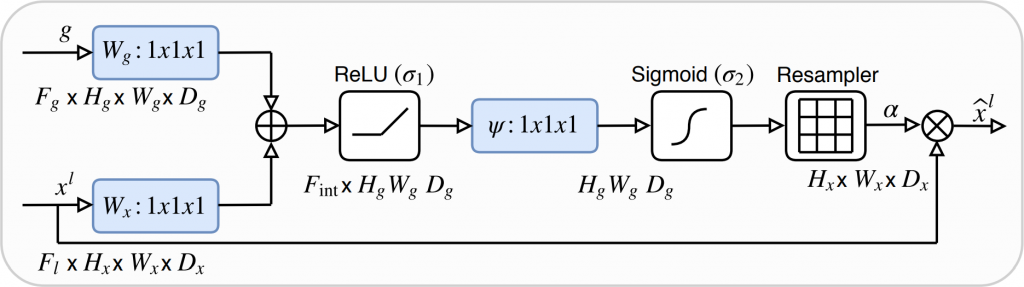

會有 2 個特徵圖當作輸入,分別通過 1×1×1 的卷積層後,將提取的特徵加在一起(讓特徵更為突出)進行 ReLU,接著再次執行 1×1×1 卷積,然後這次使用 Sigmoid 作為激勵函數,這個 Sigmoid 層會產生 Attention 係數,係數越接近 1 就表示相關性越高,將這些係數通過 Resampler,也就是三線性內插(trilinear interpolation),讓 Attention 係數上採樣到與原始特徵圖的大小一致,以便按元素順序與原始特徵圖相乘,來根據相關性縮放特徵,最後將結果做輸出

Attention U-Net: Learning Where to Look for the Pancreas