此為《GPT-4V 微軟評測報告 》第三章實測

這是我們【GPT-4V 研究報告的研讀及實驗心得分享】的第一篇驗證心得分享,也算是我們第一則正式的電子報,所以在正式撰寫心得前,著實讓人思考了許久,該如何編排、表達,才能夠讓讀者感覺有所收穫,同時理解我們實驗時的感受,而這一篇的結構,也就是我們後來感覺比較適合的編排及表達方式,如果你個人有任何的想法,很歡迎給予我們意見。

另外,如果您喜歡我們這樣的內容,很歡迎到這裏訂閱我們的電子報,我們接下來的內容會在這裏優先發佈: ChatGPT 落地研究 | Ted (substack.com)

在正式分享我們的驗證記錄與心得前,先跟大家介紹幾個 GPT-4V 的圖像提示技巧。

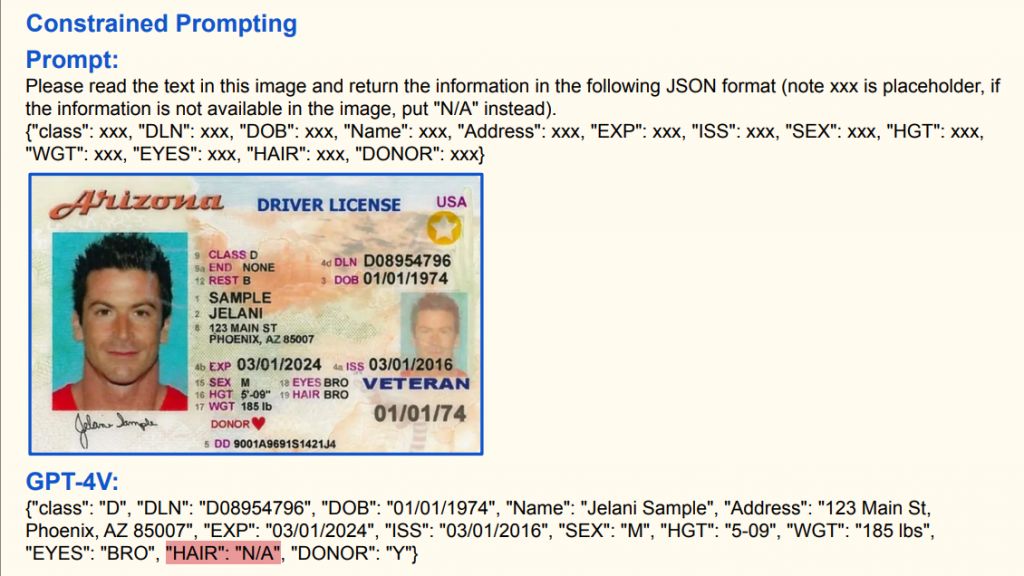

請閱讀此圖像中的文字,並將訊息以下方的JSON格式返回(注意xxx是佔位符號,如果圖像中沒有相關訊息,請填入"N/A")。

{"class": xxx, "DLN": xxx, "DOB": xxx, "Name": xxx, "Address": xxx, "EXP": xxx, "ISS": xxx, "SEX": xxx, "HGT": xxx,

"WGT": xxx, "EYES": xxx, "HAIR": xxx, "DONOR": xxx}

--- GPV-4V 的回覆 ---

{"class": "D", "DLN": "D08954796", "DOB": "01/01/1974", "Name": "Jelani Sample", "Address": "123 Main St,

Phoenix, AZ 85007", "EXP": "03/01/2024", "ISS": "03/01/2016", "SEX": "M", "HGT": "5-09", "WGT": "185 lbs",

"EYES": "BRO", "HAIR": "N/A", "DONOR": "Y"}

黃色指針大約在80和100 mph之間的中間位置。80和100的中間是90。而且因為指針剛剛超過了90 mph,所以速度大約為91 mph。

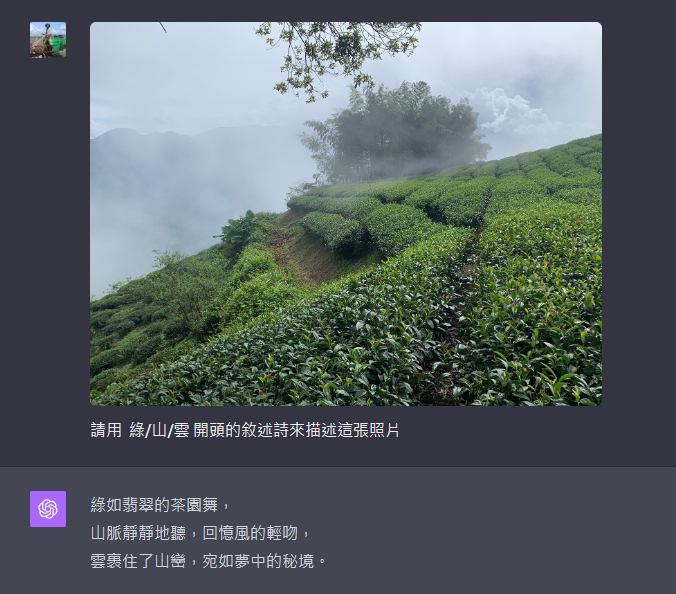

ChatGPT 本身已擁有出色的語言能力,而其對於圖片的描述能力亦展現出相同的水準。當涉及照片的開放性描述時,其結果同樣令人驚訝。

提示實驗記錄:

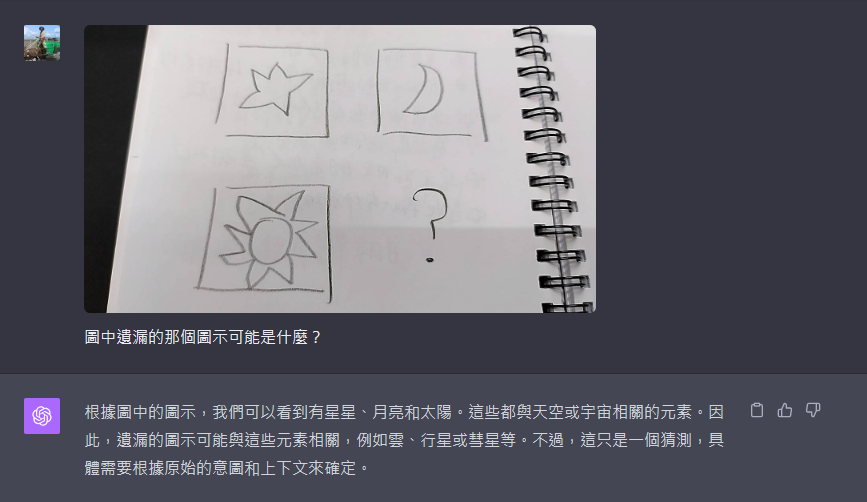

此外,圖片上的邏輯推論能力更是令我們的驚訝。

提示實驗記錄:

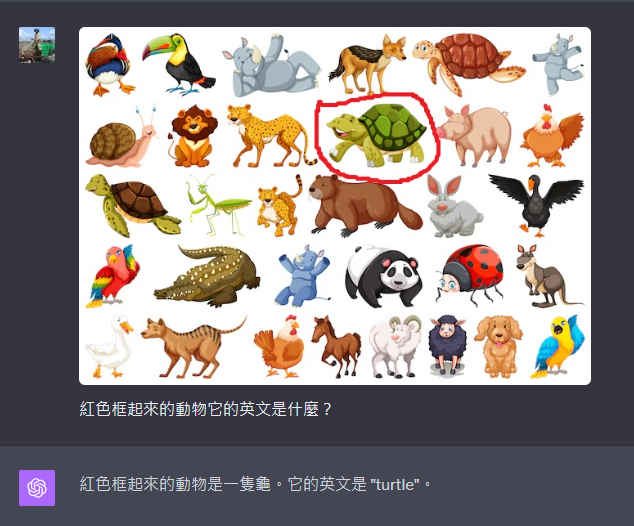

GPT-4V 不僅能夠理解圖片,其對圖片內指示符號的解讀也同樣令人印象深刻。例如,以下圖中框選烏龜後所進行的詢問。

圖片指示詢問的實驗:

GPT-4V 的能力不止於理解圖像中的意象。它能夠綜合圖片中的文字與我們的文字溝通,進行指定的任務。但在我們的實驗中,發現 GPT-4V 在中文支援上存在明顯的不足,如下述幾個實驗所示。

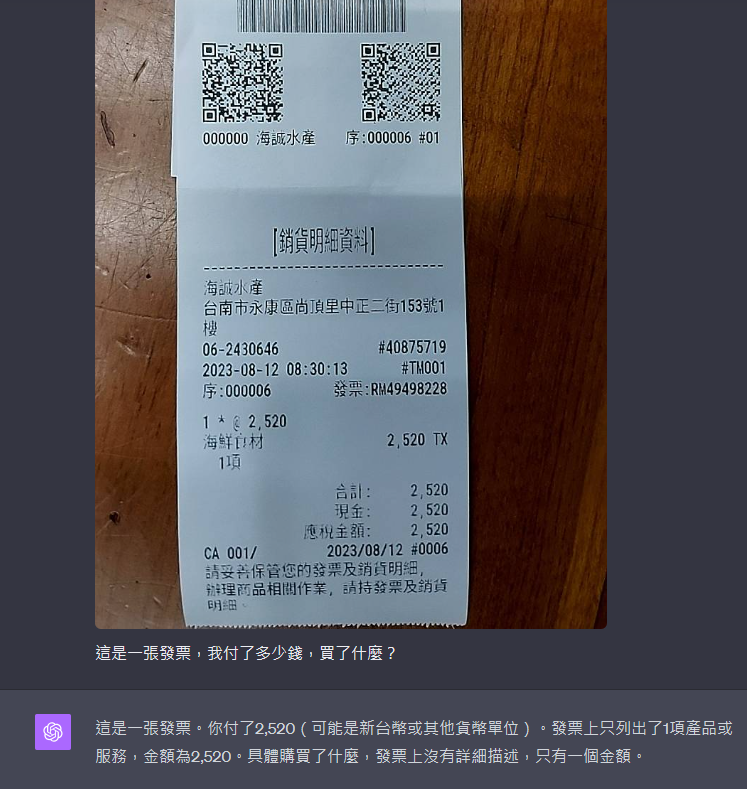

在發票資訊辨認的實驗中,GPT-4V 無法正確識別我們的購買品項。這可能是因為 GPT-4V 不能確定哪些資料是購買品項。但後續的實驗更加確認了它在中文支援上的局限性。

發票資訊實驗:

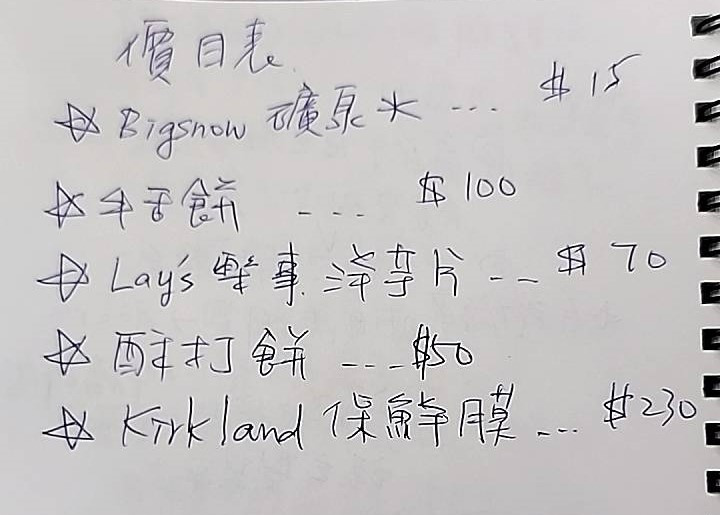

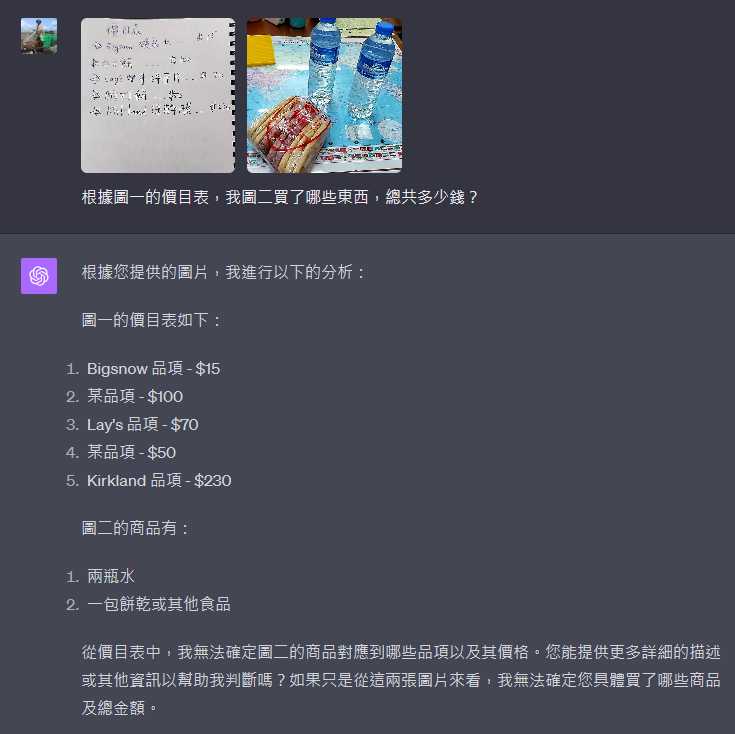

接著,我們提供了價目表和購買品項照片的實驗。以下是價目表:

購買品項詢問的實驗:

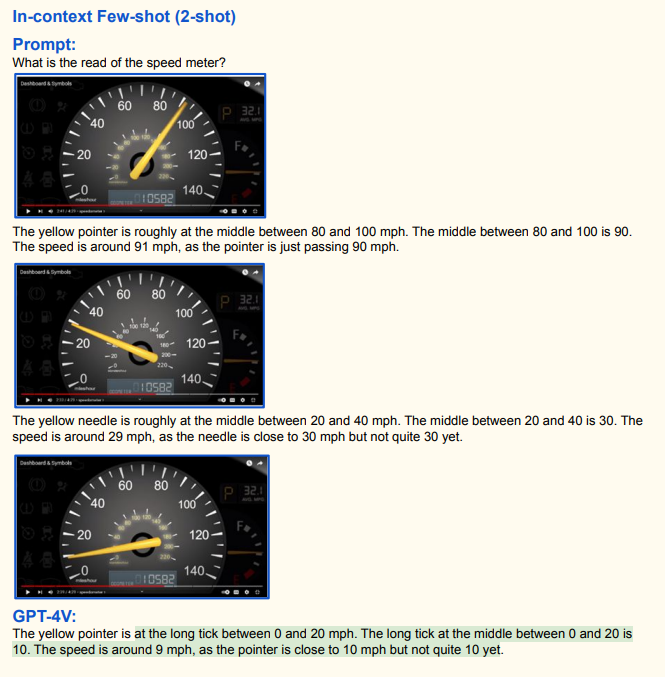

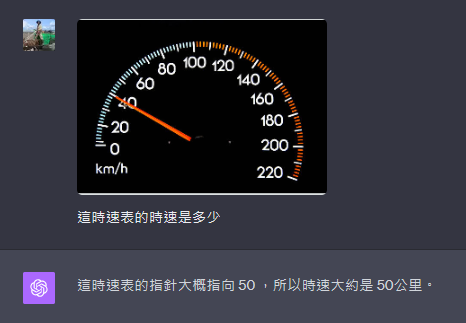

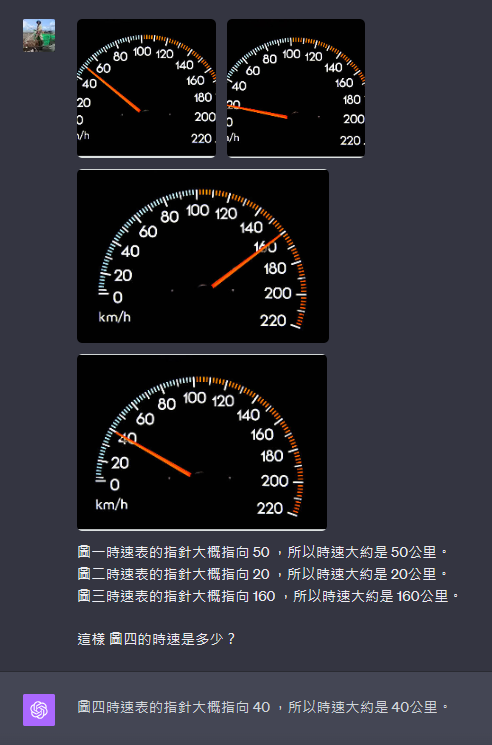

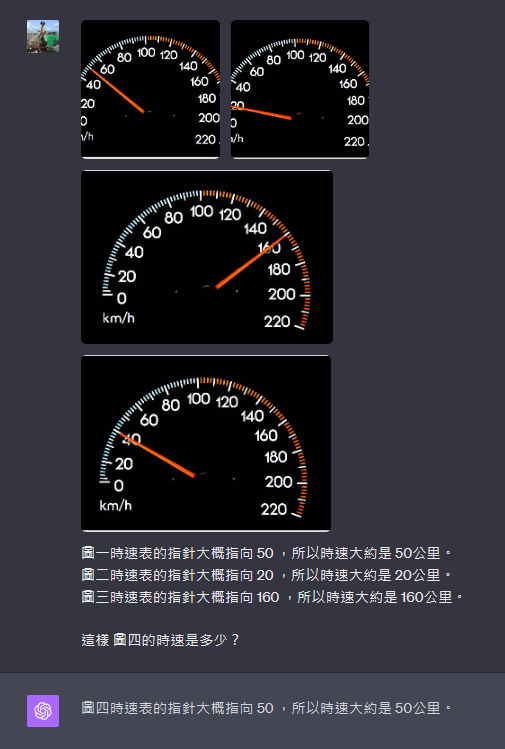

最後一點,可能與 ChatGPT 的設計有關。在微軟的 GPT-4V 報告中,詳細介紹了當圖片理解或回覆能力不足時,可以透過上下文少樣本學習(in-context few shots learning)來優化回覆。但當我們針對時速表讀取進行實際測試,ChatGPT 有時正確,有時則錯誤,這不穩定的表現使我們質疑:它是否真的通過少樣本學習來真正理解我們的問題並作出正確回覆?還是只是隨機猜測?

實驗記錄如下圖:

在詢問單張時速表上的時速時,回應有時正確,有時卻出錯。不過正確的回應次數略多。

對於回應錯誤的時速表,我們嘗試使用少樣本學習進行修正,結果確實獲得了正確的回應

然而,在多次詢問後,使用相同的少樣本學習方式再次提問,其回覆卻再度出錯。

通過我們的實際測試,GPT-4V 在圖片理解方面的表現確實相當出色。它不僅能進行基礎的圖像辨識,更展現出了深度的理解、解釋和處理能力。然而,其對於中文的辨識仍顯得有所不足,且在穩定性上,與專注於單一語言處理的模型相比,有待加強。

如果您喜歡我們這樣的內容,很歡迎到這裏訂閱我們的電子報,我們接下來的內容會在這裏優先發佈: ChatGPT 落地研究 | Ted (substack.com)