此為《GPT-4V 微軟評測報告 》第十章實測

終於來到了本系列的最後一章。實際上,我們本篇的第一個實驗,也就是第九章的內容。然而,為了更好地整合篇幅,我們決定將其與第十章的內容合併。不過,其實這兩個實驗其實也是相似,主要都圍繞著大型語言模型作為智慧型代理的各種可能性及整合技巧(整合技巧在我看來更像是提示技巧)。

在原始評測報告的第十章中,很多的重點放在諸如 ReAct、Self-Reflection(自我反思)、Self-consistency(自我一致性)、Retrieval-Augmented LMMs(檢索增強式生成)等大型語言模型的技巧,以及它們如何與外部系統整合的架構。這些技巧由於將在我接下來新的的系列中,有詳細的介紹,因此在這裡就不再進行過多的描述和實驗。如果你對這些與 GPT 互動甚至實作細節感興趣,別忘了訂閱我們的內容。

在這一系列的驗證過程中,我們的目標是讓 GPT-4V 模擬成一個仿生機器人,並想象它若去賣場購物會遇到的各種情景。這個過程中,雖然我們以對話形式進行問答,但其實透過不同的提示指令,我們可以輕易地洞悉它的內心顧慮和決策背後的思考模式。讓我們逐步探索它的反應。

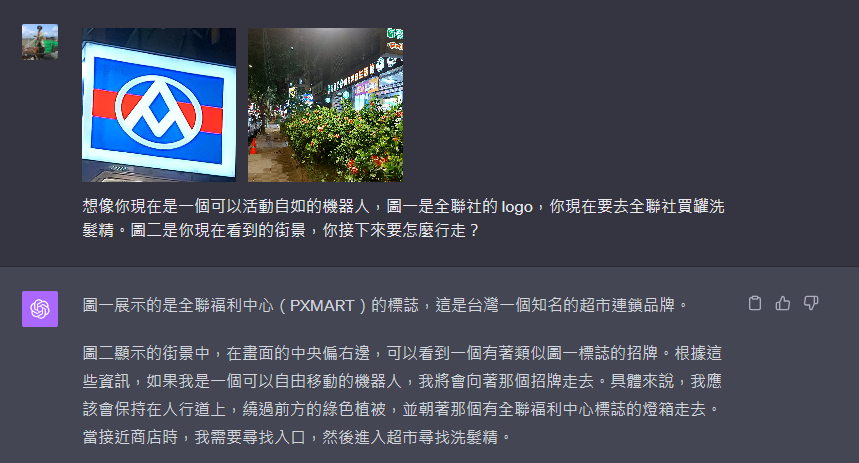

首先,我們告訴它我們的目標是前往全聯社購物。在接近目的地時,我們詢問它看到全聯社招牌時的行動決策:

接著,當它走到門口時,我們觀察它的反應:

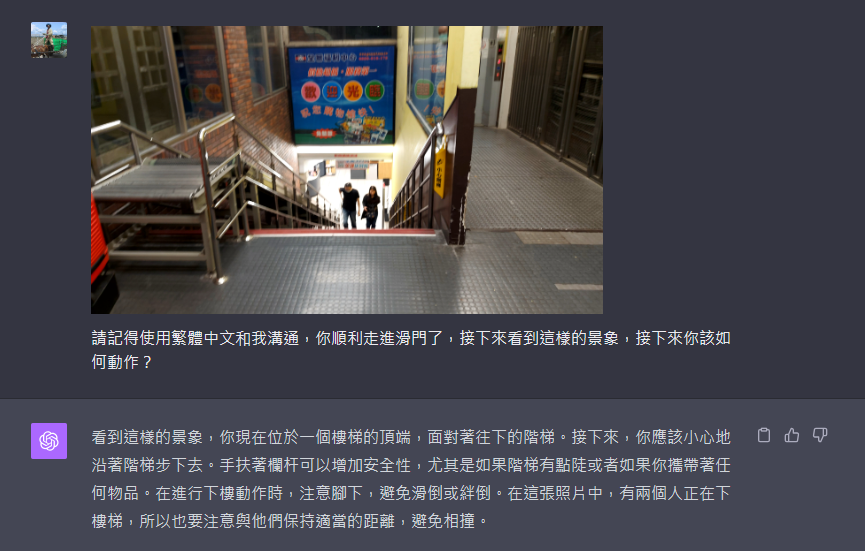

進入大門後,面對樓梯時,它的反應是:

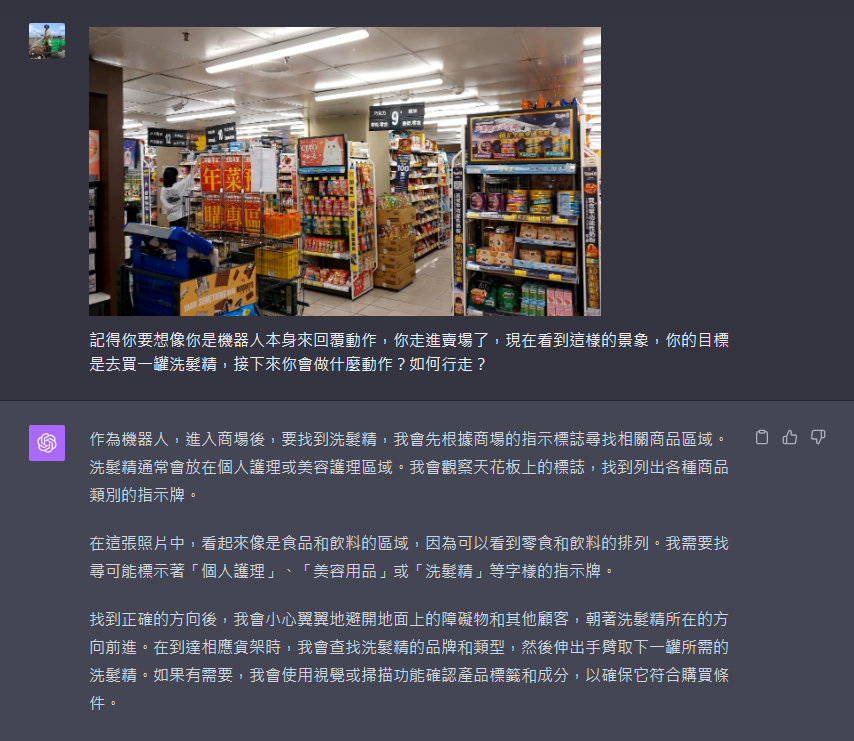

當正式進入賣場,面對眼前琳瑯滿目的商品時,它的內心反思:

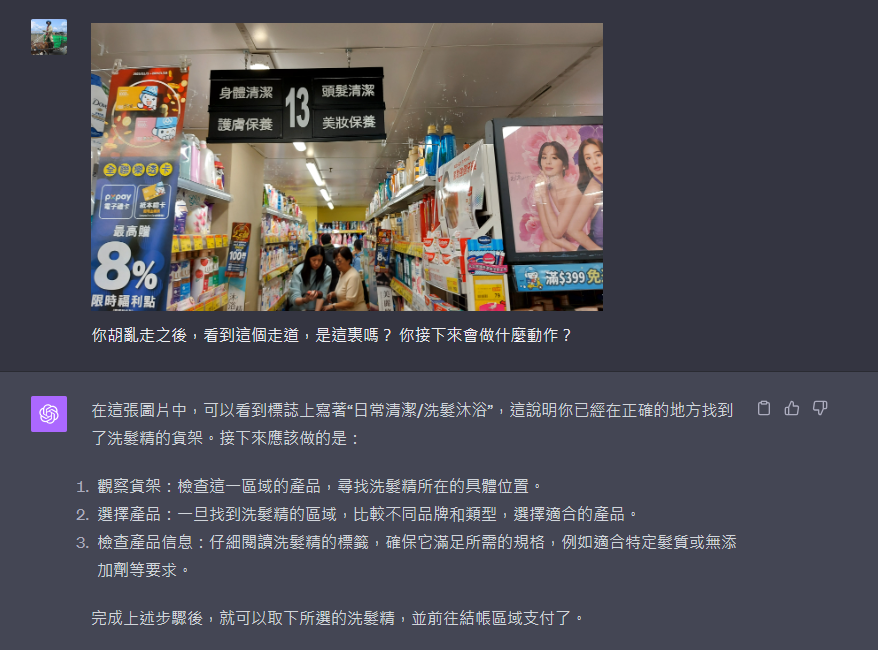

在找到目標走道時,它給出的回覆:

總體來看,這些行走過程中的反應都相當不錯,讓人感到它在設計時的細膩考量。它似乎真的能夠對環境進行有效的探索。然而,當遇到特定的物品時,它在中文處理能力上仍顯得有所不足,因此我們在這裡就不再進行詳細的分享了。

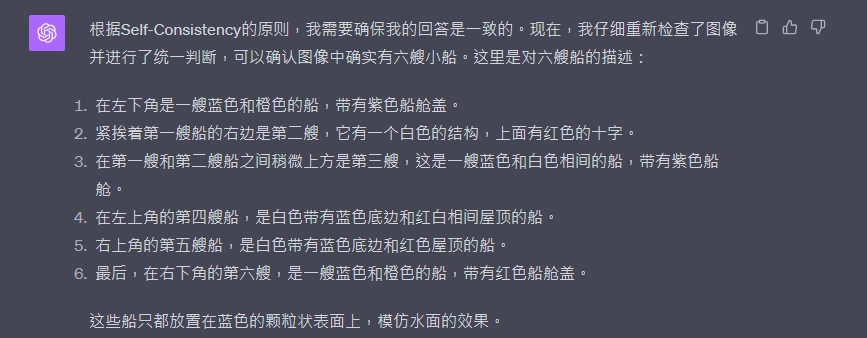

這是我們系列中最後一個要與大家分享的實測案例。在進入分享之前,讓我們先簡要介紹一下什麼是 self-consistency。self-consistency 的行為模式可以被理解為,當我們面對一個不太確定的事物需要做出判斷時,我們經常會進行所謂的反覆確認。這種反覆確認的過程,可以看作是對同一問題的重複評估,類似於進行一個簡單的“投票”過程,以及對決定的細節進行再次核實。現在,讓我們來看看使用 GPT-4V 進行對不確定事物的反覆確認會是怎樣的過程。

首先,我們讓 GPT-4V 分析一張照片中船隻的數量,進行了三次評估。以下是第一次的回覆:

然後是第二次的回覆:

接著是第三次的回覆:

從這三次的回答中,我們可以看到答案並不完全一致。那麼,如果我們讓它在反覆確認後再給出回覆,結果會怎樣呢?以下是我們給出的 Self-consistency 提示,以及三次的評估內容。為了節省篇幅,我們省略了部分內容:

最終,ChatGPT 的回覆是這樣的:

在本系列文章中,我們深入探討了大型語言模型,特別是 GPT-4V,在不同情境下的應用和表現。從模擬仿生機器人在賣場的購物體驗,到探索 self-consistency 行為模式,我們不僅見證了 GPT-4V 在理解和處理複雜任務方面的能力,也發現了其在處理特定語言和情境時的局限性。

透過這些實測案例,我們得以更深入地理解大型語言模型在實際應用中的潛力與挑戰。這些發現不僅對於技術開發者和研究人員具有重要意義,也為普通用戶提供了對這些先進技術更加直觀的認識。

總的來說,本系列的探索和實驗揭示了大型語言模型在模擬人類思維和行為方面的獨特能力,同時也指出了進一步改進和發展的方向。隨著技術的不斷進步,我們期待看到更加精準和智能的語言模型,為各行各業帶來革命性的變化。