深度學習(Deep Learning)是一種強大的機器學習技術,近年來在各個領域中取得了顯著的成功。本文將詳細介紹深度學習的概念、其與傳統機器學習的區別、歷史發展及網路設計的基本原則。

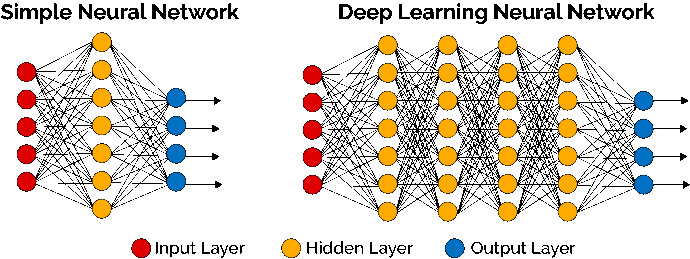

深度學習是一種模仿人腦神經元間連接方式來模擬人類學習過程的機器學習方法。其核心是深度神經網路(Deep Neural Network, DNN)。相較於傳統機器學習模型通常只有一層隱藏層,深度神經網路由多個隱藏層組成,每層隱藏層包含許多神經元。這些層次結構使得深度學習能夠自動學習數據的特徵表示,從而能夠高效地處理和分析複雜的數據。

深度學習模型通常使用大數據來訓練,以自動提取數據中的特徵,而無需人工干預。這使得深度學習特別適合應對高維數據和複雜模式識別問題,如圖像識別、語音識別和自然語言處理等。

儘管深度學習屬於機器學習的分支,但兩者之間存在以下幾個關鍵區別:

特徵工程:在傳統機器學習中,特徵工程是至關重要的,需要專家手動設計特徵來表示數據;而在深度學習中,模型能夠自動從原始數據中學習到適合的特徵表示,這大大減少了人工干預的需求。

模型複雜度:深度學習模型通常比傳統機器學習模型更加複雜,擁有更多的參數和層次結構,這使得深度學習能夠更好地擬合複雜的數據分佈,從而在許多應用中表現出色。

計算需求:深度學習通常需要大量的計算資源,尤其是使用GPU加速來進行模型訓練。而傳統的機器學習算法相對來說對資源需求較低,適合小規模數據集和簡單模型。

深度學習的發展歷程可追溯至上世紀50年代的感知器模型(Perceptron),但直到最近幾十年,深度學習才真正取得了突破。以下是幾個深度學習發展的重要里程碑:

1986年,Rumelhart、Hinton 和 Williams 提出了反向傳播算法(Backpropagation),這使得訓練深度神經網絡成為可能,並且開啟了多層神經網絡的研究熱潮。

2012年,Hinton 及其團隊在 ImageNet 圖像識別競賽中使用深度卷積神經網路(Convolutional Neural Network, CNN),取得了突破性的成果,極大地提升了圖像識別的準確率。這一事件被視為深度學習革命的開端。

設計有效的深度學習網路需要考慮多方面的因素,以下是幾個基本原則:

層次結構:合理的層次結構設計有助於模型提取和表示不同層次的數據特徵。不同層次的特徵對應不同的抽象層次,例如,低層次可能提取邊緣或顏色等簡單特徵,高層次則可能捕捉物體形狀或語義等複雜特徵。

激活函數:激活函數是神經網路中引入非線性能力的關鍵。選擇合適的激活函數,如ReLU(Rectified Linear Unit)或Sigmoid,能夠增加網路的非線性表示能力,從而提高模型的表現。

正則化技術:正則化有助於防止模型過擬合,提高其泛化能力。常見的正則化技術包括Dropout和L2正則化,這些方法可以減少模型對訓練數據的過度依賴。

優化算法:選擇合適的優化算法可以加速模型的訓練過程,並幫助找到更好的解。常用的優化算法包括隨機梯度下降(SGD)和Adam,這些算法在深度學習的訓練中被廣泛使用。

總的來說,深度學習作為一種革命性的機器學習技術,已在許多領域取得了卓越的成果。隨著網路結構和訓練算法的不斷優化,深度學習將繼續在推動人工智慧發展中扮演關鍵角色,並應用於越來越多的複雜任務中。