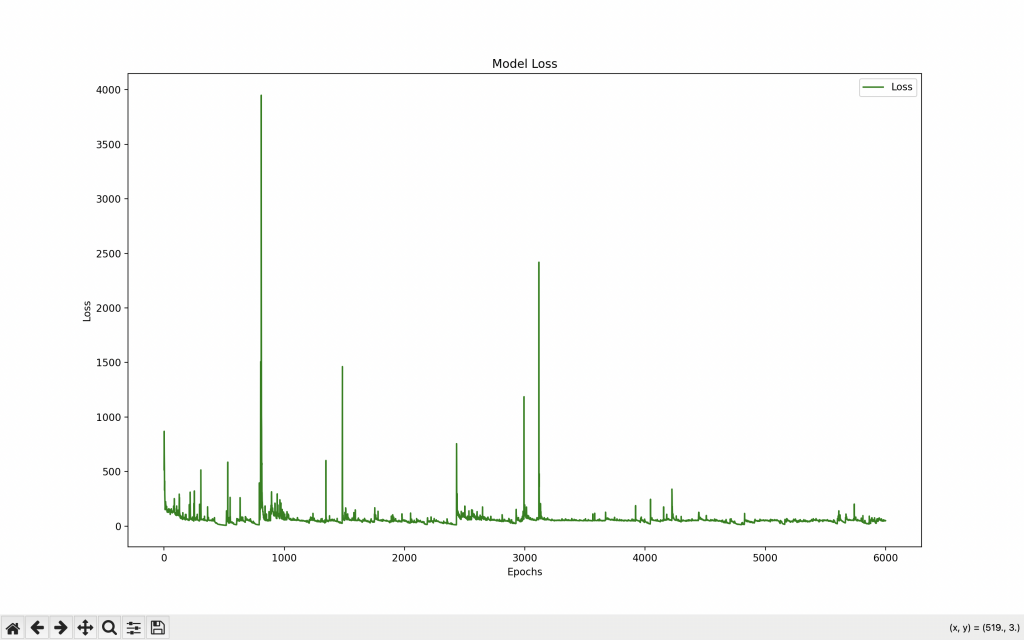

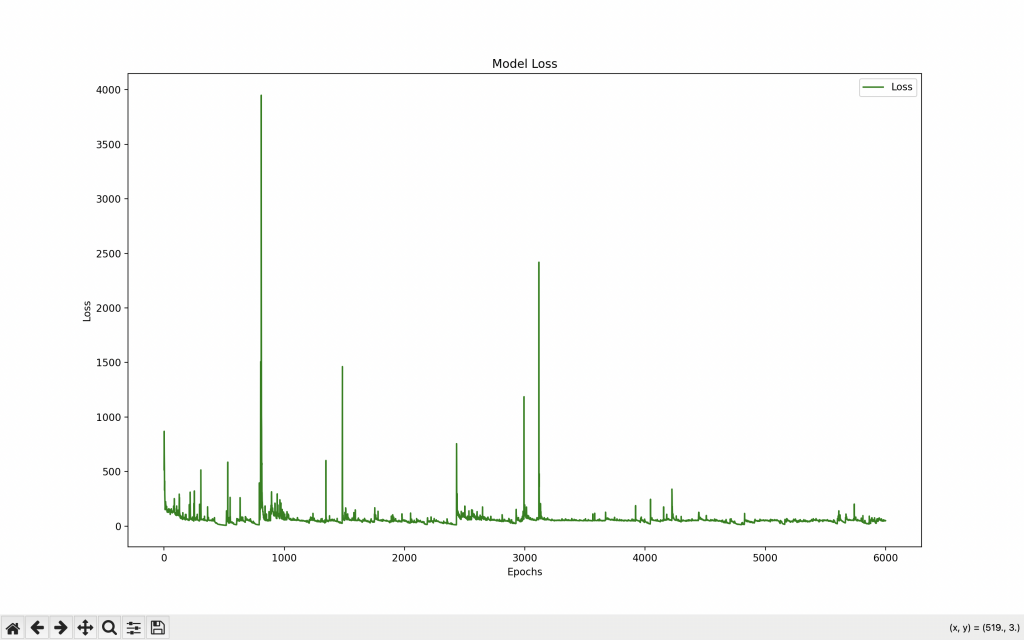

今天是第十天就昨天的程式碼我們下去跑圖我跑了一整天,以下是結果我們來分析

從圖中可以觀察到以下幾個現象:

-

Loss 波動:

- 在訓練過程中,

Loss(損失值)有著明顯的波動。這種波動可能意味著模型在不同的 batch 上表現不穩定,這可能由於以下原因:

- 資料集中的一些異常數據或噪音數據引起的。

- 模型的正則化參數過強,導致模型在某些數據上表現出過度懲罰。

-

learning rate 的設置可能需要進一步調整,或者是模型結構上可能過於複雜導致不穩定的學習過程。

-

Loss 整體趨勢:

- 儘管存在波動,損失值的整體趨勢是逐漸下降的,這說明模型在逐漸學習並且有一定的改善。

- 但在某些訓練階段(例如在大約1000, 2000, 3000, 5000 epoch 之後)有幾個極高的 loss 值,這可能反映了模型在該階段的某些不穩定行為。

-

潛在的過擬合問題:

- 如果訓練 loss 經常反彈到較高的值,並且在很長一段時間內未能穩定下降,這可能是過擬合的跡象,特別是如果模型過於複雜(例如過多的 LSTM 單元或過強的正則化)。

建議改進方向

-

調整正則化參數:

- 當前 L1 和 L2 的正則化強度可能過高,可以適當減弱這些參數,或嘗試僅使用其中一個正則化項,觀察模型的變化。

-

降低學習率或調整學習率策略:

- 嘗試進一步降低學習率,或是採用一些自適應學習率調整策略,例如使用

ReduceLROnPlateau 或其他自動調整學習率的回調函數。

-

數據預處理:

- 檢查數據是否存在異常值或噪音,考慮進一步的數據清理,或對數據進行增強處理,以減少訓練過程中的波動。

-

模型結構簡化:

- 嘗試簡化模型結構,可能移除一些過度複雜的層或減少 LSTM 單元數量,這可以幫助模型更穩定地訓練。

-

批次大小:

-

batch_size 的選擇也可能影響訓練的穩定性,嘗試不同的 batch_size 設定(例如64、128),觀察其對訓練損失的影響。

這些改進方向可能有助於減少訓練過程中的損失波動,並且提高模型的整體穩定性和性能。