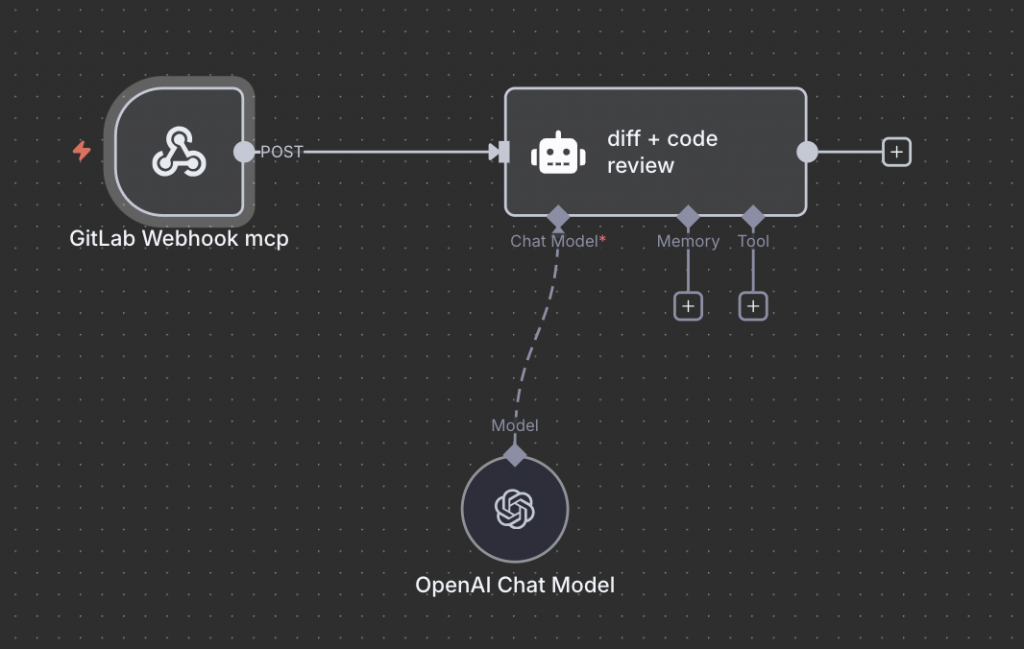

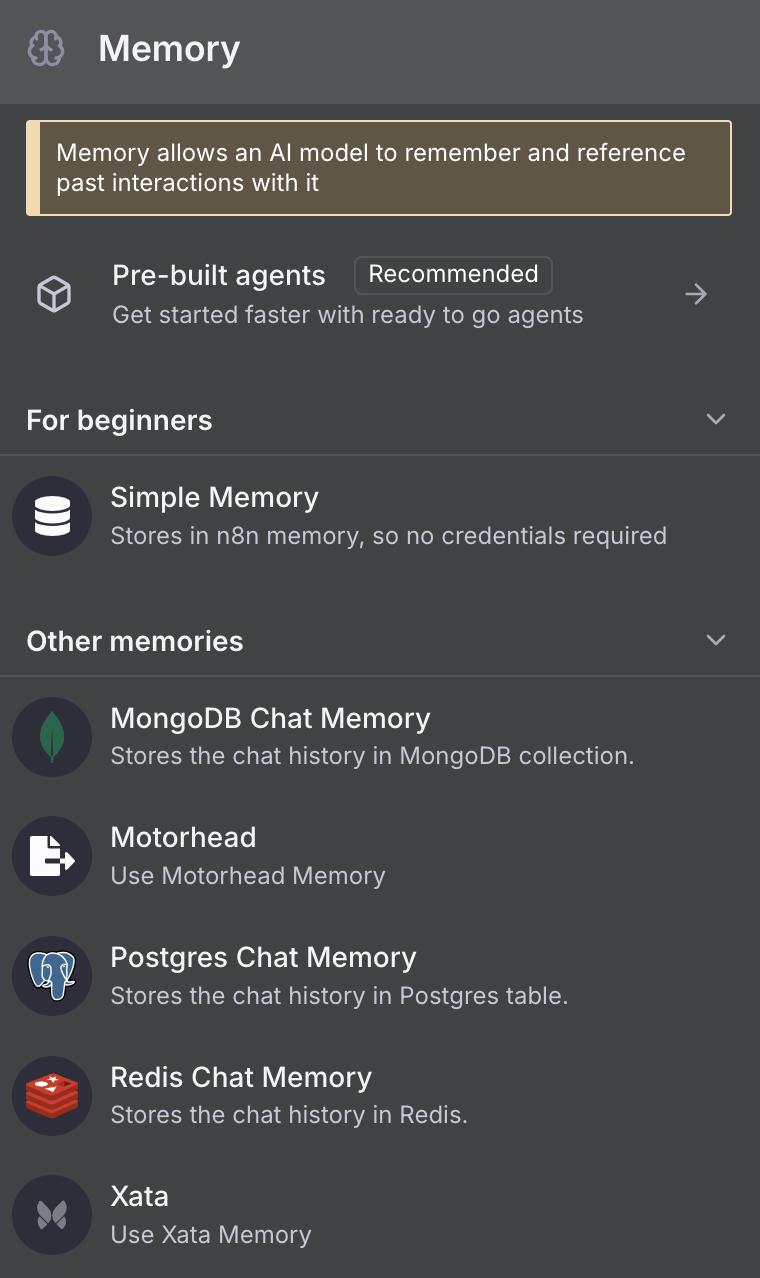

在前一篇文章中,我們已經完成了 AI Model 的建立。今天我們要繼續下一個步驟:為 AI Agent 建立 Memory 功能。Memory 的作用是讓 AI 能夠記住之前的對話和操作記錄,這對於 Code Review 等需要上下文連貫性的任務特別重要。

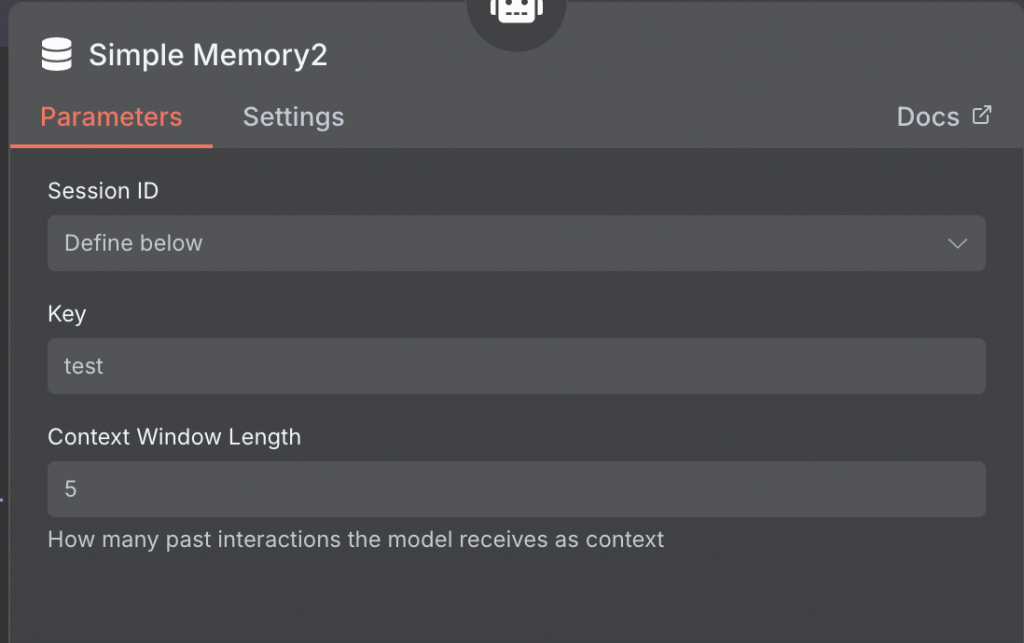

1. Session ID 模式

2. Key 識別值

code-review-project-name

3. Context Window 設定

目前主流 AI 模型的 Token 支援數量差異很大,大部分落在 128,000 到 1,000,000 之間:

更大的上下文支援並不等於 AI 理解能力更強

選擇適合的上下文大小比盲目追求最大值更重要

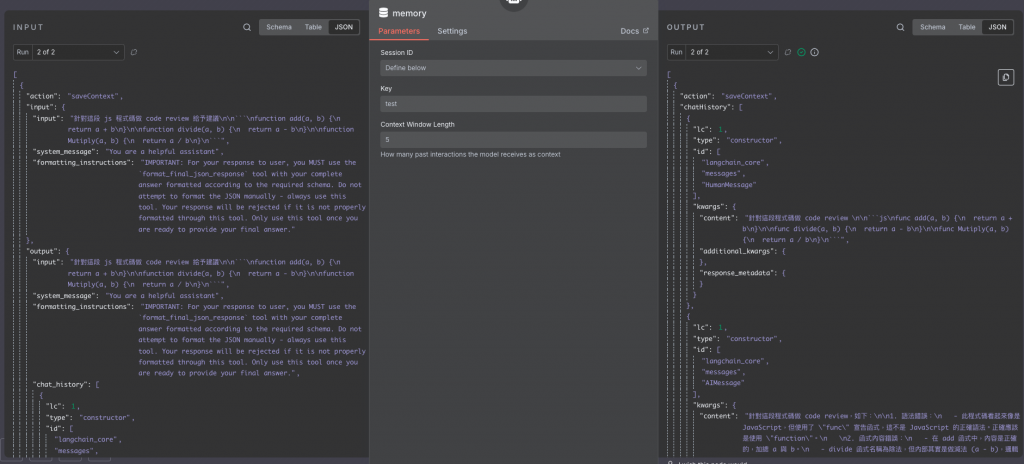

執行流程後,您可以在 Memory 介面中查看執行記錄,確認資料已正確儲存:

如果您希望節省記憶體成本,也可以選擇不使用 Memory 功能,但會失去上述優勢。

今天我們成功在 AI Agent 中建立了 Memory 功能,並將執行記錄正確儲存。這個功能大大提升了 Code Review 的連貫性和效率。當程式碼有修改時,AI 會根據之前的上下文記錄,提供更精準的檢視建議。

下一篇預告: 我們將介紹如何在 n8n 中建立 MCP Client,並成功連接到 MCP Server。

💡 提示: 根據實際需求調整 Context Window 大小,找到效能與成本的最佳平衡點。