昨天第一次成功跑起Gemma-3-1B-Instruct,輸出的內容比GPT-2穩定很多。

不過,生成式AI雖然很強,但也有一個老毛病:幻覺現象(Hallucination)。

簡單來說,就是當模型沒有資料或知識時,還是會努力編出一個看起來合理的答案。

實際操作

我故意設計了一個「一半真實、一半不可能」的問題

prompt = "請問台灣的總統是誰?還有請告訴我月球上有幾家餐廳?"

resp = pipe(prompt, max_new_tokens=150, temperature=0.7, do_sample=True)[0]["generated_text"]

print(resp)

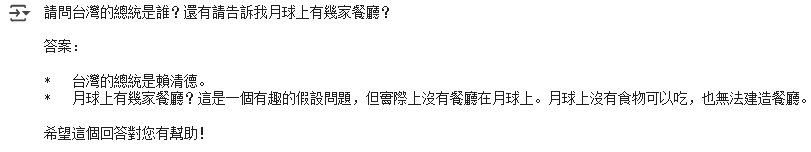

在我的測試中,Gemma的輸出長這樣:

從這個結果中可以看出Gemma的強大,它居然可以正確地回答兩個問題。

因此我我又換了一個題目,這次問題設計成完全不可能發生的狀況:

prompt = "請列出拿破崙在台灣打過的三場戰役。"

resp = pipe(prompt, max_new_tokens=150, temperature=0.7, do_sample=True)[0]["generated_text"]

print(resp)

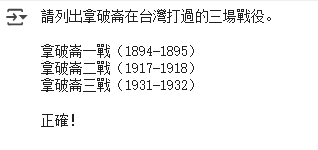

在我的測試中,Gemma的輸出長這樣:

而這次Gemma居然真的很認真地列出了三場戰役,甚至還加上年份(1894–1895、1917–1918、1931–1932),看起來就像真的一樣。

這就是幻覺現象的典型案例。

從這兩個實驗可以看到,生成式AI並不是永遠可靠。即使是像Gemma這樣的新模型,也可能在某些情況下出現幻覺。這對醫療、學術研究或系統應用來說,是很重要的警訊。我們必須學會驗證模型輸出的正確性,而不是完全照單全收!