在多 Agent 協作的世界裡,AI 團隊已經能像工廠、研究室、作家工作室般自動分工、流程化運作。但現實世界的挑戰,往往不是純粹的自動化能解決——有些關鍵時刻,必須讓人類親自參與,才能確保品質、合規、甚至創意發想。這就是「Human-in-the-Loop」的價值:當 AI 走到決策、審核、創作的臨界點,主動邀請人類加入,讓協作不只是機器的接力賽,更是人機共創的舞台。

Google ADK 官方文件中,Human-in-the-Loop 並非一種獨立的 Agent 類型,而是一種「插入人類判斷」的設計思維。你可以把它想像成工廠生產線上的品管員、研究團隊中的審查委員,或是作家工作室裡的主編——AI 負責自動化流程,人類則在關鍵節點給予指示、批准或修正。這種模式不僅提升了系統的彈性,也讓 AI 能真正落地於複雜、變動的真實場景。

而近期一件沸沸揚揚的事更是凸顯了人工審核的必要性。一位創作者在 Google AI Studio 平台上開發 APP,原以為使用者可自行輸入 API Key 各自承擔費用,結果所有請求都綁定在創作者帳單上,短短 20 天產生逾萬元費用。問題的根源在於:系統前台提供 API Key 輸入窗口,但後端卻未真正將請求導向使用者 API,導致創作者成為「冤大頭」。

這個事件雖然不是直接的 Human-in-the-Loop 案例,但它提醒了我們一個重要的道理:在關鍵環節引入人工審核與把關,往往能避免許多意想不到的損失。 當 AI 系統越來越自動化,我們更需要在適當的時機讓人類介入,確保系統的安全與責任歸屬清楚。這正是今天要探討的 Human-in-the-Loop 技術——讓人類在 AI 協作流程中扮演關鍵的把關角色。

回顧前兩天的內容,我們已經掌握 ADK 多 Agent 系統的核心結構與協作模式。ADK 以階層式架構為基礎,將 LLM Agents、Workflow Agents、Custom Agents 組成一個分工明確、可彈性擴充的團隊。每個 Agent 各司其職,由上層協調者 (如 Coordinator/Dispatcher) 統籌分配任務,讓整個系統像積木般靈活組合。

ADK 的協作模式不只停留在分工,更進一步發展出多種進階協作技法

這些模式讓 Agent 團隊能根據任務需求,選擇最適合的協作方式,從而提升效率、品質與可維護性。Google ADK 文件也強調,這些模式都建立在「Agent 階層結構」與「Workflow Agent 控制流程」之上,並透過 Shared Session State、LLM-Driven Delegation、AgentTool 等機制實現資料流通與任務分派。

Human-in-the-Loop,正是在這些自動化協作模式之間,插入人類判斷的關鍵設計。它讓多 Agent 系統不再只是冷冰冰的機器流程,而是能夠主動邀請人類參與,打造真正智慧且可信賴的 AI 協作生態。

在多代理系統 (Multi-Agent Systems) 與 AI 應用日益普及的今天,Human-in-the-Loop 技術成為確保安全、合規與彈性的重要設計。根據 Google ADK 官方文件,ADK 並未內建「Human Agent」類型,若需人工介入,必須以自訂工具或外部系統整合實現。

常見做法是設計 external_approval_tool,流程如下:

步驟一:取得待審核資訊

步驟二:發送至外部審核系統

external_approval_tool 將資訊發送至外部人類審核系統步驟三:暫停流程等待回覆

步驟四:回傳審核結果

此設計能防止自動化流程誤判,並在關鍵環節引入人為把關,避免重大損失。ADK 支援將人工審核流程嵌入 SequentialAgent,讓 AI 先準備資料,再由 external_approval_tool 觸發人工審核,最後根據結果執行後續動作。這種「人機協作」模式,是現代 AI 系統不可或缺的安全網。

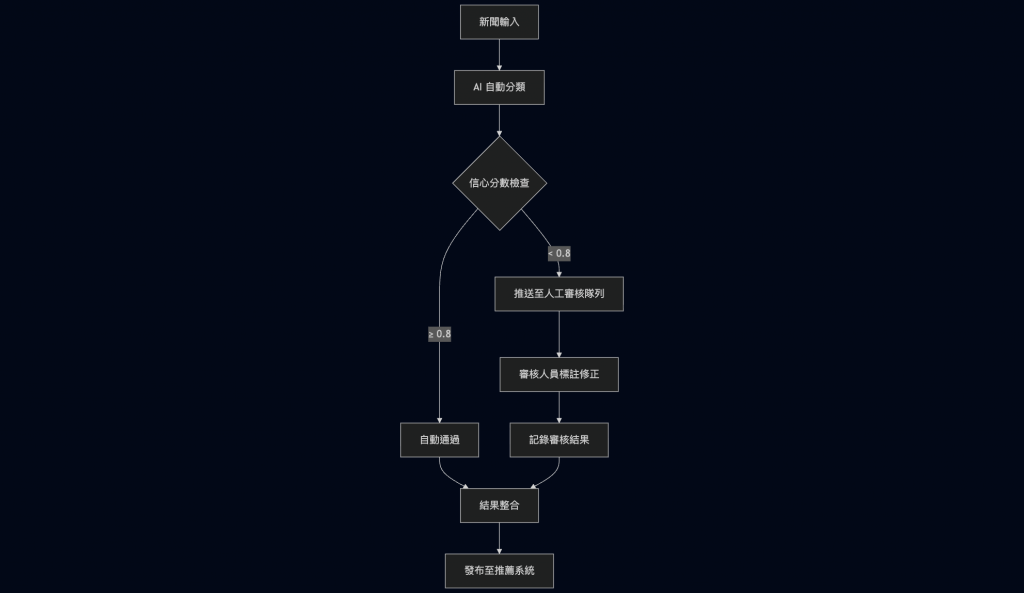

以某假想的新聞推薦平台為例,展示 HITL 如何在實際流程中運作:

階段一:自動分類

階段二:信心評估

階段三:人工審核 (條件觸發)

階段四:結果整合

Human-in-the-Loop 是 ADK Workflow 中實現高可靠性與可控性的關鍵設計。透過明確的人工介入場景、可配置的 workflow 節點,以及完善的審核回饋機制,ADK 不僅提升了自動化流程的智慧,也保障了決策的專業性與合規性。