在前幾天完成 Ollama、Docker 和 Open WebUI 的環境設定後, 我們終於讓生成式 AI「開口說話」了!

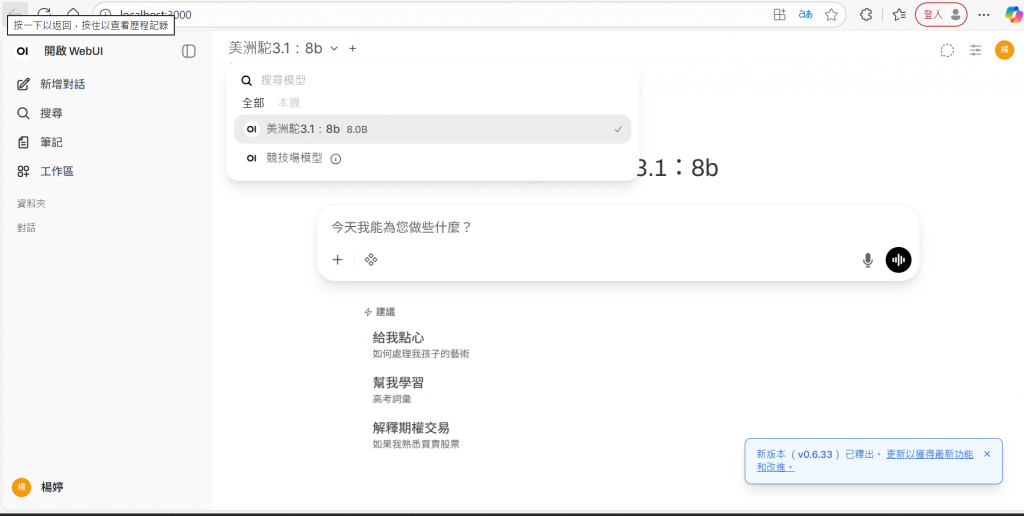

這個畫面是 Open WebUI 的主要互動介面,也是與本地語言模型對話的核心位置。

在上方區塊可以自己選想用的語言模型(我這次選的是美洲駝 3.1:8b)。

使用者可以透過下拉選單快速切換不同模型,例如更小的 Phi 3 或 Mistral,以便比較回覆速度與效能差異。

畫面中央的輸入框是主要的對話區域,顯示提示文字「今天我能為您做些什麼?」。只要在此輸入問題或指令並按下 Enter,系統就會立即回覆。

右側的麥克風與音波圖示代表語音輸入與聆聽功能,方便進行更自然的互動。

左側的功能欄包含「新增對話」「搜尋」「筆記」「工作區」等項目,能幫助使用者管理不同主題的聊天記錄。

整體介面設計簡潔直覺,所有資料都保留在本地端,確保私密性與運算效率。

這樣的介面讓使用者能清楚地控制模型、管理對話,並以可視化方式體驗本地生成式 AI 的運作過程。