這是某篇論文附的code 想請問像這樣的情況 架構圖長什麼樣

謝謝回答

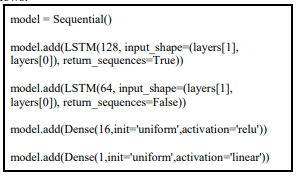

原文:In this stage, the data is fed to the neural network and trained for prediction assigning random biases and weights. Our LSTM model is composed of a sequential input layer followed by 2 LSTM layers and dense layer with ReLU

activation and then finally a dense output layer with linear activation function.

論文:https://www.ijsr.net/archive/v6i4/ART20172755.pdf

不專業碼農~~回答

目前看來是4個輸入 (相同資料 輸入兩次 不同的LSTM)

最後合併

然後輸出1個數值

(本想輸出可視化的圖形,但出現Bug@@)

可以參考

https://medium.com/@daniel820710/%E5%88%A9%E7%94%A8keras%E5%BB%BA%E6%A7%8Blstm%E6%A8%A1%E5%9E%8B-%E4%BB%A5stock-prediction-%E7%82%BA%E4%BE%8B-1-67456e0a0b