公司內部有許多電腦都是處於待機狀態, 也就是說使用者開機後, 就待機了, 或是工作量並不高

因此在考慮這類型的電腦日後在更換時也更換成低容量的SSD

事實上大部份都是低工量, ERP + OFFICE 作業

想向各位先進徵詢些意見及建議

硬碟使用容量:

WIN10 + OFFICE + ERP 系統不超過 70G

個人資料 + OUTLOOK 超過 20G

規劃:

低容量用戶: 256G

高容量用戶: 500G

SSD 若要保持效能與延壽, 最好只使用到 70% 的空間...

也就是在切 Partition 的時候, 256GB 只要切到 180GB 就好, 後面剩下的空間都不要去用他....

你自己算算這樣哪一種比較夠用?...

有趣的概念, 網路上似乎找不到相關的理論, 不知道您的理論是從哪來的? 蠻有興趣詳細了解, 不知道正確的關鍵字為何?

SSD 使用低於 75% 空間是常識啊,70% 是保守一點

用 SSD 70% 75% 去餵狗相信樓上會找到很多論點的

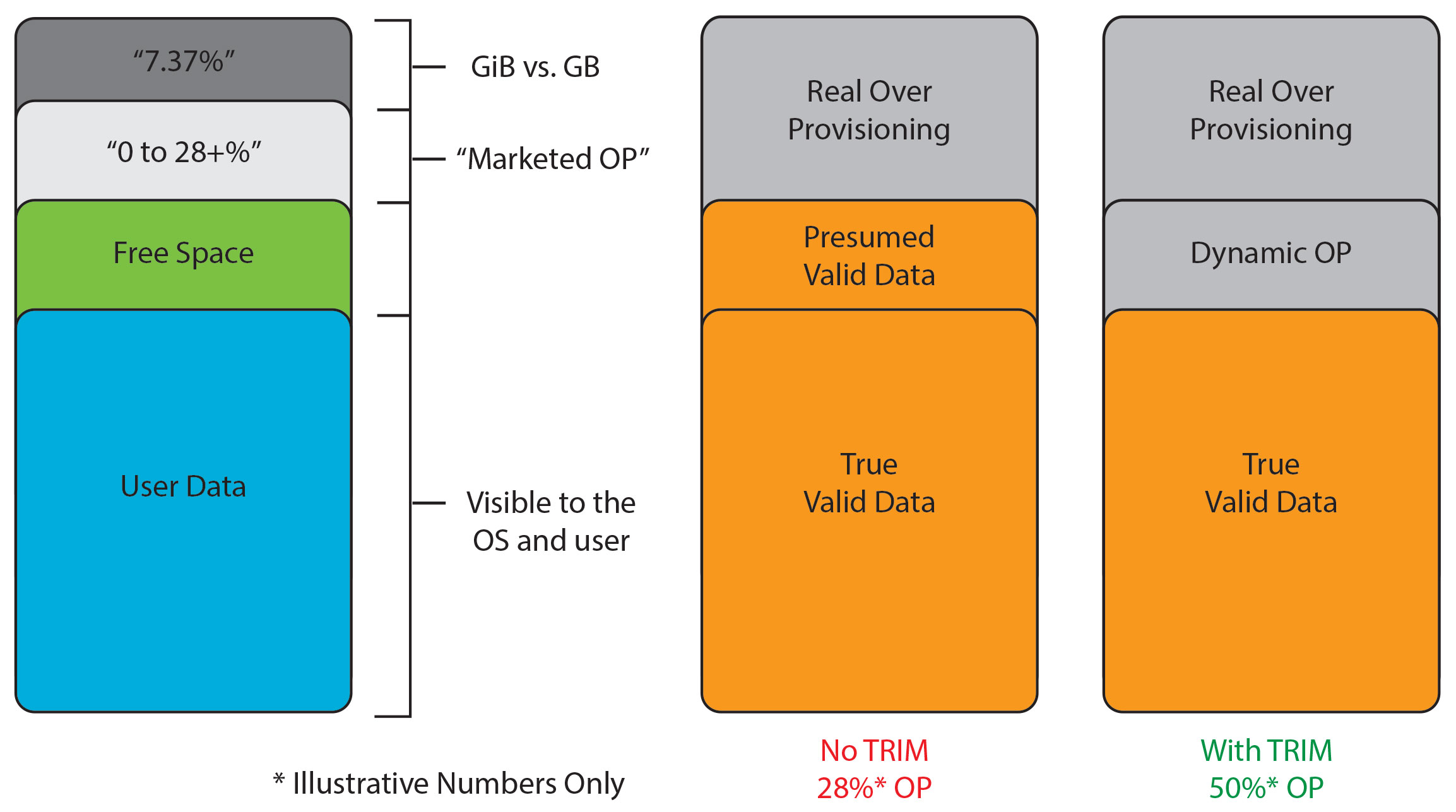

這個問題的源頭來自 SSD 的寫入放大(Write amplification) 現象, 而用來對抗這個弱點的方法是 Over-provision, 有些型號會預留, 有些不會; 通常越便宜的型號, OP 預留的越少. 製造商會預留的空間在 0~28% 左右. 如果製造商都沒保留 (0%) 或是根本沒揭露 OP 規格的話, 我們自己自行保留 30% 是比較安全的選擇.....

這是 Kingston 各型號保留的 OP 值, 對照市場價格, 大致可以得出 - OP 越多, 價格越貴的一致性:

Maintaining Performance and Endurance via Over-Provisioning (OP)

這是 QNAP 說明 OP 保留越多, 對效能的體驗越好; 而且 QTS 管理介面甚至可以調整到 - 將 OP 保留到高達 60%, 以換取穩定效能 (也就是 User 只剩下 40% 的空間可用):

SSD Extra Over-provisioning

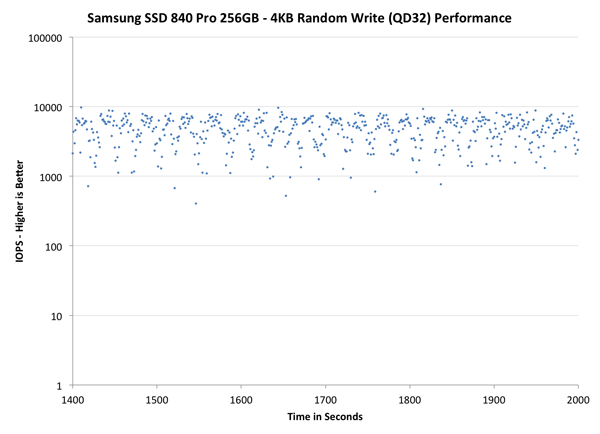

事實上, 所謂的效能下降, 並不是直接一棒就被打趴在地上, 而是會不穩定的上下浮動, 這裡有實測 SSD 被塞滿之後, IOPS 上下飄動的狀況, 可以看到, 原本應該在 10,000 IOPS 左右的效能, 上下可以有高達 90% 的飄移值:

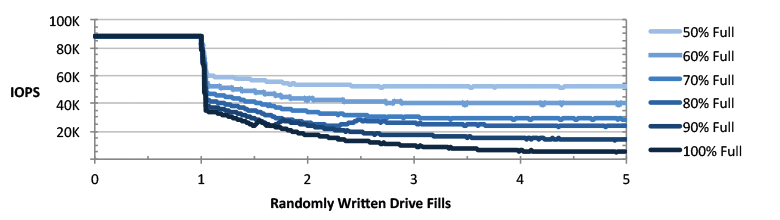

這是另外一個用 Micron SSD 測試的結果, 可以看到原本能有 90K 的 IOPS, 在容量被用到近 100% 的時候, 效能已經低到快要測不出來了:

這是 Seagate 的 OP 範例展示, 他用來說明, 製造商保留的 OP 種類, 7.37% 是固定的, 但不是每一個製造商都會好心的幫你保留 28% (其實有保留的, 也是把這塊成本算到價格中請你付費, 廠商不會免費送你), 此外, Dynamic OP 的大小影響更多, 藍色那塊才是 User 真正能用的安全資料區, 資料量超過那個範圍, 就會影響效能:

換句話說, 如果廠商保留的 OP 不夠多, 使用者就必須自己節制, 不要用掉那麼多空間:

WHY SOLID-STATE DRIVE (SSD) PERFORMANCE SLOWS DOWN AS IT BECOMES FULL

我之前只知道不要用到滿。很容易發生問題。

如整個資料消失的問題。

只是我不知道是70%左右。

(曾經用ssd被我操到爆後,還真的東西全消失過)

raytracy大剛好說明了這篇。讓我了解其原因。

謝啦。

我不知道你懂或者不懂 Windows Server

不然真的可以建議你規劃使用者資料夾轉向及漫遊使用者設定檔

這樣你client端就可以放心使用SSD

找台Host安裝ESXi,把這些經常待機的實體轉虛擬進VM讓他永遠待機好了,看起來用戶不常在座位上,設置公用電腦讓他們RDP自己的VM即可。

如果大部份都是低工量 ERP + OFFICE 作業,那256GB就夠了,我都還給128GB(Disk C)而已,

資料請同仁放在傳統硬碟(Disk D 500GB),Disk C容量不夠他們自然就會去整理資料,exchange的ost是放在Disk D