簡單回顧

之前在介紹 Gradient Descent 及 ML入門(十五)Regularization(Solving overfitting)都有提到,在做最佳化的時候, 會對目標函數加入一些限制條件。舉個例子好了,最近朋友推薦看一部動漫,相信大家也都很熟才對,鬼滅之刃,主角炭治郎在接受訓練時,一直拼命練習為了能夠變得更強,但是幫他訓練的柱,還是會要求他休息養傷,終究是人類還是得休息。這就是限制條件,在最佳化的問題時,必須要有所限制。

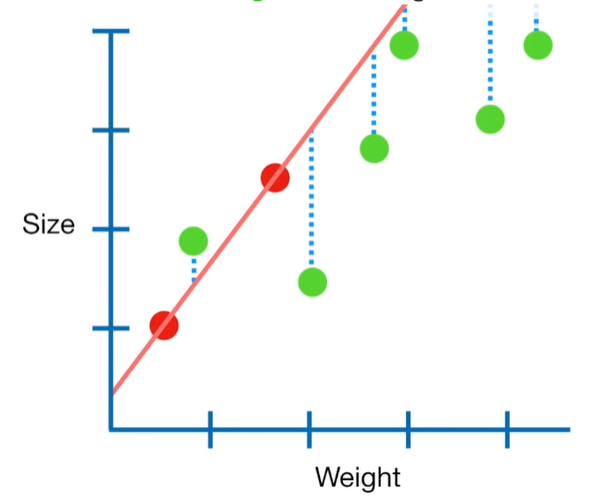

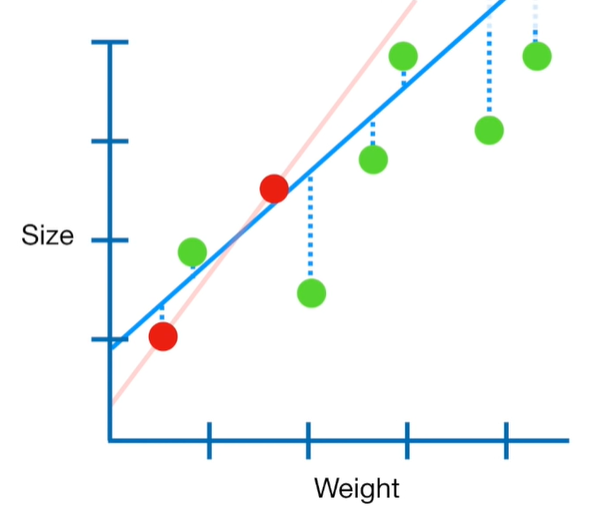

由下面這張圖可以看到,紅色典是training data,綠色點是testing data。很明顯地紅色的線完整的 f 擬合training data,但是testing data所造成的誤差很大,有high variance及overfitting的情況。

Ridge Regression就是產生一條新的線(藍色線),不要那麼完整地擬合taining data。

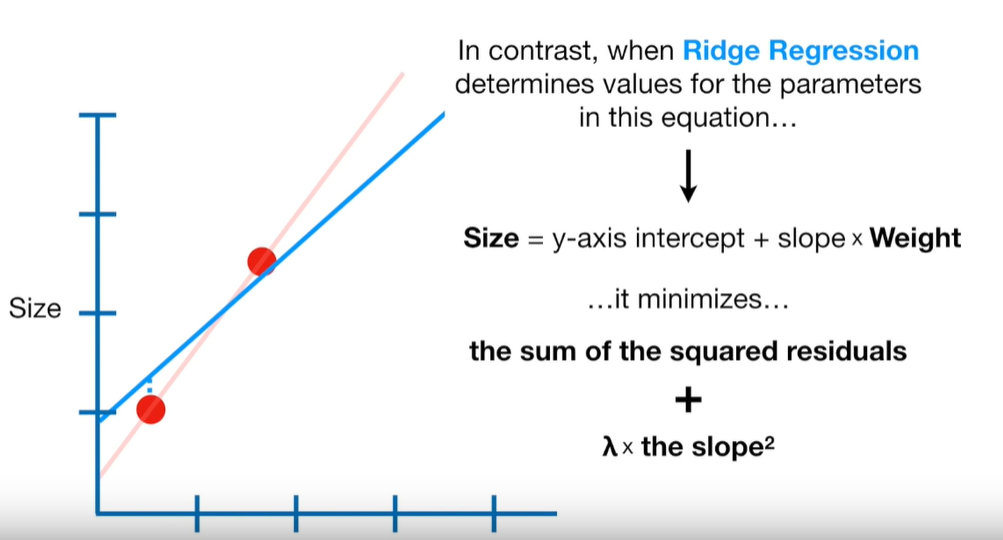

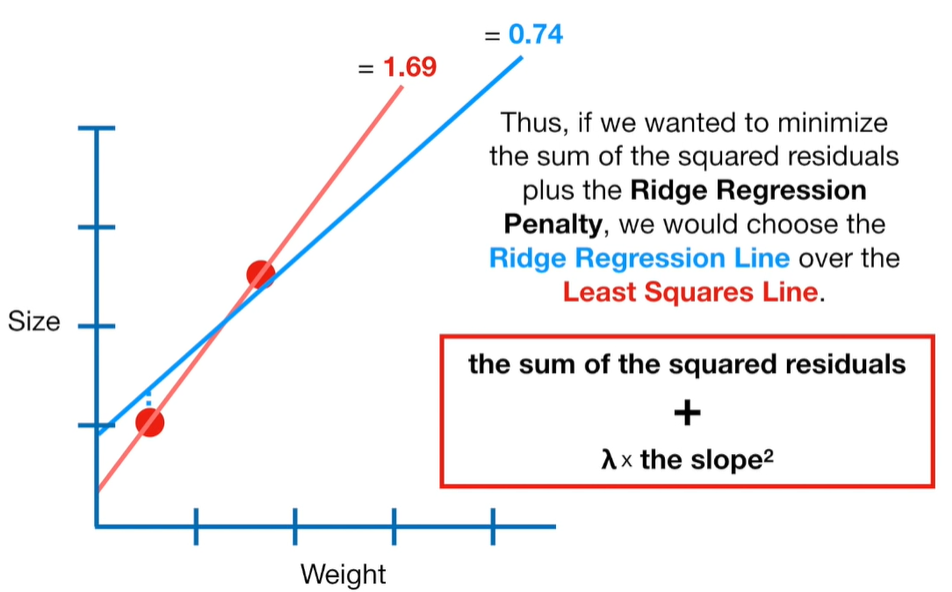

之前的章節有提到一個model的好壞必須要有一個目標函數來衡量它,也就是loss function,這邊是MSE(mean square error)為例子,以下圖紅色線來說,它的MSE為0,藍色線MSE > 0。現在加入懲罰項(是不是有點熟悉的感覺),重新計算兩條線的error,可以發現藍色線是比較小的,所以藍色的線條雖然減少對training data擬合的程度,但是能夠提高對testing data 擬合的程度。

講到這邊應該很熟悉吧!!之前在討論Regularization也有提到,只是那個時候沒有給它特別的名字,所以如果對ridge regression不熟的可以再對照之前所講的,可能才會更加了解。