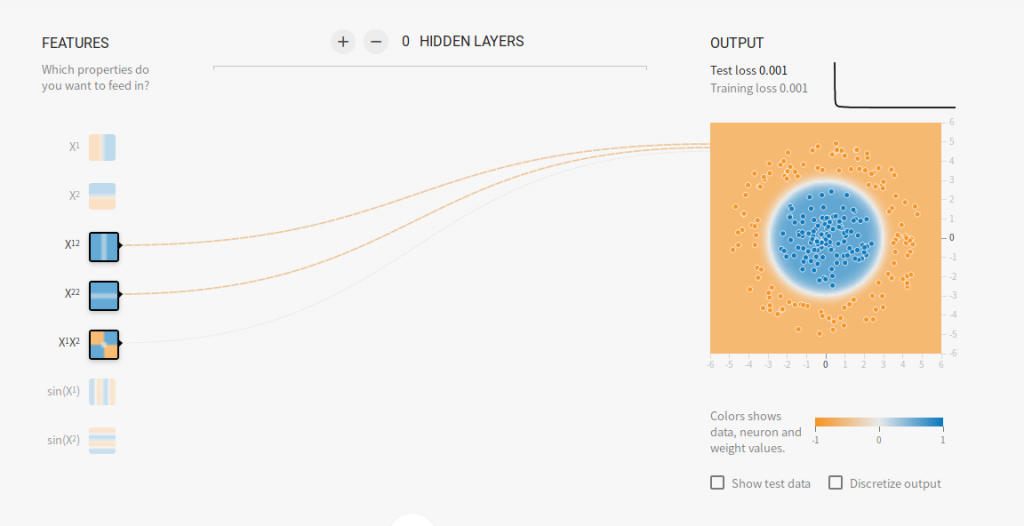

Deep neural networks let you have many layers, and since each layer combines the layers before it, DNNs can model complex multidimensional spaces.

所謂Feature Cross是不同Feature相互結合成一個Feature。譬如Feature A 和 Feature B相乘為AxB,AxB就是一個Feature。但是AxA也是Feature Cross,這表示A與自己發生Cross。Tensorflow Platform列出的就是Feature Cross。當然的,A的立方、四方、多方也都是。

The larger your data, the smaller you can make your boxes, and the more finely you can memorize.

類神經網路可以有多層結構。隱藏層越多,類神經網路有強大的變形能力。就像是原本九宮格去判斷每的格子的類別,會有些粗糙,但是細分後可以判斷的更細緻。

Still, you should realize that feature crosses are about memorization, and memorization is the opposite of generalization which is what machine learning aims to do.

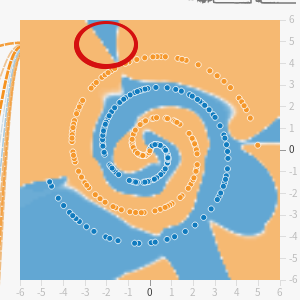

不過強大的變形能力,也就沒有一般性的能力。在訓練初期,可能出現預期外的結果。

此外,複雜的網路結構,也可能造成訓練緩慢,更難以解釋模型。因此在兩者需要斟酌考量,有時候簡單的模型也就有很好的結果。