在前兩天的文章分別介紹了Kubernetes CSI及Ceph,接著今天就來介紹部署Ceph的Cluster以供Kubernetes CSI串接儲存的使用。

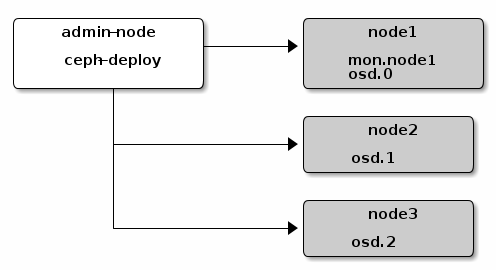

首先在部署Ceph的Cluster我們選擇使用ceph-deploy這個官方所提供的部署工具,只要部署的node(同時也是管理的node)擁有ssh及python的環境並能夠連線至cluster內的各個node,即可做部署的動作。

包含deploy node、monitor node及cluster內所有作為osd的node皆使用Ubuntu 16.04

首先將Ceph repositories加到deploy node,接著安裝ceph-deploy。

wget -q -O- 'https://download.ceph.com/keys/release.asc' | sudo apt-key add -

將{ceph-stable-release}替代為Ceph release的版本號(e.g., luminous.)

echo deb https://download.ceph.com/debian-{ceph-stable-release}/ $(lsb_release -sc) main | sudo tee /etc/apt/sources.list.d/ceph.list

sudo apt update

sudo apt install ceph-deploy

mkdir my-cluster

cd my-cluster

5.建立各node的hostname方便部署使用sudo vim /etc/hosts

更改為

127.0.0.1 localhost

10.0.0.1 ceph-01

10.0.0.2 ceph-02

接著,為了使用deploy node直接將ceph部署至cluster內的node需配置無密碼訪問

ssh-keygen -t rsa

cat ~/.ssh/id_rsa.pub

將cat出來的內容複製到各node

vim .ssh/authorized_keys

須在各節點安裝python2.7

apt-get install python

ceph-deploy new ceph-01

ceph-deploy install --release luminous ceph-01 ceph-02

ceph-deploy mon create-initial

ceph-deploy admin ceph-01

須先查看各節點可用的硬碟名稱

sudo su

lsblk

ceph-deploy osd create --data /dev/sdb ceph-01

ceph-deploy osd create --data /dev/sdb ceph-02

查看osd狀態

ceph osd tree

建立名稱為foo的mgr服務

ceph-deploy mgr create ceph-01:foo

啟動 mgr dashboard

sudo ceph mgr module enable dashboard

16.安裝RGW

ceph-deploy --overwrite-conf rgw create ceph-01

17.建立MDS

ceph-deploy mds create ceph-01