昨天大略提了機器學習的複雜性造成的問題,

今天就要續談因為這個複雜度的問題,

所以近年逐漸受到關注而產生的新領域

「可以解釋的人工智慧(Explainable AI, XAI)」

(因為太長了,所以下面就用XAI簡稱)

基本上我前幾篇提到的一些議題,

近年來在很多國家都漸漸開始有在重視,

也因此國際會議上或是業界,

還有法規的倡議者,

都有在討論我們需要追求人工智慧的可解釋性。

其實人工智慧需要可以被解釋的這件事,

早在人工智慧的上一個世代,

也就是所謂「專家系統(Expert System)」

還很紅的時候,就有人在說。

當初最常見的應用是一些醫學診斷的應用,

他們的設計基礎是基於大量規則,

然後透過邏輯推演,去作出診斷。

但醫生或病人都會想知道這個診斷的基礎,

所以當初的作法是讓AI將邏輯推演的過程列出來,

作為他的判斷的解釋。

但當初這種做法,

一來大量的邏輯解釋並不一定能讓人理解,

再來當初很多診斷可能也不是特別準,

所以並沒有獲得大家的接受,

隨著AI的上個世代漸漸沒落,

不論是專家系統或是那些解釋的方式,

都漸漸消失在檯面上了。

這最近這波AI風潮裡,

XAI大致可以分成兩種作法。

一種是讓AI本身在設計上,

就使用較能以人類直覺理解的模型。

另一種則是發展出像是事後分析的方法,

去反推模型到底怎麼做判斷的。

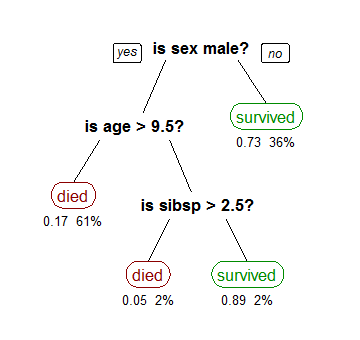

前者的例子,像是決策樹一般是被考慮成本身可以被解釋的模型。

例如下面這個決策樹的例子:

(圖片來源:https://commons.wikimedia.org/wiki/File:CART_tree_titanic_survivors.png)

他就是使用性別、年齡、同船的兄弟姐妹數量,

作為推斷鐵達尼號裡成功生存的機率為何。

雖然這樣的例子還算好理解,

但事實上當決策樹的特徵值非常多的時候,

能夠生成的樹就非常大棵,

人也不一定能夠理解(跟專家系統的問題有點像)。

後者的作法,

近年來比較流行的有LIME、SHAP、Integrated Gradients。

基本上他們都是假設模型的內容未知

(也就是我們不會知道一個機器學習的模型實際的設計為何),

透過改變特徵值後,模型預測的內容如何改變,

去推斷出該模型在一個資料點上,

是如何去做判斷的。

這種針對一個資料點去解釋的方式,

稱為局部解釋(Local Explanation)。

而如果一個解釋是考量到模型整體的行為,

那就會是全局解釋(Global Explanation)。

除了這些偏理論產生的解釋外,

整個人機互動裡面近幾年也有很多研究,

是針對各種模型去設計介面,

讓開發模型的人可以互動地與資料、模型的資訊以及他的行為互動。

藉此可以做探索式分析,幫助開發者了解模型行為。

即使XAI已經成為一個通用的名詞,

人工智慧的可解釋性,還是距離理想差得遠。

例如上面提到的解釋方法,

很多時候也只能計算出一些數值,

這些數值就代表了模型的解釋嗎?

這些數值就能夠被人理解嗎?

人知道拿到這些東西之後可以幹嘛嗎?

這些都還是未知數。

然而人機互動領域與機器學習/人工智慧領域,

其實在學術的世界裡的交集是很少的。

做人機互動的人,不一定能了解機器學習領域;

做機器學習的人,也可能不瞭解人類世界的複雜度,

無論是在做使用者研究或是對於人類行為的假設,

都可能太理想化。

這些都是為什麼我在標題裡加上了一個問號,

也是值得未來的人們,繼續去努力的。