OK,資料分析做完了,

現在要進入演算法的部分,

我們未來幾天將從經典卷積神經網路架構中,

尋找適合FER2013資料集的演算法。

最後經由實驗挑出最佳的CNN演算法。

在實驗結果出來之前,

請讓我來介紹一些知名CNN架構吧!

在唐朝,劉禹錫的〈陋室銘〉曾書「山不在高,有仙則名。水不在深,有龍則靈」。

但是,在深度學習的領域應該改為「山就要高,有ResNet則名。水就要深,有VGG則靈」

西元2014年,

〈Very Deep Convolutional Networks for Large-Scale Image Recognition〉橫空出世,

當時沒有人想到,居然有神經網路可以深到16層,甚至是19層。

它就是VGG Net。

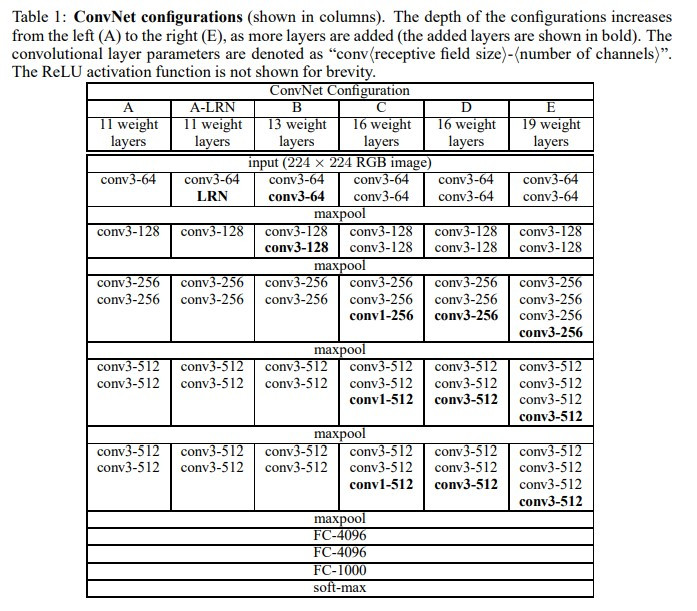

表格中D欄和E欄分別代表VGG16和VGG19的神經網路架構,

可以發現兩者架構基本一樣,只是VGG19多了3層卷積層。

VGG的架構可以說是十分簡單,

但在當時可是一大創新!

相較於AlexNet的成功,

VGG用多個小卷積核取代單一大卷積核的操作看似隨意,

但背後的意義卻非常有道理。

實作部分請參考明天的文章