Scaled Exponential Linear Unit 比例指數線性單元

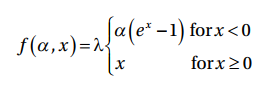

Scaled exponential linear unit (SELU)使用函數計算neuron的輸出:

其中λ = 1.05070098 和? = 1.673263,這些數值是固定的且在backpropagation期間也不會改變。

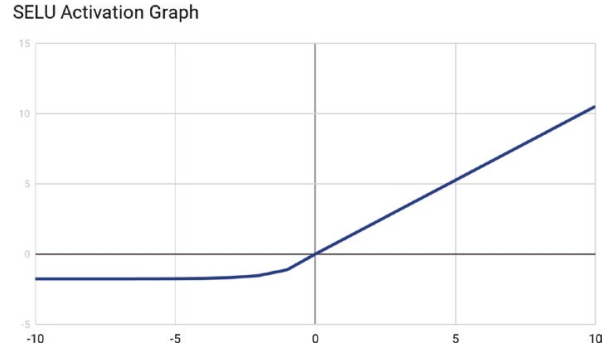

SELU擁有自行正規化的屬性,SELU生成的輸出皆是均衡值0與標準差1進行正規化。

為何需要在意產生正規化的輸出呢? lecun_normal初始化函數將網路的參數初始化為正態分佈或高斯分佈。SELU也會產生正規化的輸出,這表示整個網路存在正規的行為,因此最後一層的輸出也會是正規化的。

借助SELU,學習能力方常強大且允許訓練有多層的網路。

由於SELU的整個網路架構是自我正規化,計算非常有效率且傾向快速收斂。另一個好處是它能夠克服當輸入特徵太高或太低時,梯度爆炸或消失的問題。

Softplus Activation Function

Softplus Activation Functionu對函數值z進行平滑處理。

Softplus Activation Function也被稱呼為SmoothReLU function。

Softplus的一階導函數是1/(1+e-z) ,與sigmoid activation function相同。

Softmax

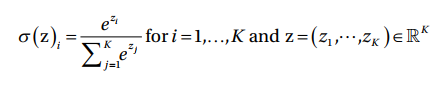

Softmax是一種利用實數的輸入向量,將資料正規化為機率分佈,並產生介於0至1的輸出

且輸出之總和為1的函數。

Softmax是最常被使用於分類神經網路的最後一層(輸出層)的激勵函數,結果將會被編譯成每個類別的預測機率。

Softmax的轉換是使用此函數作計算:

接下來會介紹損失函數 Loss function~