Nertal network(NN)的概念其實很早就發明出來了,但直到1986年backpropagation應用在NN做出很好的結果之後才開始被大家重視,今天就來講一下NN的基本架構:

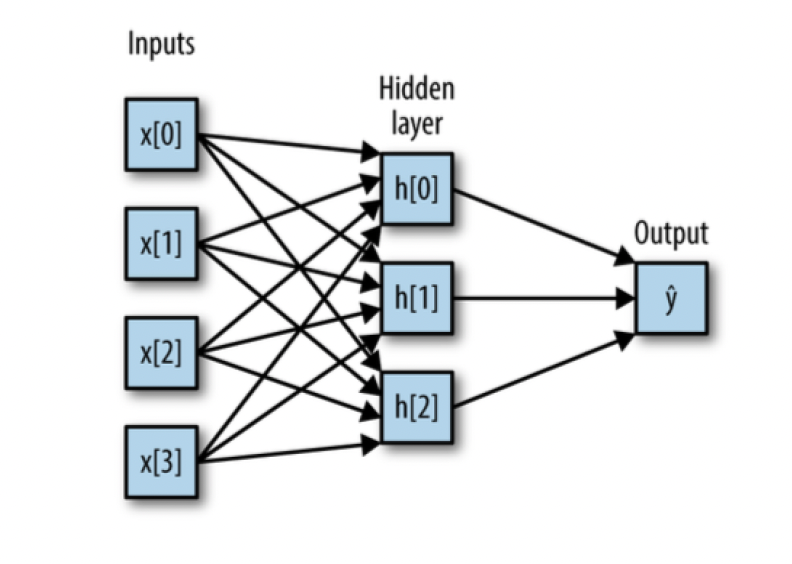

基本來說NN主要會有三層架構:input, hidden layer, output。input也就是我們放入的訓練資料,以上圖來說資料有四個features(predictors),hidden layer是整個NN的核心,我們可以自由決定要有多少層hidden layer以及每一層要有幾個nodes,以上圖來說我們只有一層hidden layer,之中有三個nodes(h[0],h[1],h[2]),最後的output就是我們的預測值(y hat)。

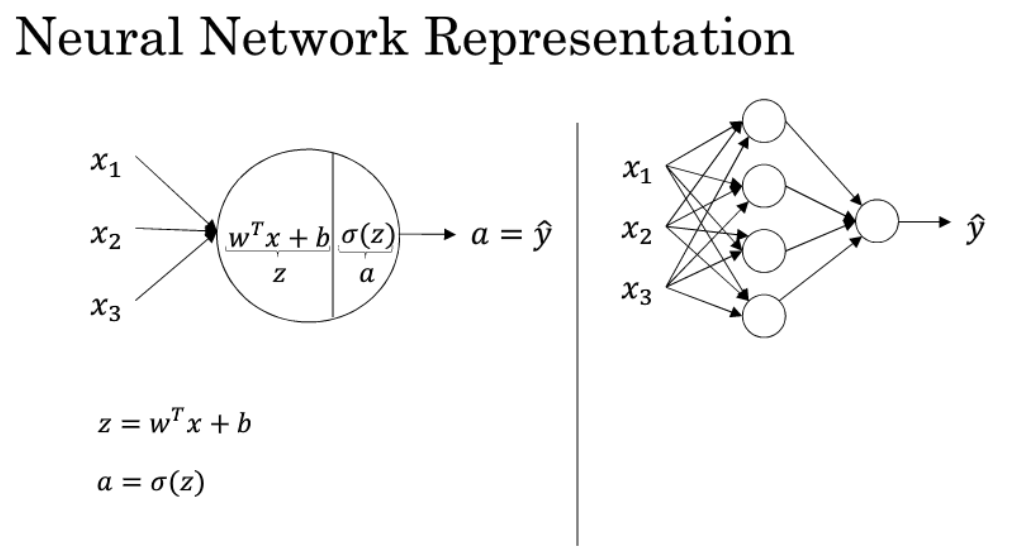

在每一個hidden layer裏都會包含linear和non-linear的方程式(你可以把它想像成一個三明治,間單只看一個結的的話就會長的如下左圖:

z的部分就是linear,而sigma則是non-linear。wT是transpose,可以把它當成簡寫就好,全部展開就是z= w1x1 + w2x2 + w3x3 + b;non-linear又稱為active function所以很常簡寫為a,在非線性的部分我們可以有很多選擇,像是tahn, sigmoid, Relu, leaky Relu,可以發現如果選擇sigmoid的話每個node就會是一個logistic regression~

NN的重點就是在把w和b優化,找出最小的cost function,cost function也有很多種,他的概念就有點像我們一般在做回歸問題時衡量的MSE,有就是預測與實際的差距拿去加總再平均,而找出最佳的w和b的方法就是我們之前提到的gradient descent。

[reference]

https://www.slideshare.net/ccckmit/ss-69447809

http://wiki.hacksmeta.com/machinelearning/deeplearning/neural-networks-basics.html