昨天介紹完CNN卷積神經網路正向傳播程式,今天要來研究CNN卷積神經網路反向傳播程式:

首先在上次全連接層Softmax做反向傳播:

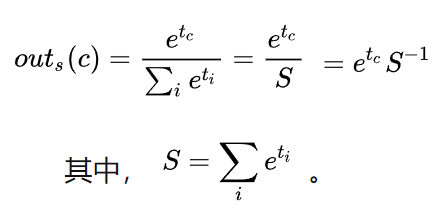

首先依照之前說明的機率out:

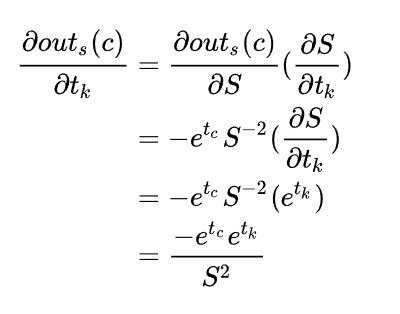

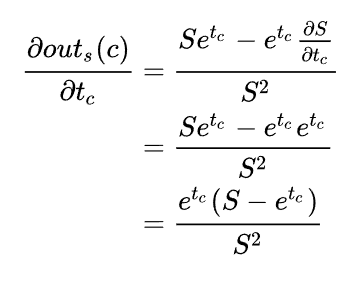

把它做偏微分並使用chain rule:

會有以下兩種情況

1.c≠k

2.c=k

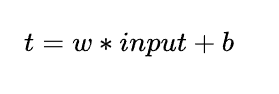

然後依照

我們可以得到偏微:

在依照chain rule

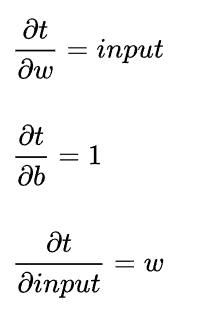

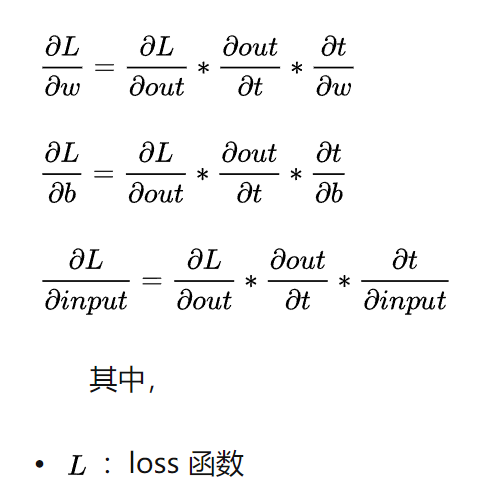

其中,我們最終想要這三個微分

所以全連接層反向傳播程式如下:

在原本class:Softmax上加上反向運算def

#全連接層反向傳播

def backprop(self, d_L_d_out, learn_rate):

for i, gradient in enumerate(d_L_d_out):

#如果沒有梯度就下一個

if gradient == 0:

continue

#exp(tc)-->分子

t_exp = np.exp(self.last_totals)

#S-->分母

S = np.sum(t_exp)

#dout/dt k != c 情況

d_out_d_t = -t_exp[i] * t_exp / (S ** 2)

#dout/dt k == c 情況

d_out_d_t[i] = t_exp[i] * (S - t_exp[i]) / (S ** 2)

#dt/dw

d_t_d_w = self.last_input

#dt/db

d_t_d_b = 1

#dt/input 1000 x 10

d_t_d_inputs = self.weights

#dL/dt = dout/dt*梯度

d_L_d_t = gradient * d_out_d_t

#dL/dw = dt/dw*dL/dt (1000, 1) @ (1, 10) = (1000, 10)

d_L_d_w = d_t_d_w[np.newaxis].T @ d_L_d_t[np.newaxis]

#dL/db = dL/dt*dt/db

d_L_d_b = d_L_d_t * d_t_d_b

#dL/dinputs = dt/dinputs*dL/dt (1000, 10) @ (10, 1)= (1000, 1)

d_L_d_inputs = d_t_d_inputs @ d_L_d_t

#更新權重還有bias

self.weights -= learn_rate * d_L_d_w

self.biases -= learn_rate * d_L_d_b

return d_L_d_inputs.reshape(self.last_input_shape)

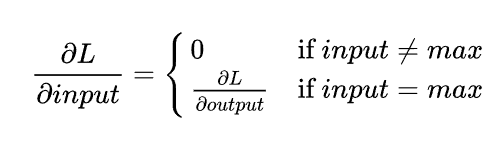

接下來是池化層:

基本上非最大值在微分後就會是0,所以如下圖:

所以程式如下,在原本class:MaxPool2加上反向運算def

#反向運算

def backprop(self, d_L_d_out):

#dL/dinput -->一開始設置為0

d_L_d_input = np.zeros(self.last_input.shape)

for im_region, i, j in self.iterate_regions(self.last_input):

h, w, f = im_region.shape

#找尋那區域最大值

amax = np.amax(im_region, axis=(0, 1))

for i2 in range(h):

for j2 in range(w):

for f2 in range(f):

#如果是最大值就把剛剛dL/dinput傳入這層dL/dinput

if im_region[i2, j2, f2] == amax[f2]:

d_L_d_input[i + i2, j + j2, f2] = d_L_d_out[i, j, f2]

return d_L_d_input

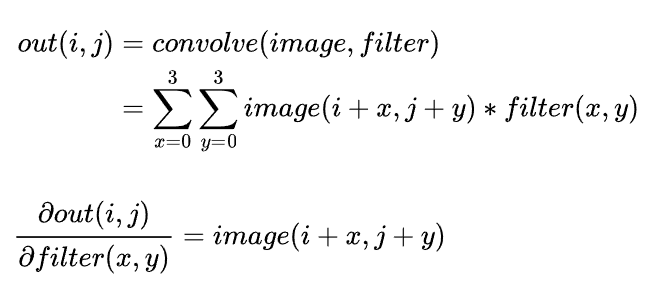

最後反向給卷積層:

所以他的偏微就是那張照片範圍:

程式如下:在class:Conv3x3加上反向運算def

#反向運算

def backprop(self, d_L_d_out, learn_rate):

#dL/dfilter --> 一開始設置為0

d_L_d_filters = np.zeros(self.filters.shape)

for im_region, i, j in self.iterate_regions(self.last_input):

for f in range(self.num_filters):

#dL/dfilter = sum(dL/dout*照片區塊)

d_L_d_filters[f] += d_L_d_out[i, j, f] * im_region

#調整一開始filters 用學習率*dL/dfilter

self.filters -= learn_rate * d_L_d_filters

(資料來源:https://zhuanlan.zhihu.com/p/102119808並加上註解程式)

好,今天CNN反向傳播程式算是研究完,明天就把CNN的程式完成,並且去跑執行結果

在戒指發光同一時間,原本飄在空中羽毛掉落在地上,剛好掉到娃娃旁邊,原來娃娃在剛剛,終於精疲力盡倒下,而地面上還冒出鮮血和娃娃血液混合再一起,當羽毛碰到血的時候.羽毛突然產生變化,幾秒鐘之後,出現了一隻狐狸,只不過這隻狐狸沒有嘴巴,而且四肢通紅,狐狸環顧四周後,隨即抬起紅色爪子,而此時前方樹木開始燃燒,最終燒成灰燼,而前方赫然就是森林出口

--|你們到底是誰?為何要如此執著?|-- MM.CS