在前幾篇有提到關於 Ensemble 這個名詞,是之前都沒學過的東東,所以今天想要來一起了解這是個啥,其實我已經感受到我的鐵人賽學習順序非常混亂,但就先這樣吧,我也沒有什麼大綱。題外話今天烤肉,所以趕在下午前要打完

這邊來一些概念補充

噪聲( Noise )

噪聲是隨機性或錯誤,來自測量或資料收集過程,引入資料的不規則變化

- 來源: 多個來源,例如傳感器不準確、資料干擾、輸入錯誤等

- 影響: 影響資料的準確性和可靠性,過多噪聲會導致模型性能下降

結合多個基本機器學習模型的預測來提高模型的性能的技術,這些模型可以是不同算法,也可以是同一算法的變種,就像是小組中大家都會有各自擅長的方面,小組整體就能補足每個人的弱項,多個模型的結合一樣可以彌補單一模型的弱點,來獲得更好的整體性能

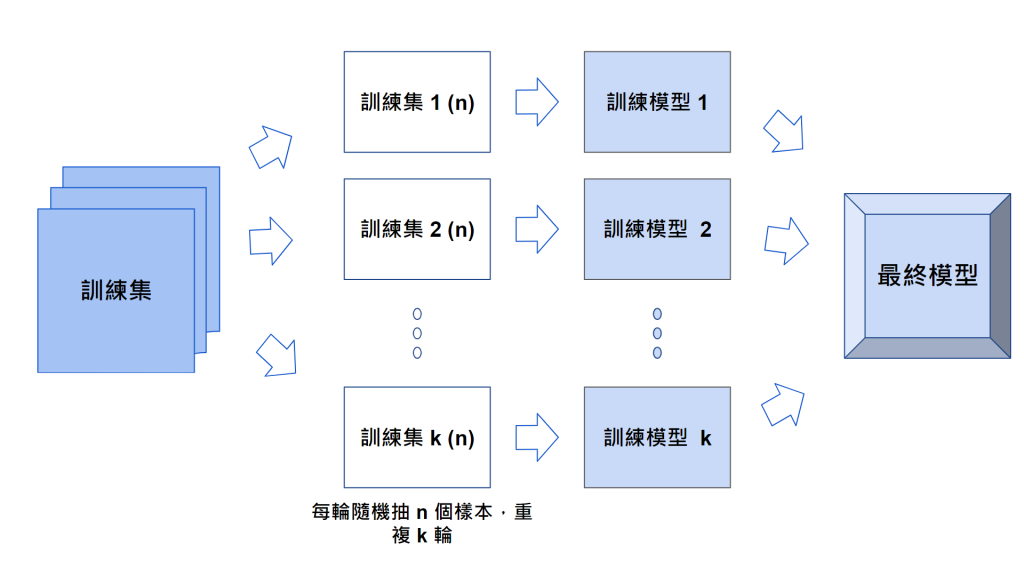

通過從訓練資料中隨機抽取多個子樣本,然後分別使用這些子樣本來訓練多個分類器(也可以是迴歸器),最後通過對分類器的預測結果進行投票或平均來獲得最終預測( Random Forests 就是 Bagging 方法的例子)

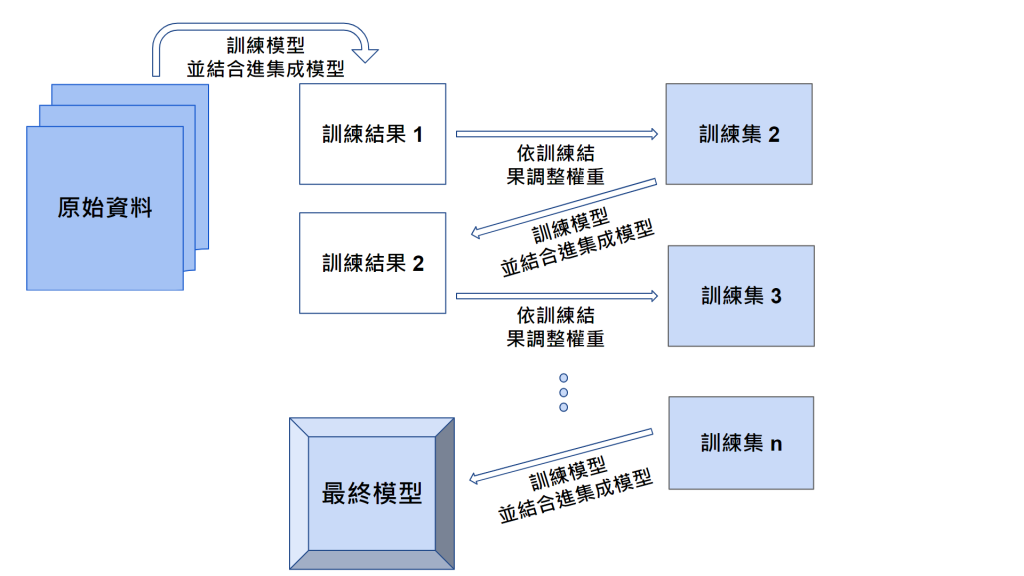

將多個弱學習機(性能略優於隨機猜測的分類器)組合成一個強大的分類器,通過不斷調整樣本的權重,讓新的分類器更加關注之前錯誤分類的樣本,以迭代的方式不斷改進模型,特別關注之前的錯誤,以提高預測性能

https://chih-sheng-huang821.medium.com/%E6%A9%9F%E5%99%A8%E5%AD%B8%E7%BF%92-ensemble-learning%E4%B9%8Bbagging-boosting%E5%92%8Cadaboost-af031229ebc3

https://easyaitech.medium.com/%E4%B8%80%E6%96%87%E7%9C%8B%E6%87%82%E9%9B%86%E6%88%90%E5%AD%A6%E4%B9%A0-%E8%AF%A6%E8%A7%A3-bagging-boosting-%E4%BB%A5%E5%8F%8A%E4%BB%96%E4%BB%AC%E7%9A%84-4-%E7%82%B9%E5%8C%BA%E5%88%AB-6e3c72df05b8