前言:昨天我們架設的卷積神經網路使用了 2 個卷積層 + 1 個最大池化層。

昨天架設的CNN只是最基本的,事實上兩個卷積層與一個最大池化層,這樣的組合可以稱做卷積池化區塊 (conv-pool block),而實務上的CNN中並不會只有一塊卷積塊,是將數塊堆疊起來提高網路的性能和表現。可是當堆疊越多、神經網路變得更複雜,就越容易引發梯度消失的問題。為了解決這個問題,殘差神經網絡(Residual Neural Network,簡稱ResNet)就問世了。

複習時間:梯度消失是指在反向傳播過程中,梯度值變得非常小,會導致訓練過程變得非常緩慢,或損失函數不斷波動,沒有朝最小值或最優解靠近。

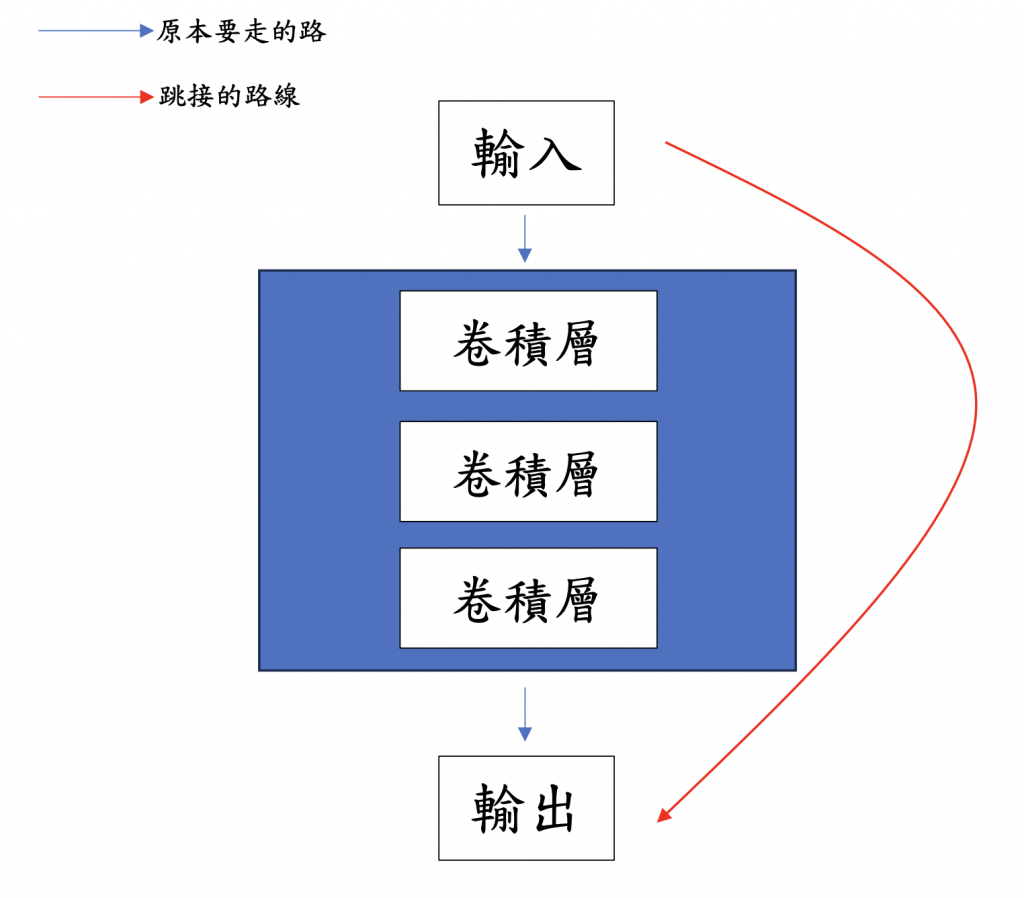

ResNet的關鍵是使用殘差模組 (residual module)或叫做殘差塊(Residual Blocks)的東西,這些殘差包含了一個既能叫做:跳躍連接(skip connections),允許部分運算輸入跳過一個或多個神經層、卷積層直接傳到輸出層。這樣的設計幫助我們在神經網路很多層下,也能夠容易訓練,減少梯度爆炸或是梯度消失。

殘差的用作可以簡單看成: 殘差 = 學到的特徵 - 輸入

如果今天我們執行一層卷積層,但什麼都沒有學到,理所當然特徵是0,而殘差也會是0。所以輸出結果就會跟輸入結果一模一樣,這就叫做「恆等映射」或是「恆等函數」。在這樣的設計下,就算沒學到新的特徵,也能夠跳過直接進入輸出階段,具備了「抄捷徑」的能力。

我們學習架構了那麼多的機器視覺模型,最後就把可以應用的地方留到明天吧!