前一天講了 text-generation-webui,今天來講另一個也是拿來做文字生成工作的工具,Ollama

這次為何要使用這個呢,其原因也是我覺得 Ollama 某方面的表現優於 text-generation-webui,如 VRAM 使用量,生成速度等等的優點。

Ollama在 github 上有 8.5 萬顆星的 MIT 開源專案,它能讀的模型不像昨天的開源專案一樣,能支援各種不同的大型語言模型,Ollama 只能吃 ".gguf" 格式的模型,但其優點是將大型語言模型的權重儲存在記憶體(RAM)中,不再那麼依賴 VRAM 的硬體門檻。

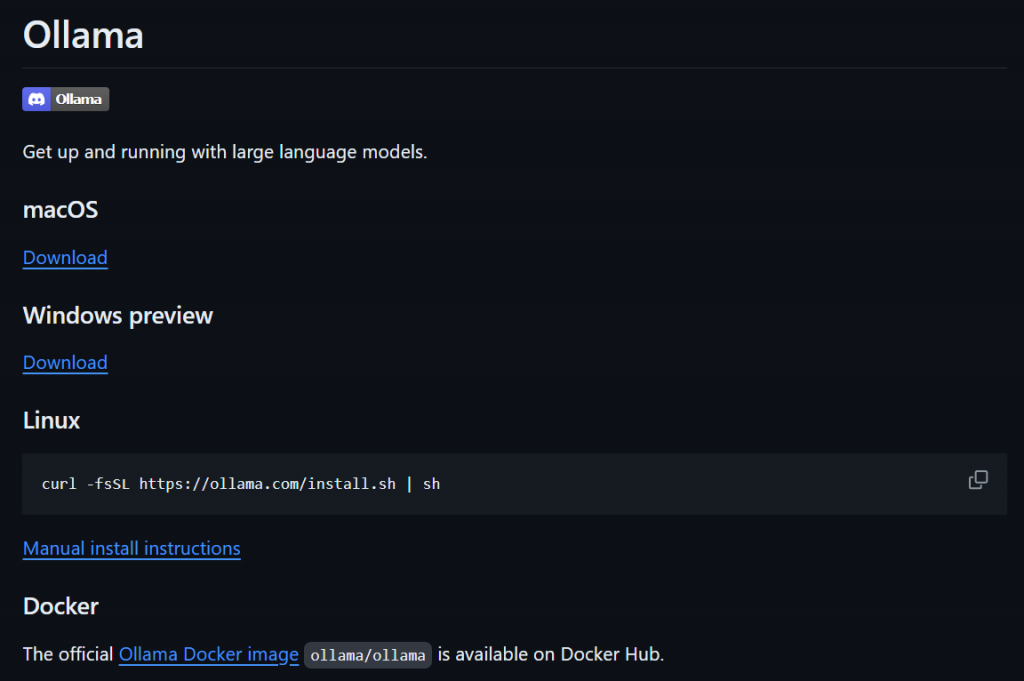

安裝方法也極其簡單,首先先來到 ollama 的 repo 頁面

Linux 系統使用者只要輸入以下指令即可,windows 的話則需下載 exe 檔

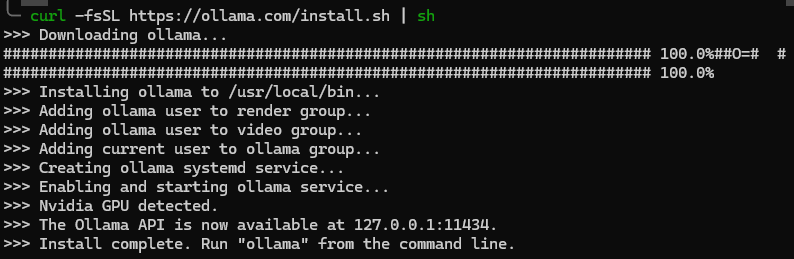

curl -fsSL https://ollama.com/install.sh | sh

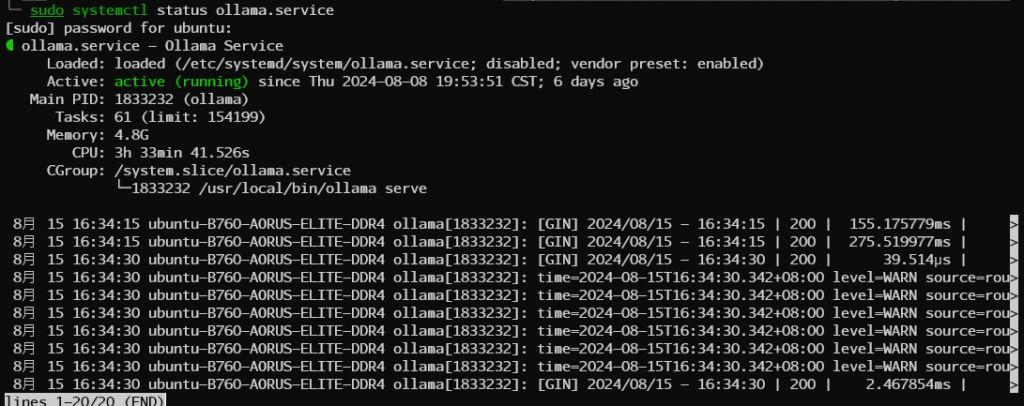

The Ollama API is now available at 127.0.0.1:11434以後會考可透過 systemctl 確認服務運行狀況

確認 status 為 active 狀態後就可以開始下載模型了

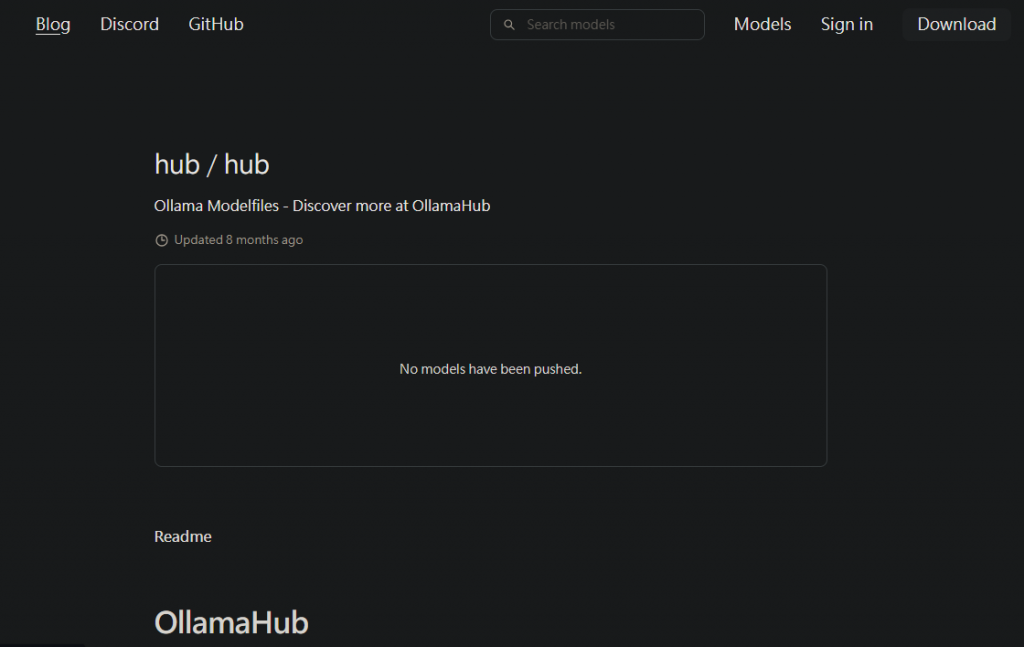

官方也提供了一個與 Huggingface 相似的網站,專門拿來存放使用者們上傳的語言模型

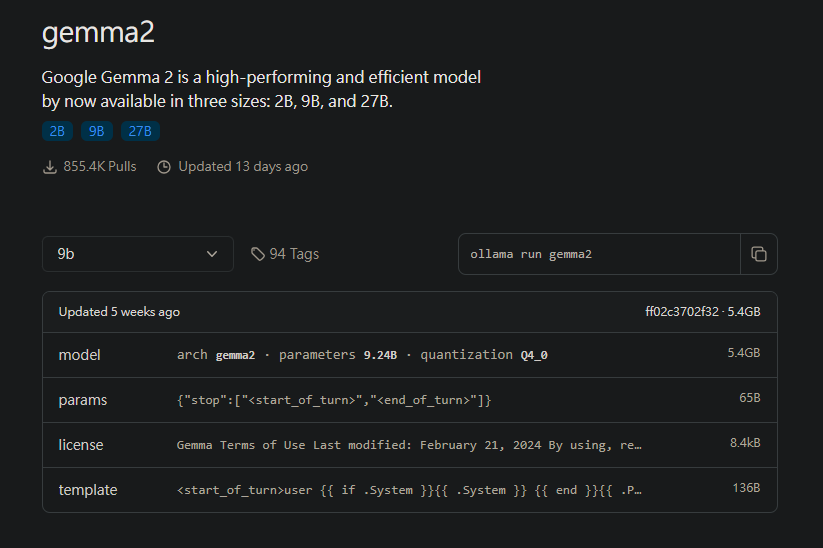

本篇範例將使用 Google 釋出的 Gemma2

因此在終端中輸入 ollama pull gemma2 就可以下載模型了

(ollama pull 與 ollama run 的效果一樣,只是後者會在下載完模型後自動讀取模型)

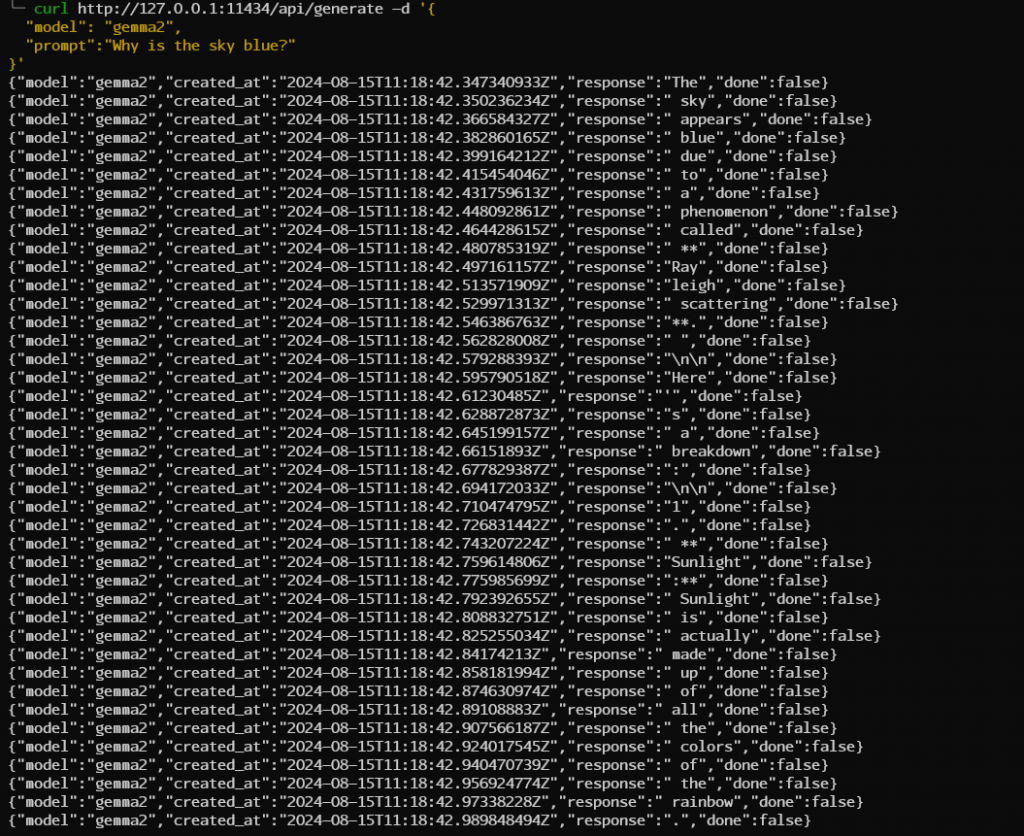

下載完後我們可以透過 curl 工具確認模型的效果

curl http://127.0.0.1:11434/api/generate -d '{

"model": "gemma2",

"prompt":"Why is the sky blue?"

}'