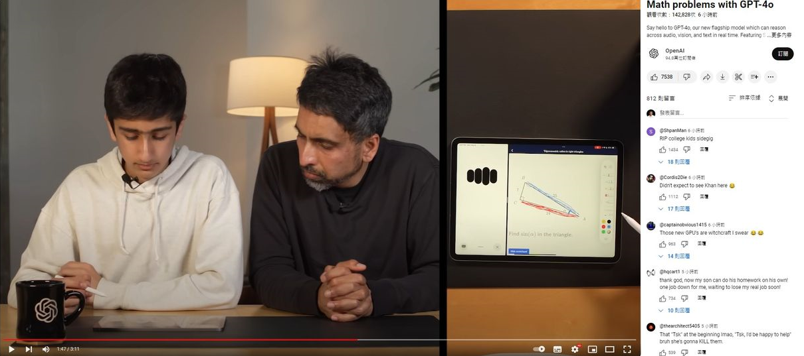

在2024四月Open AI發表了GPT4o, 並進行了一系列案例的展示, 其中底下這個案例完全震撼了筆者, 底下是可汗學院的創辦人, Sal Khan 正在教他兒子三角函數, 然後讓GPT4o可以存取麥克風與螢幕, 然後GPT4o就開始跟Sal與他兒子開始討論數學問題, 過程可以跟它「搶話」、打斷它說話, 彷彿跟真人討論一樣般的絲滑, 回到第一天所提到的工作象限表, 有一個職業因為這個範例將變顛覆, 那就是老師這個行業, 是不是又細思極恐呢? 每每看到這種驚人展示, 腦中都會想起一句經典名言 “你的毀滅與我何干?” , 沒錯這就是科技的進程啊! 現在只能先慶幸一下GPT4o講繁體中文還不太行![]()

https://www.youtube.com/watch?v=_nSmkyDNulk

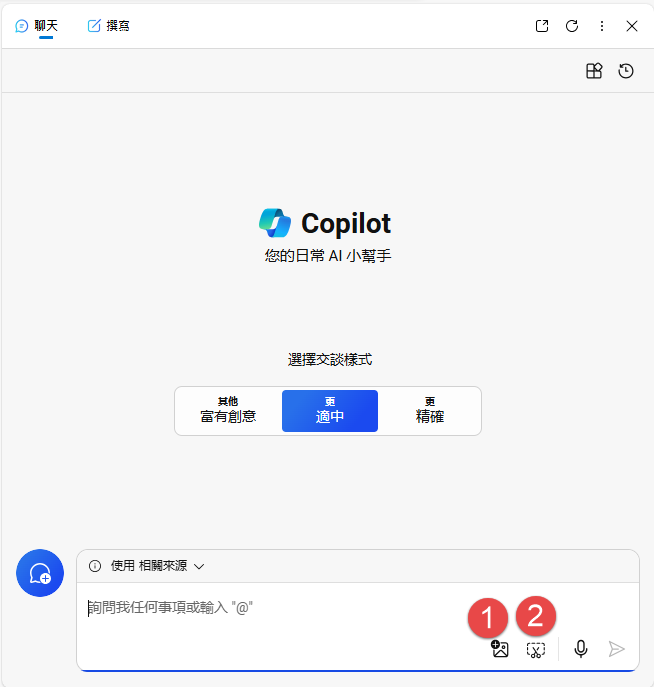

那麼在Copilot Chat怎麼使用這個功能呢? 我們可以直接上傳圖片或是螢幕截圖如下

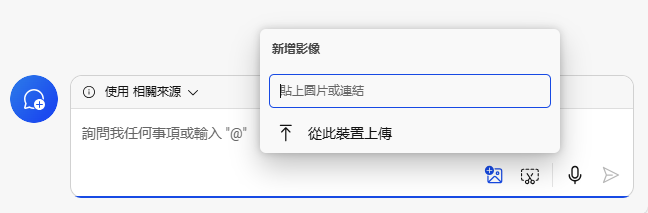

點擊之後可以貼上圖片的網址或是直接從本機上傳如下

點擊之後可以開始擷取螢幕畫面如下

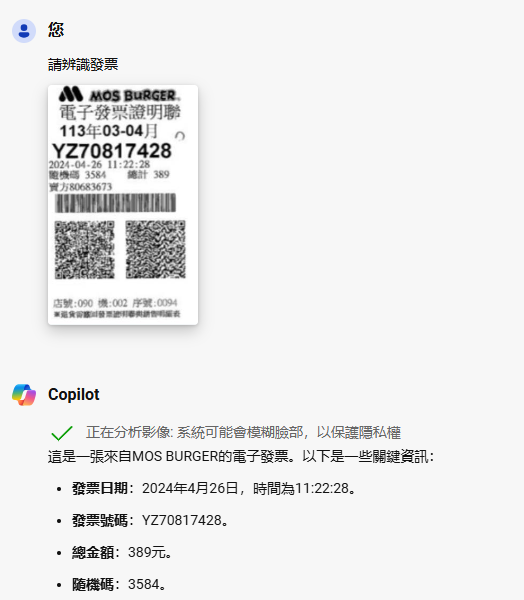

除此之外也可以複製貼上圖片. 接下來就來展示一下Copilot強大的視覺功能如下

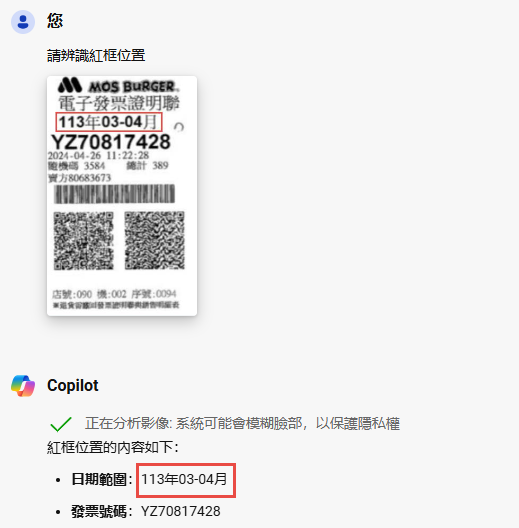

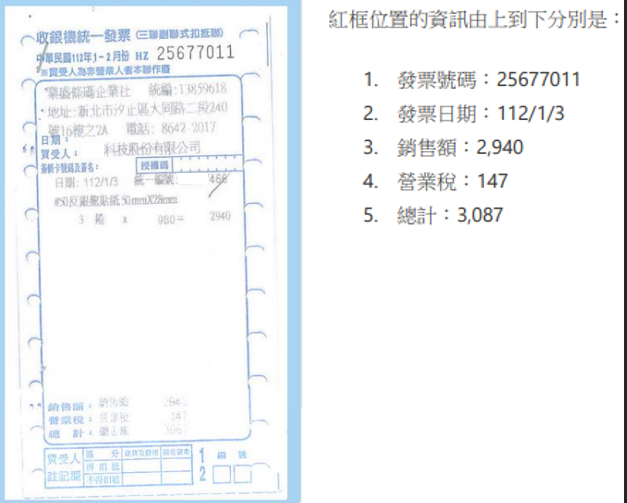

它可以正確無誤地找出發票資訊, 我們還可以指定辨識位置如下

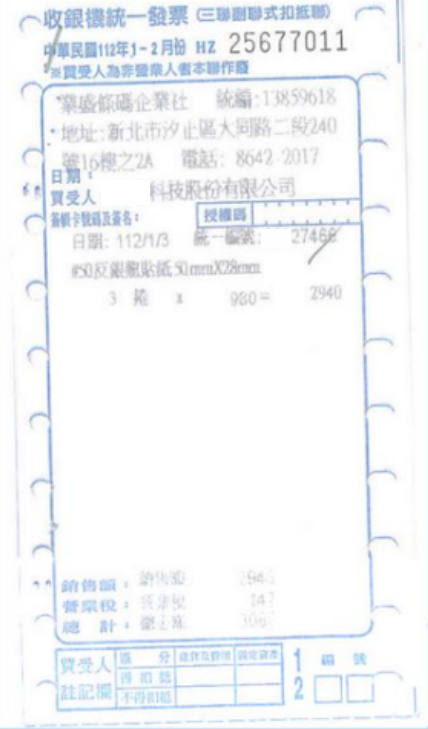

是不是猛猛的? 你可能覺得不過只是OCR辨識, 有必要這麼驚訝嗎? 這邊分享一個筆者實際專案, 去年接了一個台灣發票辨識專案, 做下去才知道台灣的發票種類大概有8種, 由於我們是非專業刻模型團隊, 而是打雜團隊要快速給出解決方案, 於是用Azure Cognitive Services去實作, 用幾十張不同類型的發票, 訓練出模型來使用, 前前後後研究SDK與調整圖形花了一個多月把功能上線, 效果也不錯, 準確率普遍有八成, 發票圖檔若是清晰幾乎可以到9成以上, 但是這個專案遇到底下兩個難題, 我們是排除這兩種發票類型, 才有這樣的準確率, 一個是加油站的點矩陣發票如下

這個辨識不佳, 原因是印刷油墨的關係, 另一種發票則是常見的便利商店發票如下

這種發票辨識不佳的原因是每個廠商的格式都不太一樣, 有長有短. 當然解決這兩種辨識不佳的方法也是有的, 就是要去收集大量發票資料, 然後整理分類建模, 但是對於打雜團隊來說, 做這個CP值太低, 跟使用者溝通後, 發現這兩種每年不過幾十張, 不是大宗, 他們自己手打即可. 但故事還沒結束, 強者我同事, 看到GPT4o的視覺功能後, 就開始等Azure Open AI上架, 上架之後的實驗結果如下

是不是超猛的? 那個模糊的總計3087都被它猜出來, 於是強者我同事花了三天, 就把去年花了一個多月成果給替換, 連訓練都不用訓練, 只要Prompt寫得好, 並補全了這兩種發票類型, 這時那句話又默默地響起” 你的毀滅與我何干?”, 難怪每當Open AI有重大新作發表時, 就有AI新創死一堆啊!!!![]()

https://www.facebook.com/groups/818139776290690

今年弄了個專頁, 歡迎加入討論, 可以收到貼文的更新通知![]()