笑死,

有人把"strawberry"打成"strowberry"並餵給最新的LLMs OpenAI o1,

果不其然,還是算不出來有幾個"r"🤣

再看一個案例,換了一個單字「Raspberry(樹莓派)」,還是沒數對

雖然有時候會成功就是了

為什麼會這樣呢? 我們先來介紹OpenAI o1,再來解釋LLMs 不會算術這件事:

在九月中(2024.09.12),OpenAI釋出了可以邏輯推理的模型OpenAI o1(以下稱o1),它宣稱可以讓LLM更有邏輯的做思考。

o1在國際奧林匹克數學競賽(OMI)中解決了83%的題目,相比於GPT-4o高了70%。在Codeforces程式競賽中也排在前11%,甚至可以解決博士生在解的物理、生物或是化學問題(GPQA)。

根據OpenAI的技術報告,他們以強化學習依據使用者的敘述去生成思維鏈(Chain-of-thought, COT)的提示,教o1如何利用思維鏈去做有效的思考。

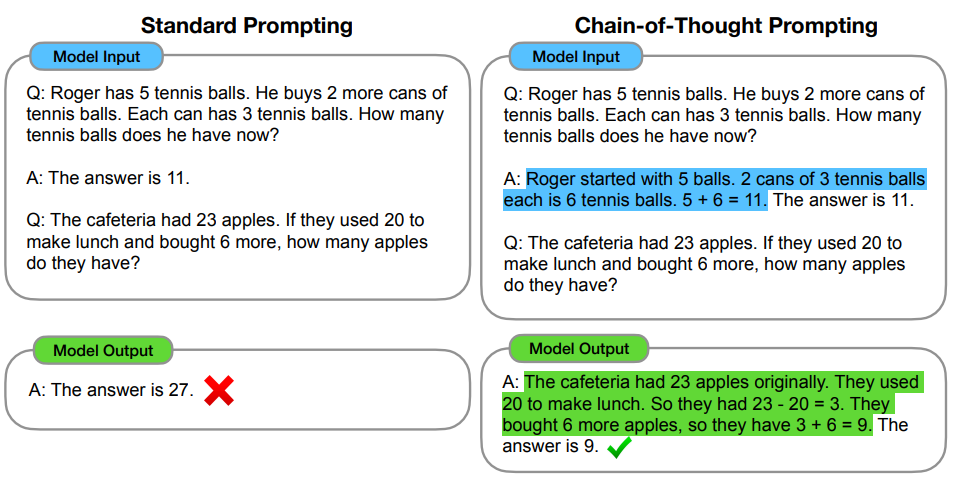

那什麼是思維鏈?

因為像ChatGPT這種大型語言模型是使用語言接龍的方式進行訓練,它並不擅長邏輯推理,所以我們就必須在提示(Prompt)中加一些範例或明確的步驟,也就是像教小朋友慢慢想,叫它從頭去推理來解決較為複雜的問題。

比如說算術問題,給個範例帶著LLMs走一遍,再給它一個新的題目。

那為什麼LLMs經過了這麼多戴的改良,他還是沒辦法準確的解決邏輯問題呢?

原因出在LLMs的輸出層:

LLMs會經過Softmax激活層轉換為機率,而這個機率代表各個字詞出現的機率。

為了讓LLMs的輸出更多元,所以我們使用抽樣(Sample),讓LLMs有機率抽選到機率較低的字詞。

所以這就是為什麼o1 還是有機率會數錯單字有幾個字母。

總而言之,看到o1去數一個寫錯的單字有幾個"r",結果還是數錯,我就感到愉悅。

Reference.

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

How exactly LLM generates text?