隨著大型語言模型(Large Language Models, LLMs)的爆炸性發展,過去認為需要數百張 GPU卡,如今已經能在一台筆電、甚至手機上跑起來。這其中的關鍵推手之一,就是 llama.cpp

llama.cpp是由 Georgi Gerganov 發起的開源專案,最初目標是讓 Meta 的 LLaMA 模型可以在 C/C++ 程式庫中高效執行。隨著社群不斷貢獻,它已經支援了眾多主流模型(LLaMA 2、Mistral、Falcon等),並逐漸演化成一個跨平台、輕量化、高效能的 LLM 推理引擎。

它最大的魅力在於:

傳統 LLM 模型往往需要數十 GB 的 VRAM 才能執行,而 llama.cpp 透過量化技術,將 16-bit 或 32-bit 權重壓縮成 4-bit、5-bit 格式,大幅降低記憶體需求。

這意味著一台只有 8GB RAM 的筆電,也能跑 LLaMA 7B 或 Mistral 7B 模型。

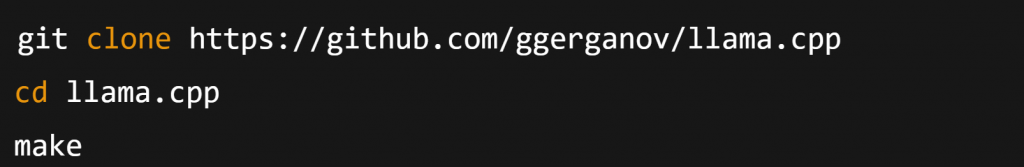

只需幾行命令即可執行:

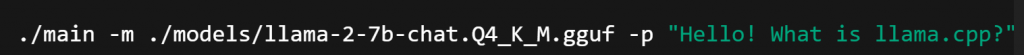

立刻就能和模型對話

在雲端模型快速發展的同時,本地推理(local inference)的需求愈來愈高:

llama.cpp正是讓這些願景落地的關鍵。