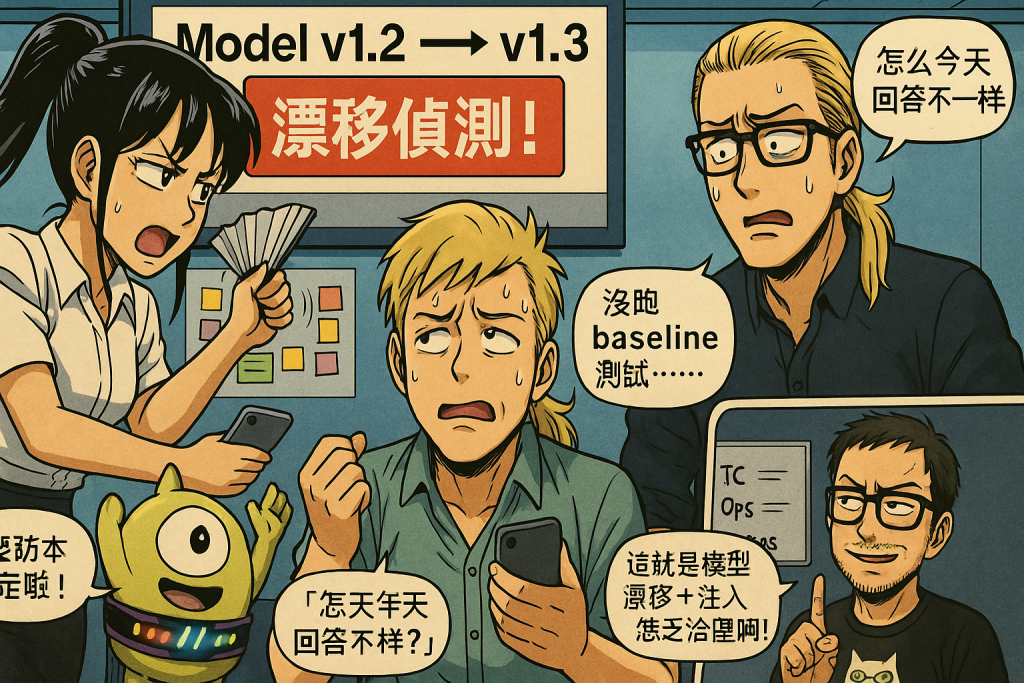

貝老闆(盯著螢幕皺眉):「奇怪,昨天問 AI 它說可以,今天又說不行,到底要聽誰的?」

小可:「老闆,這就是你沒管好模型版本!AI 不是算命仙,今天答一個、明天答一個!」

工程師 King(冒汗嘆氣):「如果沒有版本鎖定,更新了權重或上下文,回應就可能飄來飄去。」

AI 實習生(舉手傻笑):「我昨天偷偷升級了呀!你不喜歡新的我嗎……」

電話那端的好威:「哼,這叫模型漂移,還可能被 prompt injection 趁虛而入。你們沒有做紅隊測試跟安全基線吧?」

AI 模型跟軟體一樣要有版本管理。沒有鎖定就像軟體每次更新 patch 都直接上 production,用戶體驗不一致還可能壞掉。最佳做法是準備「離線評測集」:先在固定測資上跑出 baseline,再決定是否要換版本。就像跑 regression test 確保更新不會造成倒退。

👉 怎麼問 AI?可以輸入:「幫我建立一份評測集(evaluation dataset),內容涵蓋我們常問的 20 個核心問題,讓我在每次更新模型前都能比較輸出差異。」

AI 的輸出可能隨著資料、上下文或外部環境改變而「漂移」。舉例:昨天的金融行情還能回答正確,今天行情一變就亂了。工程上會做「漂移監控」,像設定 KPI(正確率、一致性),超過閾值就要警告。這跟 SLA/SLI 的概念很像。

👉 怎麼問 AI?「幫我建立一個漂移檢測方法,輸入新舊模型輸出的差異,計算一致率,並輸出警示報表。」

AI 不只會飄,還可能被惡意 prompt injection「騙」去做不該做的事。紅隊測試就是故意輸入一些挑釁或越權指令,看 AI 會不會中招。這需要一個固定流程,像安全演習一樣,每次更新都要跑一輪。

👉 怎麼問 AI?「模擬駭客紅隊,幫我測試這個 AI 會不會被越權 prompt 控制,並給出示例攻擊字串。」

把上面三個步驟跑完,就能建立一個安全基線(baseline):哪個版本、什麼表現、什麼限制。未來如果出問題,就能比對新舊基線,快速定位問題。這跟 IT 裡的「金色映像(golden image)」概念很像。

👉 怎麼問 AI?「幫我整理出安全基線的文檔,包含版本號、測試數據、限制條件。」

一句話重點:治理 AI 要像治理軟體一樣,版本、測試、監控一個都不能少。

你有沒有遇過 AI 今天答一個、明天答一個的情況?如果要你設計一個「漂移檢測」的方法,你會怎麼做?