還記得我們在 Day05 的時候有講過,Claude 在面對任務的時候會根據任務的複雜度,決定它要用怎樣的處理策略。那今天要討論的內容,就是關於這些它背後的處理策略是如何被實施的了。

對非技術背景的人丟出這樣一個問題——「AI 會思考嗎?」或許可以分成兩種不同的反應

對於閱讀到這邊的你來說,目前是怎麼想的呢?

其實在很早期 ChatGPT 才剛出來沒多久的時候,那個時期的提示詞技術就有一招很有名的技巧叫做**「思維鏈」(Chain of Thought,簡稱CoT)**,那篇論文目前已經快被引用 2 萬次了!

簡單來說,就是把一個比較複雜的問題,讓模型逐步推論中間的各種步驟之後再得出最後結論,以得到更準確 or 有邏輯的回答。

這個概念看起來好像很簡單,但當時真的是讓許多模型都發揮出比起一般狀態下好非常多的成果,因此也是很多地方在講解到提示詞技巧的時候很常提到的內容。

但既然這樣的技巧是這麼簡單且有效的,為什麼一定要讓用戶來做這件事情呢?就不能請 AI 模型服務商把它整合起來嗎?事實上也確實是這樣發展的,在後來各家服務商所推出的 推理模型(Reasoning language model) 就是把這樣的過程內建在語言模型裡面的,透過將任務步驟拆解之後再逐步靠近最後的解答的過程。

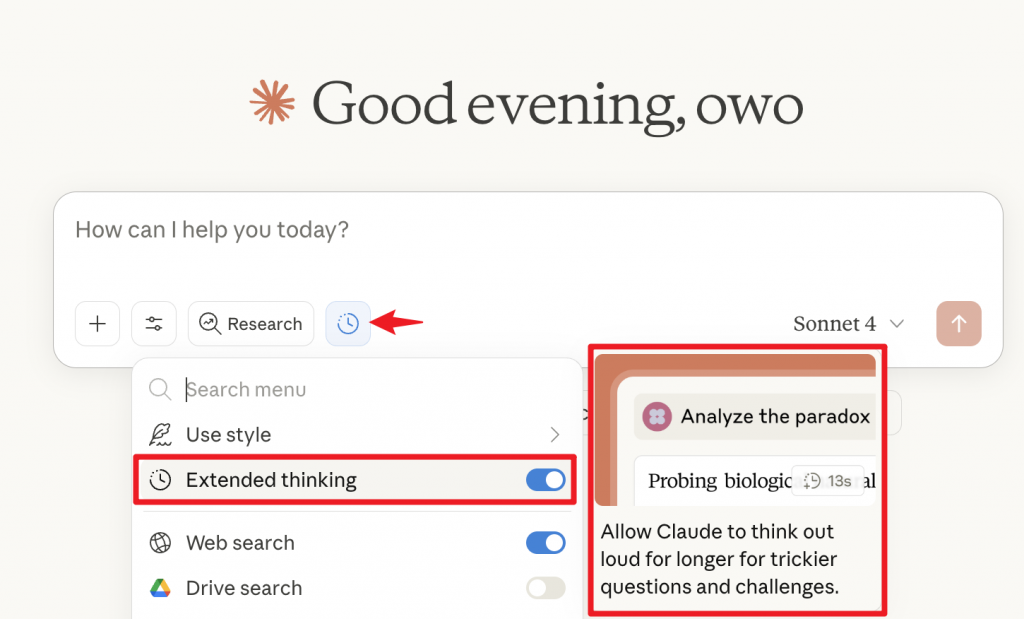

在對話框中開啟「Extended thinking」,就可以讓模型思考更久了

一般來說,就是需要拆解步驟的複雜問題可以使用。但因為 Claude 其實對於不同問題適合思考的深度判斷的蠻好的,所以我通常是「除了需要特別快速回答一些完全不需要推理步驟的問題」的時候意外,都會預設把它開啟。

在使用這些不同的 AI 工具中,對我來說很重要的一個地方是:它的思考過程是否足夠透明

都是十分會影響到使用體驗和效果的一些部分

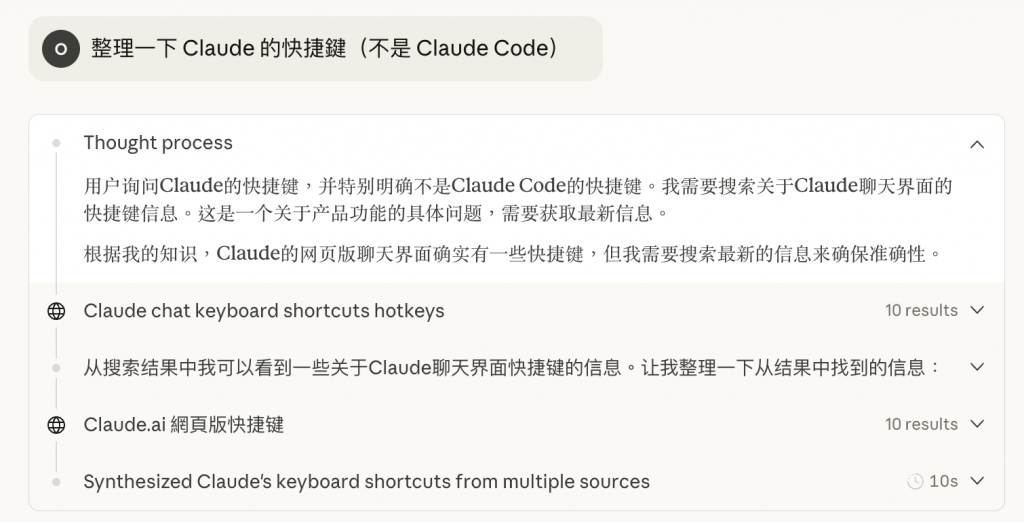

如下範例是我覺得 Claude 做的很好的原因