圖片來源:https://cdv.dei.uc.pt/projects/essys_sharing_uc?utm_source=chatgpt.com![]() # 為什麼要談「情緒」?

# 為什麼要談「情緒」?

我們每天在社群媒體上發文、留言,這些文字裡藏著情緒。喜悅、期待、憤怒、悲傷……雖然是虛擬的字句,但卻反映了城市或社群的真實氛圍。

那麼,如果我們能把這些情緒**「轉換成可以看見、聽見的東西」**,會是什麼體驗?

葡萄牙科英布拉大學(University of Coimbra)的 CDV 實驗室 就用一個作品來回答這個問題——它的名字叫 ESSYS Sharing #UC。

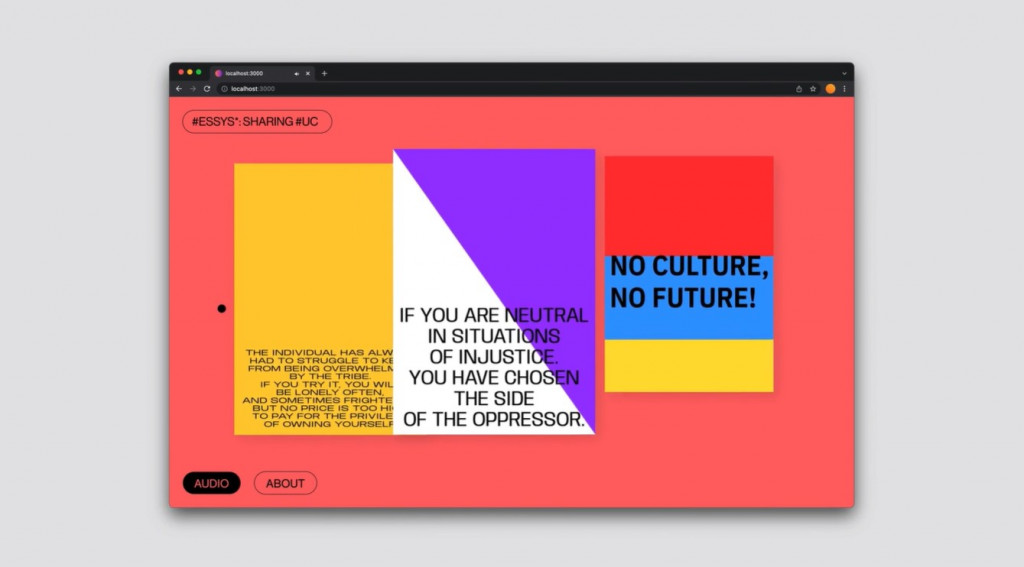

ESSYS* Sharing #UC 是一個 視聽裝置(audiovisual installation),它的靈感來自於一個問題:

「我們能不能把一座城市的情緒,用影像和聲音即時呈現?」

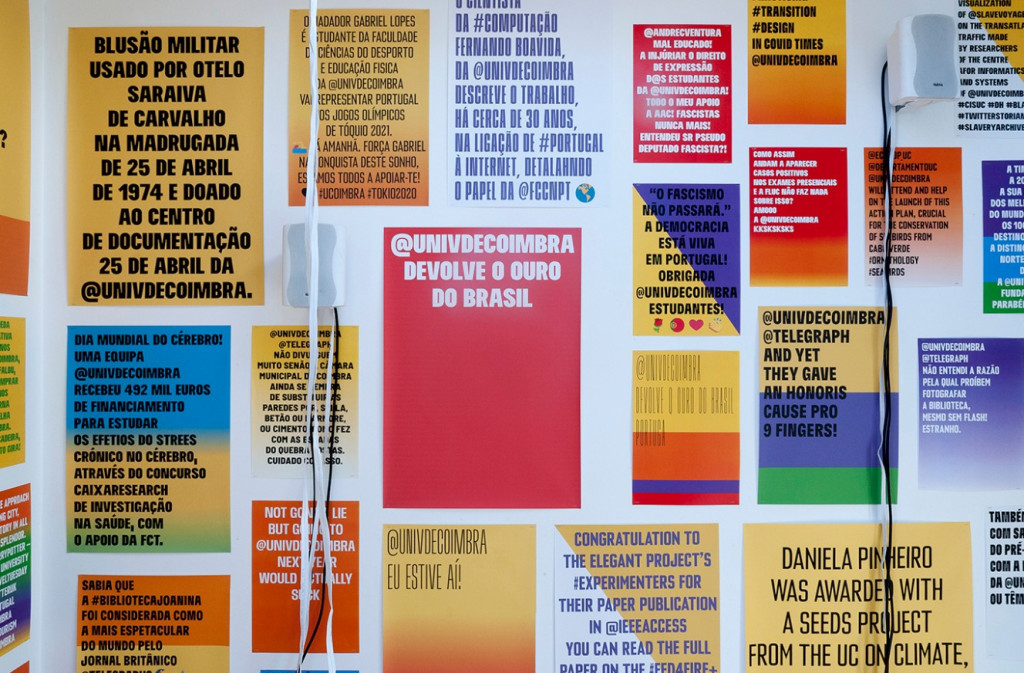

設計團隊的做法是,從 Twitter 上抓取關於科英布拉與科英布拉大學的推文,再用 NLP(自然語言處理)模型 判斷每則推文的情緒屬性,像是:喜悅、期待、信任、恐懼、憤怒、厭惡、驚訝、悲傷。

系統接著會做兩件事:

*** 生成海報**

背景顏色、漸層、字體都隨著情緒而變化。

例如:若推文帶有「憤怒」色彩,海報的色調可能偏紅;若是「悲傷」,可能呈現冷色系。

排版並不是隨機的,而是遵循一組排字規則,確保海報既能讀懂文字,也能表達情緒氛圍。

*** 生成聲音**

系統同時生成 MIDI 音樂,透過規則與機率控制旋律與和聲。

當推文情緒偏「緊張」,聲音會更尖銳、密集;當偏「平靜」,則音樂趨於和緩。

最終,觀眾在展場裡看到的是一面不斷更新的「情緒海報牆」,並在環境音中感受到當下社群氛圍。這就是所謂的「城市情緒的即時投影」。

如果從技術角度來看,整個系統大致可以拆成三個模組:

輸入與情緒分類

使用 NLP 神經網路,把文字分類到普魯奇克情緒模型(Plutchik’s Wheel of Emotions)中的八種基本情緒。

排字模組

利用「貪婪演算法」決定文字在海報上的位置。

顏色、字體來自預設規則與隨機組合,與情緒結果對應。

聲音生成模組(ESSYS)

基於規則的音樂系統,根據不同情緒,調整旋律與音色。

ESSYS* Sharing #UC 的價值不只是「藝術展示」,它還帶來一些啟發:

跨領域融合

NLP + 排版設計 + 音樂生成 + 視覺互動,這是一個完整的跨域應用範例。

資料如何轉化為感官體驗

文字情緒 → 視覺色彩、字型、聲音,這是一條「資料到感知」的鏈條,非常適合給互動設計或新媒體創作者參考。

城市情緒的映射

作品不是針對個人,而是針對一個城市、一所大學的「群體情緒」。這個概念可以延伸到智慧城市、社會觀察或公民參與領域。

ESSYS* Sharing #UC 告訴我們:情緒不是只能被寫在文字裡,它也能被「看到、聽到」。當我們把情緒計算(Affective Computing)與生成藝術結合,原本冷冰冰的數據,會轉換成有溫度、有氛圍的互動體驗。

這不僅是一次技術實驗,也是一種提醒:數位世界的情緒,終究還是屬於人類共同的感受。